Von physischen Kabeln zu logischen Strukturen

Netzwerke sind seit jeher ein Spiegel ihrer Zeit, sie passen sich den Anforderungen von Benutzer:innen, Applikationen und Unternehmensstrukturen an. Während früher ein Kabel von A nach B reichte, um Kommunikation zu ermöglichen, sind heutige Netzwerke hochdynamische, logisch segmentierte Strukturen.

Die Segmentierung steht dabei im Zentrum:

- Sie sorgt für Sicherheit, indem sensible Systeme voneinander getrennt werden

- Sie verbessert die Skalierbarkeit, indem Broadcast-Verkehr lokal bleibt

- Sie steigert die Performance, weil Ressourcen effizienter genutzt werden

In der Praxis bedeutet das: Wer Netzwerke baut, denkt nicht mehr nur in Kabeln, sondern in logischen Einheiten: Broadcast-Domänen, VLANs, Overlay-Netzen.

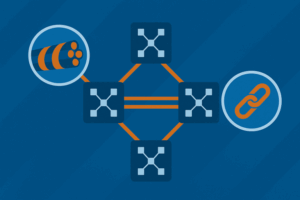

Einordnung: Von VLAN bis VXLAN

Cisco-Technologien wie VLAN, VTP, Inter-VLAN-Routing oder VXLAN haben diese Entwicklung maßgeblich geprägt. Sie stehen dabei nicht isoliert, sondern bilden aufeinander aufbauende Evolutionsstufen:

- VLAN als Grundbaustein jeder modernen Segmentierung

- VTP als zentrales Verwaltungswerkzeug, mit Chancen und Risiken

- L3-Switching als Brücke zwischen den Segmenten

- VXLAN als Overlay-Technologie für Cloud und Rechenzentrum, skaliert auf Millionen Segmente

Exkurs: Von Design Follows Function zu Function Follows Design

Wer heute mit VLANs arbeitet, vergisst leicht, dass es eine Zeit vor ihrer Erfindung gab. Damals galt das Prinzip Design follows Function:

- Sollte eine bestimmte Abteilung miteinander kommunizieren, musste man physisch Kabel verlegen, um die Geräte in derselben Broadcast-Domäne zu vereinen

- Jede Veränderung, etwa ein Umzug der Marketing-Abteilung in ein anderes Stockwerk, bedeutete, dass Kabelwege angepasst und Switches neu verschaltet werden mussten

- Das physische Design des Netzwerks war also abhängig von den Kommunikationsanforderungen, egal, wie aufwendig oder teuer die Umsetzung war

Mit der Einführung von VLANs begann ein Paradigmenwechsel:

- Über Trunks und VLAN-Tags (802.1Q) konnte eine Broadcast-Domäne virtuell dorthin geschaltet werden, wo sie benötigt wurde, unabhängig von der physischen Topologie

- Das Prinzip drehte sich um: Function follows Design – Netzwerke können heute zentral, standardisiert und skalierbar aufgebaut werden, während die logische Segmentierung flexibel zugewiesen wird

Und dieser Wandel geht weiter:

- Mit VXLAN wird die Segmentierung nicht mehr nur lokal im Campus begrenzt, sondern weltweit über Overlay-Technologien verteilt

- Standards wie RFC 9014 (DCI-EVPN Overlay) und die Entwürfe zu EVPN-Multi-Site zeigen, dass Segmentierung heute nicht mehr an ein einzelnes Rechenzentrum gebunden ist

- Damit wird endgültig klar: Netzwerke sind nicht mehr Kabelarchitekturen, sondern logische Fabrics, die von der Applikationsebene bis in die Cloud reichen

Dieses Verständnis ist entscheidend, um die folgenden Technologien – VLAN, VTP, Inter-VLAN-Routing und VXLAN – nicht isoliert, sondern als Teil einer Entwicklungslinie zu sehen.

VLAN: das Fundament der Segmentierung

VLANs sind seit Jahrzehnten der Standard, wenn es darum geht, Netzwerke logisch zu strukturieren und dadurch Sicherheit, Effizienz und Flexibilität zu erhöhen. Sie bilden die Grundlage, auf der spätere Konzepte wie VTP, Inter-VLAN-Routing oder VXLAN aufbauen.

Ein zentrales Konzept dabei ist die Broadcast-Domäne. Sie beschreibt den Bereich im Netzwerk, in dem ein Broadcast-Frame, etwa ein ARP-Request, von allen Geräten empfangen wird. Ohne Segmentierung umfasst eine Broadcast-Domäne oft das gesamte Layer-2-Netz. VLANs ermöglichen es, diesen Bereich gezielt zu begrenzen und so Last und Risiken zu reduzieren.

Was ist ein VLAN?

Ein Virtual Local Area Network (VLAN) trennt ein physisches Netzwerk auf Layer 2 in mehrere logische Broadcast-Domänen. Jedes VLAN bildet somit sein eigenes, abgeschottetes logisches Netz, unabhängig davon, wie die Geräte tatsächlich verkabelt sind.

Beispiel:

- VLAN 10 → Mitarbeiter:innen

- VLAN 20 → Gäste

- VLAN 30 → Server

Ein Switch behandelt jedes VLAN wie ein separates Netzwerk. Broadcast-Frames aus VLAN 10 erreichen nur Geräte innerhalb dieses VLANs und nicht die in VLAN 20 oder VLAN 30. Auf diese Weise lassen sich Netzwerke sicherer, skalierbarer und effizienter betreiben.

Untagged Frames und Access-Ports

Die Konfiguration und der Betrieb von VLANs sind zunächst ein rein Switch-interner Prozess. VLANs werden in der Switch-Konfiguration definiert und erhalten eine eindeutige numerische ID sowie optional einen Namen.

Trifft ein untagged Frame auf einem Switchport ein, prüft der Switch nicht auf VLAN-Informationen im Frame. Stattdessen ordnet er den eingehenden Frame automatisch dem VLAN zu, dass diesem Port fest zugewiesen ist. In der Cisco-Welt spricht man in diesem Zusammenhang von einem Access-Port.

Diese interne Logik macht VLANs im ersten Schritt unabhängig von der Kommunikation mit anderen Switches, die Segmentierung funktioniert zunächst vollständig lokal.

Kommunikation zwischen Switches

Wenn mehrere Switches VLAN-Informationen untereinander austauschen müssen, reicht diese lokale Logik nicht mehr aus.

Eine theoretische Möglichkeit wäre, für jedes VLAN eine eigene Verbindung zwischen den Switches einzurichten. Jeder Switch könnte dazu dedizierte Access-Ports in den jeweiligen VLANs verwenden. Interessant ist dabei, dass die VLAN-IDs auf beiden Seiten nicht einmal übereinstimmen müssen: Ein Switch könnte VLAN 20 verwenden, der andere VLAN 80, und dennoch wäre die Kommunikation möglich.

Im praktischen Betrieb ist dieses Verfahren jedoch völlig unpraktikabel. Die benötigte Portdichte würde bereits bei wenigen VLANs an ihre Grenzen stoßen, die Verwaltung insgesamt wäre fehleranfällig. Hier setzen standardisierte Tagging-Mechanismen an.

Exkurs: Über Trunks und EtherChannel

Wenn es um die Verbindung mehrerer Switches geht, fällt im Cisco-Umfeld schnell der Begriff Trunk. Gemeint ist damit ein Port, der in der Lage ist, Frames aus mehreren VLANs gleichzeitig zu transportieren. Cisco verwendet dafür den Begriff Trunk-Port. Wichtig ist: Ein Trunk hat nichts mit Redundanz oder Bündelung mehrerer Leitungen zu tun, er beschreibt ausschließlich die Fähigkeit, VLAN-Tags zu verarbeiten.

Andere Hersteller nutzen den Begriff Trunk teilweise anders und beziehen ihn auch auf Link Aggregation. Dadurch kommt es häufig zu Verwirrung, da Trunk bei Cisco und Trunk in der IEEE-Welt nicht zwingend das Gleiche bedeuten.

EtherChannel und Link Aggregation

Sollen mehrere physische Leitungen zwischen zwei Switches parallel betrieben werden, kommt bei Cisco EtherChannel zum Einsatz. Dabei werden mehrere Ports zu einem logischen Link zusammengefasst. Die Steuerung erfolgt durch Protokolle wie:

- PAgP (Port Aggregation Protocol): Cisco-proprietär, heute vor allem in Legacy-Umgebungen zu finden

- LACP (Link Aggregation Control Protocol): Standard nach IEEE 802.3ad, interoperabel mit anderen Herstellern und heute Best Practice

EtherChannel sorgt für höhere Bandbreite und Redundanz: Fällt ein Link aus, bleibt der logische Kanal funktionsfähig, solange noch mindestens ein Port aktiv ist.

Abgrenzung von Begriffen

Damit lassen sich die Begriffe sauber trennen:

- Access-Port: gehört zu genau einem VLAN, transportiert untagged Frames

- Trunk-Port: transportiert mehrere VLANs über ein einziges Kabel und arbeitet mit VLAN-Tagging (802.1Q)

- EtherChannel: fasst mehrere physische Links zu einem logischen Kanal zusammen, kann sowohl Access- als auch Trunk-Konfiguration tragen

Damit wird deutlich: Während Trunks und VLAN-Tagging die logische Segmentierung zwischen Switches abbilden, dient EtherChannel der Bündelung physischer Ressourcen. In vielen Designs treten beide Konzepte gemeinsam auf: Ein EtherChannel wird als Trunk konfiguriert und transportiert so mehrere VLANs parallel über mehrere gebündelte Leitungen.

Standardisierte Lösung: 802.1Q und ISL

Die elegante Lösung für die Inter-Switch-Kommunikation ist das Einfügen von VLAN-Informationen direkt in den Ethernet-Frame. In der Cisco-Welt werden dafür traditionell zwei Verfahren genannt: IEEE 802.1Q und ISL.

IEEE 802.1Q – der Standard

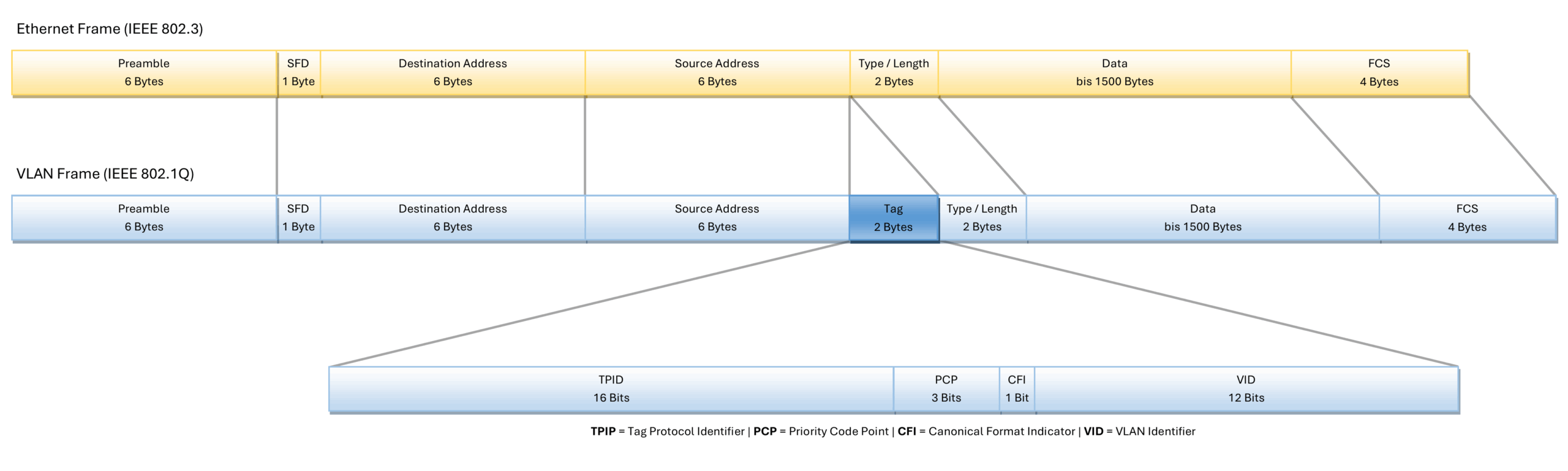

Der am weitesten verbreitete Ansatz ist IEEE 802.1Q. Dabei wird ein 4 Byte Tag zwischen Quell-MAC-Adresse und EtherType-Feld in den Ethernet-Frame eingefügt. Dieses Tag enthält:

- die VLAN-ID (12 Bit, bis zu 4096 VLANs)

- die Priority Code Point (PCP) für Quality of Service

- das Canonical Format Indicator (CFI)-Bit

Durch das Einfügen verlängert sich der Frame um 4 Bytes. Damit Frames mit VLAN-Tag nicht als fehlerhaft erkannt werden, wurde der Ethernet-Standard mit IEEE 802.3ac erweitert. Dieser definiert explizit, dass Frames mit bis zu 1522 Bytes gültig sind, wenn sie ein VLAN-Tag enthalten.

Ein technisches Detail ist entscheidend: Das Hinzufügen des VLAN-Tags macht die ursprüngliche Frame Check Sequence (FCS) am Ende des Ethernet-Frames ungültig. Der Switch berechnet daher die Prüfsumme neu, bevor er den Frame weiterleitet. Dieser Vorgang geschieht transparent, Endgeräte bemerken davon nichts.

Ein untagged Frame, der über einen 802.1Q-Trunk-Port eintrifft, wird dem sogenannten Native VLAN zugeordnet. Standardmäßig ist dies VLAN 1. Best Practices empfehlen jedoch, ein anderes VLAN zu verwenden, um Angriffe wie VLAN Hopping zu vermeiden.

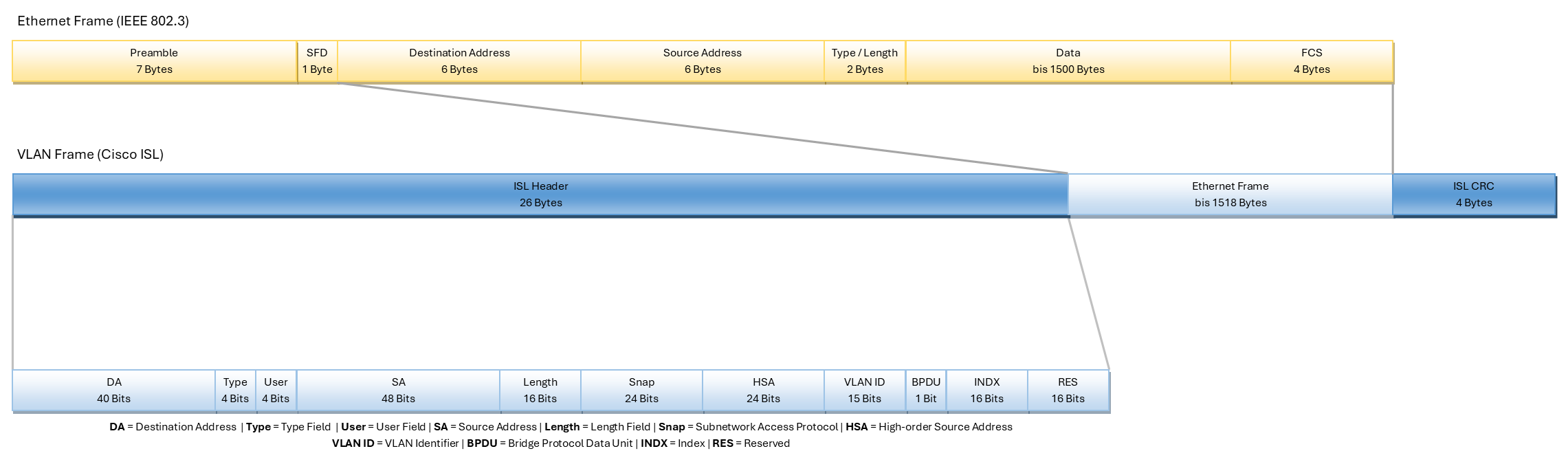

Cisco ISL – der Vorläufer

Vor der Standardisierung von 802.1Q entwickelte Cisco das proprietäre Inter-Switch Link (ISL) Protokoll. Dabei wird der gesamte Ethernet-Frame in einen neuen Header (26 Bytes) und Trailer (4 Bytes) gekapselt. Dadurch vergrößert sich der Frame um insgesamt 30 Bytes.

Die VLAN-Identifikation erfolgt über eine 10 Bit ID, womit maximal 1024 VLANs unterstützt werden. Der Vorteil war eine enge Integration in Cisco-Switches, der Nachteil die fehlende Interoperabilität mit anderen Herstellern.

ISL ist in modernen Cisco-Switches nicht mehr verfügbar, bleibt aber ein wichtiger historischer Zwischenschritt und wird im CCNA-Kontext weiterhin erwähnt.

Praxisvergleich 802.1Q vs. ISL

Um die Unterschiede einzuordnen, lohnt sich ein Blick auf beide Verfahren:

- 1Q ist heute der gültige Standard, fest in IEEE 802.3ac definiert und herstellerübergreifend kompatibel

- ISL war ein proprietäres Cisco-Protokoll, das inzwischen abgelöst ist und nur noch in Legacy-Umgebungen oder Prüfungsfragen vorkommt

- Für den produktiven Betrieb im Enterprise- oder Datacenter-Umfeld ist somit allein 1Q in Kombination mit IEEE 802.3ac relevant

Vorteile von VLANs

Der Einsatz von VLANs bringt eine Vielzahl von Vorteilen mit sich und ist bis heute ein zentrales Werkzeug im Netzwerkdesign. Sie ermöglichen Administrator:innen, Netzwerke logisch zu strukturieren, ohne dass physische Topologien angepasst werden müssen. Damit sind VLANs gleichermaßen interessant für kleine Unternehmensnetze, die Ordnung und Sicherheit schaffen möchten, wie auch für große Rechenzentrumsumgebungen, in denen Flexibilität und Skalierbarkeit entscheidend sind.

VLANs leisten dabei einen wichtigen Beitrag in verschiedenen Dimensionen:

- Erhöhte Sicherheit: VLANs erhöhen die Sicherheit. Da Broadcast-Frames nur innerhalb eines VLANs sichtbar sind, können Fehlkonfigurationen oder Angriffe nicht ohne Weiteres auf das gesamte Layer 2 Netz überspringen.

- Hohe Flexibilität: Sie bieten Flexibilität im Netzwerkdesign. Geräte können unabhängig vom physischen Standort einem VLAN zugeordnet werden. Zieht ein:e Mitarbeiter:in um, muss nicht neu verkabelt werden, eine VLAN-Konfiguration reicht aus.

- Klare Segmentierung: VLANs ermöglichen die saubere Trennung in mehrere Broadcast-Domänen. Jede Abteilung oder jedes System kann in eine eigene logische Einheit verschoben werden, ohne zusätzliche Hardware zu benötigen.

- Optimierte Performance: Durch die Begrenzung von Broadcast-Domänen wird unnötiger Broadcast-Traffic reduziert, was Switches und Endgeräte entlastet und die Performance verbessert.

- Organisatorische Abbildung: Durch die logische Segmentierung lassen sich Netzwerke flexibel nach organisatorischen, sicherheitsrelevanten oder technischen Kriterien aufteilen. Ein klassisches Beispiel ist die Trennung von Mitarbeiter:innen-, Gäste- und Server-Netzen.

Grenzen von VLANs

So nützlich VLANs im täglichen Betrieb sind, sie stoßen in komplexeren Umgebungen auch an ihre natürlichen Grenzen. Gerade wenn Netze größer werden oder sich Anforderungen ändern, reichen die Möglichkeiten von VLANs oft nicht mehr aus. Die wichtigsten Einschränkungen sind:

- Begrenzte Isolation: VLANs trennen nur auf Layer 2. Für umfassendere Sicherheitsanforderungen (z.B. mandantenfähige Architekturen oder Zero Trust Modelle) sind zusätzliche Mechanismen wie VRFs oder Firewalls erforderlich.

- Begrenzte Skalierbarkeit: VLAN-IDs sind auf 4096 begrenzt (12 Bit im IEEE 802.1Q-Tag). Für sehr große Umgebungen, etwa in Cloud- oder Service-Provider-Netzen, reicht dieser Adressraum nicht aus.

- Broadcast- und Multicast-Belastung: Auch wenn VLANs Broadcast-Domänen einschränken, können sie diese nicht vollständig eliminieren. Bei hoher Teilnehmerzahl bleibt Broadcast-Traffic ein Problem.

- Eingeschränkte Flexibilität über Standorte hinweg: VLANs sind primär für Layer 2 Domänen gedacht. Das bedeutet, dass sie sich nur schwer über mehrere Rechenzentren oder geografisch getrennte Standorte hinweg spannen lassen.

- Komplexität im Management: Je größer die Zahl der VLANs wird, desto aufwendiger wird die Verwaltung der Konfigurationen über viele Switches hinweg. Fehler bei der VLAN-Zuweisung oder Trunk-Konfiguration sind eine häufige Ursache für Störungen.

- Limitierte Mobilität von Workloads: Virtuelle Maschinen oder Container, die zwischen Hosts verschoben werden, erfordern konsistente VLAN-Konfigurationen. Dies erschwert dynamische Szenarien wie Cloud-Bursting oder Microservices-Architekturen.

Damit wird deutlich: VLANs sind das unverzichtbare Fundament moderner Segmentierung und definieren die Größe sowie die Reichweite einer Broadcast-Domäne. Für hochskalierende und flexible Netzwerke reichen ihre Möglichkeiten jedoch nicht mehr aus – hier kommen dynamische Konzepte und Overlay-Technologien wie VXLAN ins Spiel.

Dynamische VLAN-Zuweisung

Während VLANs in ihrer Standardform meist statisch konfiguriert werden – ein Port gehört fix zu einem VLAN – gibt es auch Verfahren zur dynamischen Zuweisung. Ziel ist es, Geräte oder Benutzer:innen automatisch in das passende VLAN einzuordnen, ohne dass Administrator:innen jeden Switchport manuell konfigurieren müssen.

Klassische statische VLAN-Zuweisung

In der einfachsten Form wird ein Port auf einem Switch fest einem VLAN zugewiesen:

Switch(config)# interface fastEthernet 0/1 Switch(config-if)# switchport mode access Switch(config-if)# switchport access vlan 10

Damit gehört der Port dauerhaft zu VLAN 10 und unabhängig davon, welches Gerät angeschlossen wird, landet es automatisch in diesem VLAN. Diese Methode ist zwar einfach und zuverlässig, wird in großen Netzen aber schnell unflexibel.

VMPS: dynamische VLANs per MAC-Adresse

Ein früher Cisco-Ansatz war der VLAN Membership Policy Server (VMPS). Dabei entscheidet ein zentraler Server, welchem VLAN ein Gerät zugeordnet wird. Grundlage ist die MAC-Adresse des Geräts:

- Trifft ein unbekannter Frame auf einem dynamisch konfigurierten Port ein, sendet der Switch eine Anfrage (VQP, VLAN Query Protocol) an den VMPS

- Der VMPS prüft die Datenbank und teilt dem Switch mit, zu welchem VLAN der Port gehören soll

- In secure mode kann der VMPS den Port sogar blockieren, wenn eine nicht zugelassene MAC-Adresse auftaucht

Dieses Verfahren war für seine Zeit innovativ, erwies sich aber als unflexibel und unsicher. Dabei treten u.a. die folgenden Einschränkungen auf:

- Ports im Trunk-Modus konnten nicht dynamisch betrieben werden

- 1X und VMPS schlossen sich gegenseitig aus

- Mehr als 20 aktive Hosts pro Port führten zum Abschalten des Ports

Aus heutiger Sicht ist VMPS ein Legacy-Ansatz, der fast nur noch in alten Prüfungsfragen oder historischen Kontexten eine Rolle spielt.

Moderne Ansätze: 802.1X und RADIUS

Heute gilt die Kombination aus IEEE 802.1X und RADIUS als Best Practice für dynamische VLAN-Zuweisung. Dabei authentifiziert sich ein Gerät oder ein:e Benutzer:in beim Switch, der die Anfrage an einen RADIUS-Server wie Cisco ISE oder Microsoft NPS weiterleitet.

- Je nach Rolle oder Gerätetyp weist der Server das passende VLAN zu

- Typische Szenarien:

- Mitarbeiter:innen erhalten Zugriff auf das interne Produktionsnetz

- Gäste werden automatisch in ein isoliertes Gäste-VLAN verschoben

- IoT-Geräte landen in einem restriktiven VLAN mit begrenzten Rechten

Dieser Ansatz bietet hohe Flexibilität, ist sicherer als VMPS und unterstützt moderne Konzepte wie Network Access Control (NAC).

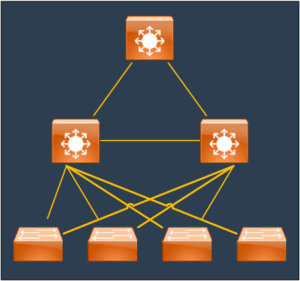

Exkurs: Cisco SDA und DNA im Detail

Cisco Software Defined Access (SDA) stellt einen Paradigmenwechsel dar: Die Segmentierung orientiert sich nicht mehr am physischen Port oder an der VLAN-ID, sondern an der Identität von Benutzer:innen und Geräten. SDA trennt die Netzwerkschichten in Underlay, Overlay und Policy Layer und entkoppelt damit die physische Infrastruktur von der logischen Segmentierung. Die zentrale Steuerung erfolgt über Cisco DNA (Digital Network Architecture) Center in Kombination mit Cisco ISE (Identity Services Engine).

Architektur und Rollen in der Fabric

Eine SDA-Fabric besteht aus unterschiedlichen Knotenrollen, die klar voneinander getrennt sind. Edge Nodes stellen die Access-Switches dar, an denen Endgeräte oder Access Points angeschlossen werden. Sie bieten den Endgeräten ein Anycast Gateway, sodass ein Host bei einem Standortwechsel immer dasselbe Default Gateway behält. Control Plane Nodes speichern und verwalten die Zuordnung von Endpunkt-Identitäten (Endpoint Identifier, EID) zu den Lokatoren im Netz (Routing Locator, RLOC). Dies geschieht auf Basis des Locator / ID Separation Protocol (LISP). Border Nodes dienen als Übergangspunkte zu anderen Netzen, zum Beispiel ins WAN oder in das Datacenter. Sie führen das Handoff der Virtual Routing and Forwarding-Instanzen (VRFs) durch. Intermediate Nodes übernehmen die reine IP-Weiterleitung im Underlay, während Fabric Wireless LAN Controller (WLC) die Integration von WLAN-Clients in die Fabric übernehmen.

Underlay und Overlay

Das Underlay ist ein IP-basiertes Transportnetz, das typischerweise mit OSPF oder IS-IS aufgebaut wird. Es stellt die reine IP-Konnektivität zwischen allen Fabric-Knoten sicher. Das Overlay basiert auf VXLAN und kapselt den eigentlichen Datenverkehr. Jeder logische Kontext, also ein Virtual Network (VN), wird durch eine eigene VN-ID und eine eigene VRF dargestellt. Damit lassen sich Mandanten oder große organisatorische Bereiche sauber voneinander trennen. Die Control Plane basiert auf LISP, das die Abbildung von Endpunkt-Identität (EID) zu Routing Locator (RLOC) vornimmt. Durch diese Architektur wird Host-Mobilität möglich, ohne dass VLANs zwischen den Switches verschoben oder neu zugewiesen werden müssen.

Identität und Richtlinien

Ein zentrales Element von SDA ist die Policy-Ebene, die unabhängig vom physischen Standort greift. Auf der Ebene der Makro-Segmentierung kommen Virtual Networks (VN) zum Einsatz, die jeweils einer eigenen VRF entsprechen. Innerhalb eines VN können wiederum Security Group Tags (SGT) verwendet werden, um eine Mikro-Segmentierung zu realisieren. Der Zugriff zwischen SGTs wird durch Security Group Access Control Lists (SGACLs) definiert. Diese Architektur ermöglicht es, Kommunikationsbeziehungen unabhängig von IP-Adressbereichen oder VLAN-Zuweisungen zu steuern. Policies werden in DNA Center modelliert und über Cisco ISE auf Basis der Benutzer- oder Geräteidentität dynamisch angewendet.

Onboarding von Endgeräten

Das Onboarding von Endgeräten erfolgt in der Regel über IEEE 802.1X. Unterstützt ein Gerät keine 802.1X-Authentifizierung, kann auf MAC Authentication Bypass (MAB) oder Web Authentication zurückgegriffen werden. Nach erfolgreicher Authentifizierung liefert Cisco ISE nicht nur die Freigabe, sondern auch Kontextinformationen wie das zugewiesene Virtual Network, den passenden IP-Pool und die Security Group Tags. Damit können zwei Endgeräte am selben Access-Port unterschiedliche VLANs, VRFs und Policies erhalten, ohne dass der Port neu konfiguriert werden muss. Dies erhöht die Flexibilität erheblich und macht die Netzwerkkonfiguration identitätsbasiert.

Multi Site Design und Transit

SDA ist nicht auf einen einzelnen Standort beschränkt. Über SD-Access Transit oder IP-Transit-Mechanismen können mehrere Fabrics miteinander verbunden werden. Dabei übernehmen Border Nodes die Rolle des Übergangs zwischen den Sites. Externe Kommunikation kann über Default Border Nodes in Richtung WAN oder Internet erfolgen, während Fusion Router oder Firewalls die Inter-VRF-Kommunikation und Policy-Durchsetzung außerhalb der Fabric übernehmen. So lassen sich Mandanten- und Sicherheitsrichtlinien auch über geografisch verteilte Netze hinweg konsistent durchsetzen.

Wireless-Integration

Ein wesentlicher Vorteil von SDA ist die nahtlose Integration von Wireless Clients. Access Points, die als Fabric-APs betrieben werden, tunneln den Datenverkehr ihrer Clients direkt in die Fabric. Dadurch gelten für kabelgebundene und drahtlose Endgeräte dieselben Richtlinien, Segmente und Security Group Tags. Durch das Anycast Gateway erleben Clients nahtloses Roaming, da ihre IP-Adressierung unabhängig vom Standort erhalten bleibt.

Betrieb und Best Practices

Im Betrieb unterstützt DNA Assurance die Fehleranalyse und liefert umfassende Transparenz über den Datenpfad, die Endgeräte und die Policy-Anwendung. Für ein ausfallsicheres Design empfiehlt Cisco mindestens zwei Control-Plane Nodes und zwei Border Nodes pro Fabric-Site. Bei der Planung gilt: Zuerst sollte die Makro-Segmentierung über Virtual Networks sauber aufgebaut werden, bevor mit Security Group Tags die Mikro-Segmentierung eingeführt wird. Policies sollten sparsam, aber klar definiert sein, um Komplexität zu vermeiden.

VTP: Vereinfachung und Risiken

Das VLAN Trunking Protocol (VTP) ist ein von Cisco entwickeltes Verfahren, um VLAN-Informationen innerhalb eines VTP-Domänenverbundes zwischen Switches auszutauschen. Statt VLANs auf jedem einzelnen Switch separat anlegen zu müssen, lassen sich diese über VTP zentral verwalten. Damit erleichtert VTP die Administration in großen Netzen, bringt jedoch auch Risiken mit sich.

Funktionsweise und Modi

Ein VTP-Domänenverbund besteht aus Switches, die denselben VTP Domain Namen und ein gemeinsames VTP Passwort nutzen. Änderungen an der VLAN-Datenbank (VLAN-Name, VLAN-ID, VLAN-Löschung) werden in Form von VTP-Advertisements über Trunk-Links verteilt. Jeder Advertisement enthält eine Konfigurationsversionsnummer. Ein Switch übernimmt immer die VLAN-Datenbank mit der höchsten Versionsnummer.

Cisco unterscheidet dabei drei Betriebsmodi:

- Server-Mode: VLANs können erstellt, geändert oder gelöscht werden. Änderungen werden an alle Switches in der VTP-Domäne verteilt.

- Client-Mode: Der Switch nimmt Änderungen entgegen und speichert sie in seiner VLAN-Datenbank, darf selbst jedoch keine VLANs anlegen oder ändern.

- Transparent-Mode: Der Switch gibt VTP-Advertisements weiter, übernimmt sie aber nicht. VLANs werden nur lokal gespeichert und verwaltet.

Vorteile

Der größte Vorteil von VTP ist die zentrale Administration. Neue VLANs müssen nicht auf jedem Switch einzeln konfiguriert werden, sondern werden automatisch in der gesamten VTP-Domäne verteilt. Dies spart Zeit und reduziert Konfigurationsfehler.

Risiken

Die größte Schwäche von VTP ist zugleich seine Stärke: Da alle Switches ihre VLAN-Datenbanken automatisch synchronisieren, kann ein Fehlkonfiguration fatale Folgen haben. Ein neu hinzugefügter Switch mit einer höheren Konfigurationsversionsnummer, aber einer leeren VLAN-Datenbank, kann sämtliche VLANs im gesamten Netzwerk löschen. Dies kann innerhalb von Sekunden zu einem Totalausfall führen.

Aus diesem Grund entscheiden sich viele Administrator:innen heute dafür, VTP im Transparent-Mode zu betreiben. VLANs werden dann manuell gepflegt, was zwar mehr Aufwand bedeutet, aber das Risiko eines ungewollten VLAN-Verlustes minimiert.

VTP Pruning: Verkehrsoptimierung oder Risiko?

Das Feature VTP Pruning wurde eingeführt, um die Effizienz von VLAN-Trunks zu erhöhen. Normalerweise werden Broadcast-, Multicast- und unbekannte Unicast-Frames auf allen Trunk-Links in alle VLANs weitergeleitet, unabhängig davon, ob ein Ziel im jeweiligen VLAN am entfernten Switch existiert. Gerade in großen Netzen kann dies zu erheblichem, unnötigem Datenverkehr führen.

Idee und Funktionsweise

Mit aktiviertem VTP Pruning wird der VLAN-Traffic auf Trunk-Links eingeschränkt:

- Ein Switch analysiert, welche VLANs an seinen Downstream-Switches tatsächlich benötigt werden

- Frames eines VLANs werden nur dann über einen Trunk weitergeleitet, wenn der Ziel-Switch mindestens einen aktiven Port in diesem VLAN besitzt

- So wird verhindert, dass unnötiger Broadcast- oder Multicast-Traffic über Links transportiert wird, auf denen es keine Empfänger gibt

Beispiel

Angenommen, Switch A betreibt die VLANs 10, 20 und 30, während Switch B nur VLAN 10 benötigt. Ohne Pruning würden Broadcast-Frames aus VLAN 20 und 30 dennoch über den Trunk zu Switch B gesendet. Mit VTP Pruning erkennt Switch A, dass Switch B VLAN 20 und 30 gar nicht nutzt und filtert diese Frames aus.

Konfiguration

Die Aktivierung von VTP Pruning ist technisch sehr einfach und wird global auf dem Switch ausgeführt. Sobald das Feature eingeschaltet ist, beginnen die Switches automatisch damit, VLAN-Listen über die Trunk-Links auszutauschen und den Datenverkehr anhand dieser Informationen einzuschränken. Administrator:innen müssen dazu keinen weiteren Eingriff auf den einzelnen Interfaces vornehmen.

Die grundlegende Konfiguration erfolgt mit nur einem Befehl:

Switch(config)# vtp pruning

Danach beginnen die Switches automatisch, VLAN-Listen für die Trunks auszutauschen und den Datenverkehr entsprechend einzuschränken.

Vorteile

Der Nutzen von VTP Pruning liegt klar auf der Hand: In Netzen mit vielen VLANs und zahlreichen Trunk-Verbindungen kann es eine erhebliche Menge an unnötigem Datenverkehr verhindern. Insbesondere Broadcast- und Multicast-Frames, die von Natur aus alle Endgeräte in einer Broadcast-Domäne erreichen sollen, müssen nicht mehr jeden möglichen Pfad im Netz passieren. Dadurch sinkt die Auslastung auf den Links, und die Effizienz des Netzwerks steigt.

Die wichtigsten Vorteile sind:

- Einsparung von Bandbreite auf Trunk-Links, da nur noch relevanter Traffic übertragen wird

- Reduktion von unnötigem Broadcast- und Multicast-Traffic, was die Netzlast insgesamt senkt

- Potenzielle Performance-Verbesserung, insbesondere in großen Netzen mit vielen VLANs und Segmenten

Risiken

So hilfreich VTP Pruning klingt, so gefährlich kann es in der Praxis sein. Da die Mechanismen automatisiert arbeiten, können fehlerhafte Informationen oder Misskonfigurationen dazu führen, dass VLANs unerwartet gekappt werden. Dadurch verlieren Hosts möglicherweise die Verbindung zu zentralen Diensten. Gerade bei VLANs, die nur an wenigen Standorten genutzt werden, kann dies schwerwiegende Auswirkungen haben.

Best Practices

Viele Administrator:innen setzen deshalb auf ein konservativeres Verfahren: Statt VTP Pruning zu aktivieren, konfigurieren sie die erlaubten VLANs auf Trunk-Links manuell.

Switch(config-if)# switchport trunk allowed vlan 10,20

Dieses Verfahren erfordert zwar mehr Handarbeit, bietet aber volle Kontrolle darüber, welche VLANs über welchen Trunk laufen.

Mit VTP Pruning zeigt sich deutlich die Ambivalenz des VTP-Protokolls: Es erleichtert die Arbeit, birgt aber gleichzeitig erhebliche Risiken. Für kritische Umgebungen gilt daher meist die Empfehlung: Lieber manuelles VLAN-Management auf Trunks als automatisierte Pruning-Mechanismen.

L3-Switching: Routing im Campus

Mit VLANs lassen sich Netzwerke logisch segmentieren. Doch sobald Kommunikation zwischen verschiedenen VLANs notwendig wird, stößt Layer 2 an seine Grenzen. Hier kommt Layer 3 Switching ins Spiel. Es verbindet die Vorteile eines klassischen Routers mit der Geschwindigkeit und Flexibilität eines Switches.

Unterschied Router vs. Layer 3 Switch

Ein Router arbeitet auf Layer 3, trennt Netze voneinander und leitet Pakete anhand ihrer IP-Informationen weiter. Ein Layer 3 Switch kombiniert diese Funktion mit der hohen Performance eines Switches, da er Routingentscheidungen im Hardware-Forwarding (z.B. über Cisco Express Forwarding, CEF) trifft.

Der Unterschied zeigt sich in der Praxis: Während ein Router klassisch Ports mit eigenen Netzen verbindet, können Layer 3 Switches sowohl Switched Virtual Interfaces (SVIs) als auch Routed Ports verwenden.

Inter-VLAN-Routing mit SVIs

Das klassische Verfahren für Kommunikation zwischen VLANs im Campus ist das Inter-VLAN-Routing über SVIs. Dabei wird für jedes VLAN ein logisches Interface auf dem Switch angelegt:

Switch(config)# interface vlan 10 Switch(config-if)# ip address 192.168.10.1 255.255.255.0 Switch(config-if)# no shutdown

Dieses Interface übernimmt die Rolle des Default Gateways für alle Geräte in VLAN 10. Für VLAN 20 oder VLAN 30 wird analog ein weiteres SVI erstellt. Der Layer 3 Switch routet den Traffic dann direkt zwischen den VLANs, ohne den Umweg über einen externen Router.

Routed Ports vs. SVIs

Neben SVIs können Layer 3 Switches auch Routed Ports bereitstellen. Dabei wird ein Port wie bei einem Router behandelt und erhält eine eigene IP-Adresse, ohne Teil einer VLAN-Switching-Domäne zu sein:

Switch(config)# interface gigabitEthernet 1/0/1 Switch(config-if)# no switchport Switch(config-if)# ip address 192.168.100.1 255.255.255.0

Während SVIs vor allem im Campus für Inter-VLAN-Routing genutzt werden, kommen Routed Ports häufig bei Core- oder Distribution-Switches zum Einsatz, wenn diese rein als Router zwischen Netzbereichen fungieren sollen.

Vorteile von L3-Switching

Der Einsatz von Layer 3 Switches ist heute Standard in Enterprise-Campus-Netzen. Sie verbinden die Flexibilität von VLAN-Segmentierung mit der Effizienz eines hochperformanten Routers. Gerade im Vergleich zu klassischen Router-on-a-Stick-Designs bietet L3-Switching deutlich mehr Geschwindigkeit und Skalierbarkeit, da die Weiterleitung der Pakete direkt im Switch-Hardwarepfad erfolgt.

Die wichtigsten Vorteile sind:

- Flexibles Design: Kombination aus SVIs und Routed Ports ermöglicht vielseitige Topologien

- Geringere Latenz: Keine externe Router-Hop notwendig, Kommunikation bleibt im Switch

- Hohe Geschwindigkeit: Routing erfolgt hardwarebasiert mit Cisco Express Forwarding (CEF)

- Integration in Campus-Architekturen: L3-Switches bilden das Rückgrat für Core- und Distribution-Layer in Enterprise-Netzen

- Skalierbarkeit: Viele VLANs lassen sich zentral über einen L3-Switch miteinander verbinden

VXLAN: Virtualisierung und Overlay

Während VLANs für Jahrzehnte die Basis der Netzwerkssegmentierung bildeten, stoßen sie in modernen Rechenzentren und Multi-Tenant-Umgebungen zunehmend an ihre Grenzen. Der Hauptgrund ist die Limitierung auf 4096 VLAN-IDs, die sich aus dem 12 Bit Feld in IEEE 802.1Q ergibt. Für große Enterprise-Netzwerke oder Service-Provider mit Tausenden von Mandanten reicht dies nicht aus. Außerdem lassen sich VLANs nur schwer über verteilte Standorte hinweg transportieren. Hier setzt Virtual Extensible LAN (VXLAN) an.

Grundlagen und Funktionsprinzip

VXLAN ist ein Overlay-Protokoll, das VLANs auf Layer 2 über ein bestehendes Layer 3 IP-Netz ausdehnt. Der eigentliche Datenverkehr wird in UDP-Pakete gekapselt, die standardmäßig den Port 4789 nutzen. Damit können Ethernet-Frames unabhängig von der physischen Netzstruktur transportiert werden.

Kernidee ist der VXLAN Network Identifier (VNI):

- Der VNI ist ein 24 Bit Feld, das bis zu 16 Millionen logische Segmente erlaubt

- Jeder VNI repräsentiert damit eine logische Broadcast-Domäne, ähnlich einem VLAN, nur deutlich skalierbarer

VXLAN wird von sogenannten VTEPs (VXLAN Tunnel Endpoints) verarbeitet. Diese Endpunkte sitzen meist auf Top-of-Rack (ToR) Switches (Leafs) oder Server-Hypervisoren und übernehmen zwei Aufgaben:

- Encapsulation: Der ursprüngliche Ethernet-Frame wird mit VXLAN-Headern und einem UDP- / IP-Header versehen

- Decapsulation: Am Ziel wird der Frame wieder entpackt und wie gewohnt im Layer-2-Segment zugestellt

Damit entsteht eine Overlay-Topologie, die völlig unabhängig von der physischen Underlay-Infrastruktur operiert.

Einsatzszenarien und Vorteile

VXLAN wurde ursprünglich für große Datacenter entworfen, ist aber inzwischen auch in Enterprise-Architekturen anzutreffen. Typische Einsatzgebiete sind:

- Skalierung in Multi-Tenant-Umgebungen: Durch die 24 Bit VNIs lassen sich Millionen logische Segmente abbilden, ausreichend für Provider und Cloud-Szenarien

- Spine-Leaf-Architekturen: VXLAN passt perfekt zu modernen Rechenzentren, in denen viele gleichberechtigte Leaf-Switches über ein redundantes Spine-Core verbunden sind

- Stretching von Netzen über Standorte hinweg: VXLAN erlaubt es, Layer 2 Segmente über Layer 3-Grenzen und geografisch verteilte Netze zu erweitern

- Integration von virtuellen und physischen Workloads: VTEPs können sowohl in Hypervisoren (ESXi, KVM) als auch in Cisco Nexus-Switches implementiert sein

Der entscheidende Vorteil: Netzwerksegmentierung wird unabhängig von der physischen Topologie. Während VLANs noch an die Switch-Infrastruktur gebunden sind, erlaubt VXLAN die flexible Abbildung logischer Segmente überall im Netz.

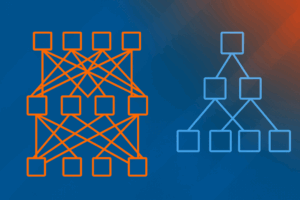

Exkurs: Spine-Leaf vs. klassisches Campus-Design

Netzwerke lassen sich nicht nur in logische Segmente unterteilen, sondern auch architektonisch unterschiedlich aufbauen. Zwei Modelle dominieren: das klassische hierarchische Modell und die moderne Spine-Leaf-Architektur.

Klassisches Core-Distribution-Access-Modell

Im Enterprise-Campus ist seit vielen Jahren ein dreistufiges Modell üblich:

- Access-Layer: Endgeräte werden an Access-Switches angebunden

- Distribution-Layer: Aggregation mehrerer Access-Switches, Richtlinien-Umsetzung und Inter-VLAN-Routing

- Core-Layer: Hochperformante Backbone-Switches verbinden die Distribution-Layer und bieten Redundanz

Diese Abbildung zeigt das klassische hierarchische Design mit Core-, Distribution- und Access-Layer. Oben befindet sich der Core, der für Redundanz und schnelle Weiterleitung sorgt, darunter die Distribution, die mehrere Access-Switches bündelt und Inter-VLAN-Routing ermöglicht. Ganz unten die Access-Switches, an die Endgeräte angeschlossen sind.

Dieses Design eignet sich hervorragend für Campus-Umgebungen mit klarer Hierarchie und berechenbaren Datenströmen. Der Datenverkehr verläuft dabei überwiegend Nord-Süd, also von den Endgeräten (Access) in Richtung Datacenter, Internet oder Serverfarm – und wieder zurück.

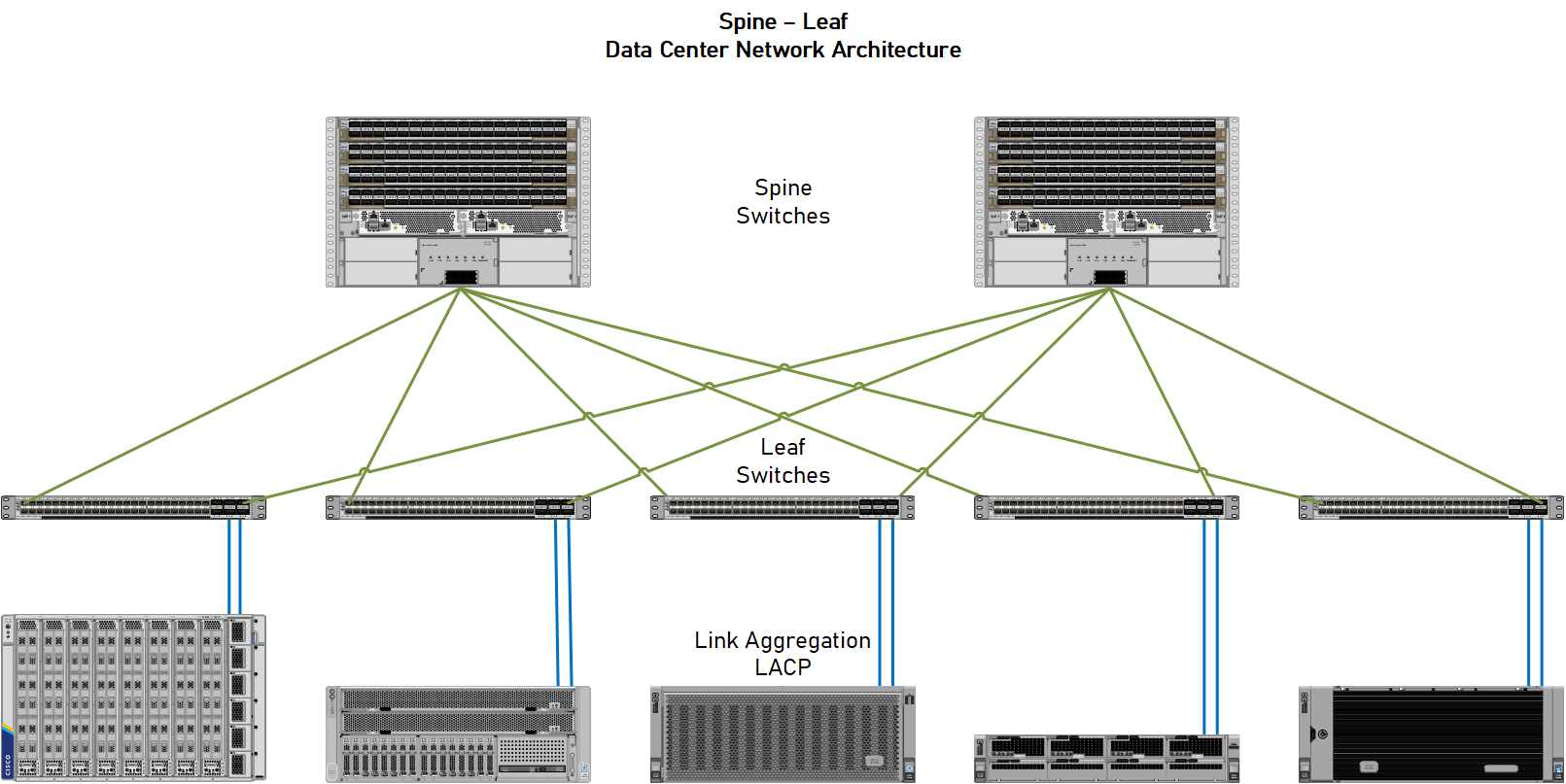

Spine-Leaf-Architektur

In modernen Rechenzentren wird dagegen meist eine Spine-Leaf-Topologie eingesetzt:

- Jeder Leaf-Switch verbindet Endgeräte oder Server (oft als Top-of-Rack-Switch)

- Jeder Leaf ist mit jedem Spine-Switch verbunden

- Alle Pfade sind gleichwertig, die Lastverteilung erfolgt über ECMP (Equal Cost Multipath Routing)

Ein Top-of-Rack-Switch (ToR-Switch) ist dabei ein Switch, der direkt im Serverrack auf oberster Ebene platziert wird und die dort installierten Server mit dem Datacenter-Netzwerk verbindet, wodurch kurze Kabelwege, einfache Verkabelung und eine klare Anbindung am Spine entsteht.

In dieser Abbildung ist die Spine-Leaf-Architektur zu sehen, wie sie in modernen Rechenzentren üblich ist. Die oberen Switches bilden die Spine-Ebene, die den Backplane-Charakter übernimmt, die unteren Switches sind die Leafs, als ToR-Switches direkt an Serverracks angebunden. Jeder Leaf ist mit jedem Spine verbunden, sodass eine vollständig vermaschte, gleichwertige Topologie entsteht.

Der Vorteil dieser Architektur liegt in der Optimierung des sogenannten Ost-West-Traffics: Damit ist die Kommunikation zwischen Servern und Diensten innerhalb des Rechenzentrums gemeint, also zwischen Workloads, die quer über viele Racks verteilt sind. Dieser Traffic ist in modernen Anwendungslandschaften mit Virtualisierung, Microservices und Containern dominierend.

Wann welches Modell?

Die Wahl zwischen klassischem Drei Schichten Design und Spine-Leaf-Architektur hängt stark von den Anforderungen und der Art des Netzwerks ab. Während im Campus vor allem Clients mit zentralen Diensten verbunden werden, stehen im Datacenter horizontale Workload-Kommunikation und Skalierbarkeit im Vordergrund. Entsprechend gilt:

- Campus- und Unternehmensnetze: Klassisches Core-Distribution-Access-Modell, da hier vor allem Nord-Süd-Traffic im Vordergrund steht – Clients greifen auf zentrale Dienste oder das Internet zu.

- Rechenzentren und Cloud-Umgebungen: Spine-Leaf-Architektur, da sie speziell für massiven Ost-West-Traffic optimiert ist, geringe Latenzen garantiert und horizontale Skalierung erlaubt.

Architekturelle Unterschiede im Detail

Ein zentrales Unterscheidungsmerkmal ist die Frage, wie Redundanz und Pfadvielfalt umgesetzt werden. Im klassischen Core-Distribution-Access-Modell sind die Distributions-Switches untereinander verbunden. Diese horizontale Kopplung stellt sicher, dass VLANs und Routinginformationen über mehrere Pfade erreichbar sind. Hier gilt das Prinzip Funktion vor Laufzeit: Das Netzwerk wird so gebaut, dass es auch bei Ausfällen die Funktionalität sicherstellt, selbst wenn zusätzliche Latenzen entstehen.

In der Spine-Leaf-Architektur ist die Logik umgekehrt. Spines sind untereinander nicht verbunden. Redundanz entsteht durch die Vielzahl gleichwertiger Pfade zwischen Leaf- und Spine-Switches. Jeder Leaf ist mit jedem Spine verbunden, und ECMP (Equal Cost Multipath Routing) verteilt den Traffic gleichmäßig auf alle verfügbaren Links. Hier gilt das Prinzip Performanz vor Funktion: Anstatt zusätzliche Layer für Redundanz einzuziehen, sorgt die schiere Anzahl paralleler Pfade für Ausfallsicherheit und hohe Bandbreite.

Damit zeichnet sich das folgende Bild ab: VLANs und L3-Switching finden ihren Platz im klassischen Campus-Modell, während VXLAN mit EVPN seine Stärken in Spine-Leaf-Fabrics und Datacenter-Architekturen ausspielt.

Control Plane: Flood & Learn vs. EVPN

In frühen Implementierungen basierte VXLAN auf einem sogenannten Flood & Learn-Mechanismus: Unbekannte MAC-Adressen wurden per Broadcast im Overlay verteilt. Dieses Verfahren ist jedoch schlecht skalierbar und in großen Netzen ineffizient.

Die moderne Lösung ist EVPN (Ethernet VPN) als Control Plane. Dabei werden MAC- und IP-Informationen zwischen VTEPs über BGP ausgetauscht. Vorteile:

- Keine Flooding-Abhängigkeit, sondern gezielter Adressenaustausch

- Skalierbare Verteilung von Endpunkt-Informationen

- Unterstützung von erweiterten Funktionen wie Anycast-Gateways und Multi-Site-Designs

EVPN hat sich als De-facto-Standard für VXLAN etabliert, insbesondere in Cisco Nexus- und Datacenter-Umgebungen.

EVPN: Ein kompakter Überblick

Ethernet VPN (EVPN) wurde als skalierbare Control Plane für VXLAN entwickelt und nutzt BGP zum Austausch von Endpunktinformationen. Damit ersetzt EVPN das ineffiziente Flood & Learn-Verfahren und ermöglicht deterministische Weiterleitung, Multihoming und die Integration von Layer 3 Funktionalität in das Overlay.

Anstelle von unkontrolliertem Broadcast-Traffic werden mit EVPN gezielt MAC- und IP-Informationen zwischen den VTEPs verteilt. Dadurch sinkt die Netzwerklast erheblich, während Skalierbarkeit und Stabilität steigen.

Die genauen Mechanismen, etwa welche Informationen EVPN verteilt und wie die verschiedenen BGP Route Types funktionieren, wird im späteren Exkurs: Auf Tuchfühlung mit VXLAN ausführlich erläutert.

Cisco-Praxis: VXLAN im Nexus-Umfeld

Cisco hat VXLAN in seine Nexus 9000-Switches integriert und bietet mit NX-OS eine breite Implementierung:

- Anycast Gateway: Alle Leaf-Switches stellen das gleiche Default Gateway bereit. So kann ein Host innerhalb desselben VNIs beliebig zwischen Leaf-Switches wechseln, ohne dass Routing-Anpassungen nötig werden.

- Head-End Replication (HER): Alternativ zu Multicast im Underlay können VTEPs Broadcast- und Multicast-Traffic gezielt an relevante VTEPs duplizieren.

- EVPN Route Types: BGP-EVPN nutzt spezielle Route Types, um MACs (Type 2), IP-Präfixe (Type 5) und Multihoming-Informationen (Type 1, Type 4) auszutauschen.

Damit wird VXLAN zu einem vollwertigen Ersatz für klassische VLANs im Datacenter, mit massiver Skalierbarkeit, Multi-Tenant-Fähigkeit und Cloud-Integration.

Fazit

VXLAN hebt die logische Segmentierung auf ein neues Niveau. Während VLANs auf 4096 IDs limitiert sind und an die Layer 2 Infrastruktur gebunden bleiben, erlaubt VXLAN die Abbildung von Millionen virtueller Segmente über beliebige Layer 3 Netze. In Kombination mit EVPN wird das Overlay deterministisch, skalierbar und robust.

Für klassische Campus-Netze ist VXLAN oft überdimensioniert, in Rechenzentren und hybriden Multi-Cloud-Architekturen ist es jedoch die Zukunft.

Exkurs: Auf Tuchfühlung mit VXLAN

VXLAN wird häufig als VLAN mit mehr Adressen beschrieben. Doch die wahre Stärke entfaltet sich erst durch die Kombination mit einer skalierbaren Control Plane und intelligenten Mechanismen zum Umgang mit Broadcast-, Unknown-Unicast- und Multicast-Verkehr. Wer VXLAN in der Praxis verstehen möchte, muss daher über die Grundlagen hinausblicken.

Multicast im Underlay und Head-End Replication

In den ersten VXLAN-Implementierungen setzte man auf Multicast im Underlay, um Broadcast- und unbekannten Unicast-Traffic zwischen allen relevanten VXLAN Tunnel Endpoints (VTEPs) zu verteilen. Jeder VTEP trat dazu einer Multicast-Gruppe bei, die für ein bestimmtes VNI zuständig war. Dieses Verfahren war funktional, brachte aber erhebliche Komplexität in der Planung und Konfiguration des Underlay-Netzes mit sich.

Als Alternative hat sich in vielen Designs die Head-End Replication (HER) durchgesetzt. Dabei dupliziert der sendende VTEP die Frames gezielt an alle VTEPs, die Mitglied des gleichen VNI sind. Multicast-Unterstützung im Underlay ist damit nicht mehr zwingend erforderlich. HER vereinfacht die Infrastruktur erheblich, skaliert aber nur bis zu einer bestimmten Größe, da die Rechen- und Bandbreitenlast auf den VTEPs steigt, wenn sehr viele Endpunkte beteiligt sind.

EVPN als skalierbare Control Plane

Um die Limitierungen von Flood & Learn und HER zu überwinden, wurde EVPN (Ethernet VPN) als Control Plane für VXLAN eingeführt. EVPN basiert auf BGP und ermöglicht den gezielten Austausch von Endpunktinformationen zwischen VTEPs. Damit entfällt der Bedarf, unbekannte Adressen über Broadcasts im Overlay zu lernen.

Technisch nutzt EVPN verschiedene BGP Route Types, die unterschiedliche Informationen transportieren:

- Type 2 (MAC / IP Advertisement Route): kündigt die Zuordnung einer MAC-Adresse mit optionaler IP-Adresse an. So wissen alle VTEPs, wo sich ein bestimmter Endpunkt befindet.

- Type 3 (Inclusive Multicast Ethernet Tag Route): signalisiert, welche VTEPs zu einem bestimmten VNI gehören und wie Broadcast- und Multicast-Traffic behandelt wird.

- Type 5 (IP Prefix Route): erweitert das Konzept auf Layer 3 und ermöglicht die Verteilung von IP-Präfixen im Overlay. Damit wird VXLAN nicht nur als Layer 2 Technologie genutzt, sondern auch für Overlay-Routing.

Mit EVPN wird VXLAN also von einem reinen Layer 2 Tunnelmechanismus zu einer vollwertigen Overlay-Netzarchitektur, die sowohl Layer 2 als auch Layer 3 Segmente effizient abbildet.

Designaspekte und Implikationen

Für die Architektur ergeben sich aus diesen Mechanismen klare Designentscheidungen:

- Skalierung: Head-End Replication ist für kleinere Umgebungen ausreichend. In großen Fabrics mit vielen VTEPs wird EVPN zwingend notwendig, um Flooding zu vermeiden und deterministische Steuerungsinformationen bereitzustellen.

- Redundanz: EVPN unterstützt Active / Active-Multihoming. Dadurch lassen sich Endgeräte an zwei VTEPs anbinden, ohne dass ein Spanning Tree benötigt wird. Redundanz entsteht im Overlay selbst, nicht mehr durch Blockieren von Links.

- Integration von Routing: Durch EVPN Type 5 werden IP-Präfixe ins Overlay integriert. Das ermöglicht Routing-Entscheidungen direkt innerhalb der VXLAN-Fabric und reduziert Abhängigkeiten von externen Routern.

- Zukunftssicherheit: VXLAN mit EVPN ist heute der Standard für Spine-Leaf-Architekturen in Rechenzentren. Es bildet die Grundlage für Automatisierung, Multi-Tenant-Umgebungen und Hybrid-Cloud-Integrationen.

Zusammenfassung

VXLAN ist weit mehr als eine Erweiterung klassischer VLANs. In Kombination mit EVPN wird es zu einem hochskalierbaren Overlay, das moderne Anforderungen an Flexibilität, Sicherheit und Performance erfüllt. Multicast im Underlay mag den Grundstein gelegt haben, Head-End Replication vereinfacht kleinere Designs, doch die Zukunft gehört EVPN. Damit wird VXLAN zum Herzstück moderner Datacenter- und Multi-Cloud-Architekturen.

VLAN-Sicherheit

VLANs sorgen für eine logische Trennung innerhalb eines Netzwerks. Oft wird dabei angenommen, dass VLANs per se auch eine Sicherheitsgrenze darstellen. In der Praxis ist dies jedoch nur eingeschränkt der Fall. VLANs verhindern zwar, dass Broadcast-Frames unkontrolliert das gesamte Layer 2 Netz durchfluten, sie sind aber kein vollwertiger Ersatz für Firewalls oder Access-Control-Mechanismen. Fehlerhafte Konfigurationen oder gezielte Angriffe können dazu führen, dass VLAN-Grenzen überwunden werden.

VLAN Hopping

Unter VLAN Hopping versteht man den Versuch, Frames in ein VLAN einzuschleusen, zu dem ein Angreifer eigentlich keinen Zugang hat. Zwei Methoden sind besonders relevant:

- Double Tagging: Dabei versieht der Angreifer einen Frame mit zwei VLAN-Tags. Der erste Tag wird vom Switch entfernt, der zweite bleibt bestehen. Auf diese Weise kann der Frame in ein anderes VLAN gelangen, ohne dass der Switch dies beabsichtigt.

- Switch Spoofing: Hier versucht der Angreifer, seinen Host so zu konfigurieren, dass er sich wie ein Switch verhält. Gelingt dies, kann der Switch-Port in den Trunk-Modus wechseln und der Angreifer Frames in beliebige VLANs senden.

Beide Methoden nutzen Lücken in der Konfiguration oder Standardverhalten aus, um VLAN-Grenzen zu umgehen.

Native VLAN Exploits

Bei 802.1Q-Trunks existiert das Konzept des Native VLANs. Frames, die ohne VLAN-Tag auf einem Trunk ankommen, werden automatisch diesem VLAN zugeordnet. Angreifer:innen können dies ausnutzen, indem sie gezielt ungetaggte Frames senden und so in ein Segment gelangen, zu dem sie keinen legitimen Zugang haben.

Risiken durch DTP (Dynamic Trunking Protocol)

Cisco-Switches handeln Trunk-Verbindungen über das Dynamic Trunking Protocol (DTP) automatisch aus. Ist ein Port im Modus dynamic desirable oder dynamic auto, kann er durch einen entsprechend konfigurierten Angreifer in einen Trunk verwandelt werden. Dies eröffnet potenziell Zugang zu allen VLANs, die über diesen Trunk transportiert werden.

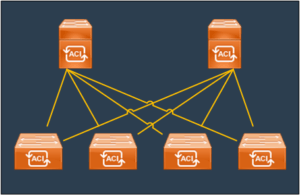

Private VLANs als Schutzmaßnahme

Ein besonderes Feature im Cisco-Umfeld sind Private VLANs (PVLANs). Sie ermöglichen es, Hosts innerhalb desselben VLANs voneinander zu isolieren. Typisches Einsatzszenario ist eine Serverfarm oder DMZ, in der zwar alle Systeme im gleichen Layer 2-Bereich liegen, aber keine direkte Kommunikation untereinander stattfinden darf. Auf diese Weise lassen sich Angriffsflächen deutlich reduzieren.

Best Practices für VLAN-Sicherheit

Die beschriebenen Angriffsszenarien machen deutlich, dass VLANs alleine kein ausreichendes Sicherheitskonzept darstellen. Administrator:innen sollten daher auf bewährte Maßnahmen zurückgreifen, um VLAN-Umgebungen abzusichern:

- DTP deaktivieren: Ports, die nicht als Trunk arbeiten sollen, konsequent auf switchport mode access setzen und DTP ausschalten

- Native VLAN ändern: VLAN 1 nicht als Native VLAN nutzen, sondern ein dediziertes VLAN zuweisen, das nicht produktiv verwendet wird

- Nur notwendige VLANs erlauben: Auf Trunk-Links gezielt VLANs freigeben, statt pauschal alle VLANs zu transportieren

- Port Security aktivieren: MAC-Adressen auf Access-Ports begrenzen und bei Unregelmäßigkeiten automatische Maßnahmen auslösen

- Private VLANs einsetzen: Für DMZs oder Serverfarmen, in denen Isolation innerhalb eines VLANs erforderlich ist

Fazit

VLANs sind ein zentrales Werkzeug der Segmentierung, bieten aber nur eingeschränkten Schutz gegen Angriffe. Erst durch konsequente Sicherheitsmaßnahmen wie das Deaktivieren von DTP, den Einsatz von Private VLANs oder die Beschränkung von VLANs auf Trunks werden VLANs zu einem belastbaren Bestandteil einer Sicherheitsarchitektur. Für umfassende Sicherheit sind sie jedoch stets in Kombination mit Firewalls, Access-Listen oder NAC-Systemen zu betrachten.

Designentscheidungen: VLAN oder VXLAN?

Die Wahl zwischen VLAN und VXLAN hängt stark vom Einsatzzweck und den Anforderungen an Skalierbarkeit, Performance und Flexibilität ab. Beide Technologien erfüllen denselben Grundgedanken der Segmentierung, unterscheiden sich jedoch erheblich in Reichweite und Möglichkeiten.

VLANs im Campus

Im klassischen Campus-Netzwerk sind VLANs nach wie vor unverzichtbar. Sie bieten eine robuste und einfache Möglichkeit, Benutzer:innen, Gäste oder Server voneinander zu trennen. In einem Core-Distribution-Access-Design sind VLANs die Basis für logische Strukturen, während das Routing zwischen den Segmenten über Layer-3-Switches erfolgt.

Besonders geeignet sind VLANs, wenn:

- Einfache Verwaltung gefragt ist: VLANs sind schnell eingerichtet und leicht zu betreiben

- Nord-Süd-Traffic dominiert, also die Kommunikation von Clients zu zentralen Diensten oder ins Internet

- Überschaubare Skalierung gegeben ist, da 4096 VLAN-IDs für die meisten Campus-Umgebungen mehr als ausreichen

Damit bleibt das VLAN das Fundament jeder Campus-Infrastruktur, das für Stabilität und Transparenz sorgt.

VXLAN im Rechenzentrum

In modernen Rechenzentren verschieben sich die Anforderungen deutlich. Hier steht Ost-West-Traffic im Vordergrund, also die Kommunikation zwischen Workloads, Containern und Services innerhalb des Datacenters. Diese Querverbindungen erfordern eine Architektur, die auf Skalierbarkeit, geringe Latenz und horizontale Erweiterbarkeit ausgelegt ist.

Hier spielt VXLAN seine Stärken aus:

- Flexibilität: Segmentierung unabhängig von der physischen Infrastruktur; logische Netze lassen sich über große Distanzen hinweg spannen

- Integration mit EVPN: VXLAN wird mit EVPN zur skalierbaren Overlay-Lösung, die sowohl Layer 2- als auch Layer 3-Segmentierung ermöglicht

- Multi-Tenant-Fähigkeit: VXLAN eignet sich für Provider- und Cloud-Umgebungen, in denen Mandanten sauber voneinander getrennt werden müssen

- Skalierbarkeit: 24 Bit VNI-Feld mit bis zu 16 Millionen Segmenten statt 4096 VLANs

Für Rechenzentren, Cloud-Architekturen und Multi-Site-Szenarien ist VXLAN damit heute Standard.

Übergangsszenarien

In der Praxis verschwinden VLANs nicht, wenn VXLAN eingeführt wird, vielmehr existieren beide Technologien nebeneinander. Häufige Übergangsszenarien sind:

- Campus mit VLANs, Datacenter mit VXLAN: Der Übergang erfolgt über Border-Switches, die VLANs in VXLAN-Segmente übersetzen

- Hybrid-Netze: VLANs bilden die lokale Basis, VXLAN erweitert diese Basis für Cloud-Anbindungen oder mandantenfähige Services

- Lokale Segmente mit VLANs, globale Segmente mit VXLAN: VLANs bleiben für lokale Broadcast-Domänen bestehen, während VXLAN Overlay-Strukturen über mehrere Standorte hinweg realisiert

Diese Koexistenz ist typisch: VLANs werden weiterhin die Access-Technologie im Campus sein, während VXLAN in Spine-Leaf-Fabrics die Grundlage für moderne Datacenter-Designs bildet.

Fazit

Die Entscheidung ist keine Frage von entweder oder, sondern von wofür und wo. VLANs sind die richtige Wahl im Campus und überall dort, wo Einfachheit und Übersichtlichkeit im Vordergrund stehen. VXLAN ergänzt VLANs in großen, verteilten Umgebungen, wo Skalierbarkeit, Mandantenfähigkeit und flexible Workload-Platzierung notwendig sind.

VLANs als Fundament, VXLAN als Zukunft

Die Geschichte der Netzwerkssegmentierung ist eine Geschichte der Evolution: von physischen Kabeln, die Broadcast-Domänen definierten, bis hin zu global verteilten Overlay-Strukturen, die völlig unabhängig von der physischen Topologie agieren.

VLANs: das bewährte Fundament

Seit ihrer Einführung sind VLANs die Basis moderner Campus-Netzwerke. Sie trennen Broadcast-Domänen, erhöhen die Sicherheit und vereinfachen das Netzwerkdesign. Trotz der Limitierung auf 4096 VLANs sind sie im Campus- und Access-Bereich unverzichtbar.

VTP: historisch relevant, heute mit Vorsicht

Das VLAN Trunking Protocol (VTP) war lange eine praktische Lösung für zentrale VLAN-Verwaltung. Heute überwiegen die Risiken: Ein fehlerhaft konfigurierter Switch kann ganze VLAN-Datenbanken überschreiben. Deshalb setzen viele Netzwerke auf den Transparent Mode. Dennoch bleibt VTP-Wissen prüfungsrelevant und in Legacy-Umgebungen wichtig.

L3-Switching: Brücke zwischen VLANs

Layer 3 Switches verbinden VLANs miteinander und übernehmen Inter-VLAN-Routing mit hoher Geschwindigkeit. Dank hardwarebasiertem Forwarding (Cisco Express Forwarding) sind sie leistungsfähiger als klassische Router-on-a-Stick-Designs. In Enterprise-Campus-Netzen bilden L3-Switches heute das Rückgrat.

VXLAN: die Zukunft im Datacenter

VXLAN überwindet die Grenzen klassischer VLANs. Mit 16 Millionen Segmenten, UDP-basiertem Overlay und EVPN als Control Plane ist es für Datacenter und Multi-Cloud-Umgebungen optimiert. VXLAN adressiert Ost-West-Traffic, ermöglicht Multi-Tenancy und passt perfekt in Spine-Leaf-Architekturen.

Sicherheit und Designfragen

Die Exkurse zu VLAN-Sicherheit und Designentscheidungen zeigen, dass VLANs und VXLAN keine Gegensätze sind. VLANs bleiben im Campus relevant, während VXLAN in Datacentern die notwendige Flexibilität bringt. In hybriden Netzen existieren beide Technologien nebeneinander, verbunden über Border-Switches oder Gateways.

Ausblick: Segmentierung für Zero Trust

Die Zukunft der Segmentierung geht über VLAN-IDs und VXLAN-Tunnel hinaus. Mit Konzepten wie Zero Trust und Microsegmentation rückt die Identität von Benutzer:innen und Geräten in den Mittelpunkt. Lösungen wie Cisco SDA verbinden VLANs und VXLANs zu einem identitätsbasierten, softwaredefinierten Gesamtkonzept.

Damit schließt sich der Kreis: VLANs bleiben das Fundament, VXLAN ist die Zukunft – beide sind unverzichtbare Bausteine moderner, sicherer und skalierbarer Netzwerke.

Quellenangaben

(Abgerufen am 10.09.2025)

Cisco Dokumentation und White Papers

- Cisco Live BRKDCN-2913: VXLAN BGP EVPN Deep Dive (PDF-Datei)

- Cisco White Paper: Migrating Classic Ethernet to VXLAN BGP EVPN

- Cisco White Paper: VXLAN with BGP EVPN Control Plane

- Cisco: Configure Port to VLAN Interface Settings on a Switch Through the CLI

- Cisco: Configuring VXLAN on Nexus 9000

RFCs und IETF Drafts

- IETF Draft: EVPN IPVPN Interworking

- IETF Draft: EVPN Multi-Site Extensions

- RFC 5517: Cisco Systems’ Private VLANs

- RFC 7432: BGP MPLS-Based Ethernet VPN

- RFC 8365: A Network Virtualization Overlay Solution using EVPN

- RFC 9014: Interconnect Solution for EVPN Overlay Networks

Weiterführende Literatur (Lern- und Prüfungsumfeld)

- Cisco Press: Building Data Centers with VXLAN BGP EVPN – A Cisco NX-OS Perspective

- Cisco Press: CCNA 200-301 Official Cert Guide, Volume 1 (2nd Edition)

Weiterlesen hier im Blog