Nach dem Hype kommt die Einordnung

Ein paar Tage sind vergangen, seit OpenAI und AMD ihre strategische Partnerschaft bekannt gegeben haben. Die erste Welle an Schlagzeilen, Kursbewegungen und Marktanalysen hat sich gelegt – Zeit also, genauer hinzusehen. Denn während die Öffentlichkeit noch über Zahlen, Gigawatt und mögliche Gewinner:innen diskutiert, zeichnet sich bereits ab, dass dieser Deal weit mehr ist als ein kurzfristiger Medienmoment.

Mit der Vereinbarung über den Aufbau von sechs Gigawatt AMD-Rechenkapazität, flankiert von OpenAIs bestehender NVIDIA-Infrastruktur mit rund zehn Gigawatt, verändert sich das Kräfteverhältnis in der weltweiten KI-Landschaft. Zum ersten Mal entsteht ein Multi-Vendor-Ansatz im industriellen Maßstab, der die bislang dominierende Position von NVIDIA spürbar herausfordert. Gleichzeitig rücken neue Akteur:innen wie Broadcom in den Fokus, die mit Netzwerktechnologien, High-Speed-Interconnects und Co-Packaged Optics das Rückgrat dieser Systeme bilden.

Doch über den technologischen Aspekt hinaus geht es um mehr: um Energie, Nachhaltigkeit und die Frage, wie weit sich Intelligenz eigentlich skalieren lässt. In meinem Beitrag Über KI, das Wachstum und warum es wahrscheinlich nicht ewig so weiter geht habe ich bereits gezeigt, dass exponentielles Wachstum in der KI-Industrie an physikalische Grenzen stößt. Die neuen Allianzen zeigen nun, wie nah diese Grenze tatsächlich ist, und wie Unternehmen versuchen, sie durch technische Innovation, wirtschaftliche Diversifizierung und energieeffizientere Architekturen hinauszuschieben.

Damit verschiebt sich der Blick von der reinen Rechenleistung hin zur Infrastruktur der Zukunft. Es geht nicht mehr nur um GPUs und Modelle, sondern um die Systeme, Netze und Energiestrukturen, die sie am Laufen halten – und um die Verantwortung, die daraus entsteht.

Exkurs: OpenAI – Die Geburt eines Giganten

Von der Forschungsidee zur globalen Mission

Um zu verstehen, warum der aktuelle Deal zwischen OpenAI und AMD mehr ist als eine weitere Technologiepartnerschaft, lohnt ein Blick zurück auf die Anfänge des Unternehmens. Als OpenAI im Dezember 2015 von Elon Musk, Sam Altman, Greg Brockman, Ilya Sutskever und anderen gegründet wurde, war es eine Non-Profit-Organisation mit einem klaren ethischen Anspruch: Künstliche Intelligenz sollte zum Nutzen der gesamten Menschheit entwickelt werden.

Das Ziel war zunächst Forschung, frei, transparent und unabhängig von wirtschaftlichen Interessen. Doch schnell zeigte sich: Wer KI im großen Maßstab erforschen will, braucht enorme Rechenleistung – und die kostet Geld. Diese Erkenntnis führte zu einem Wendepunkt: Aus der idealistischen Forschungseinrichtung wurde schrittweise ein unternehmerisches Hybridmodell, das wissenschaftlichen Anspruch mit wirtschaftlicher Tragfähigkeit verbindet.

Der Aufstieg der Modelle: Von GPT-1 zu GPT-4

Mit der Veröffentlichung der GPT-Reihe (Generative Pretrained Transformer) änderte sich alles. Während GPT-2 (2019) noch ein Experimentierfeld war, katapultierte GPT-3 (2020) OpenAI in die globale Wahrnehmung. Zum ersten Mal wurde generative KI zu einem greifbaren Werkzeug, für Text, Code und Ideen. Mit ChatGPT (Ende 2022) eroberte OpenAI schließlich die öffentliche Bühne. Innerhalb weniger Monate nutzten Millionen Menschen das Modell, und der Begriff Prompt wurde Teil des Alltagsvokabulars.

Parallel entwickelte sich die Partnerschaft mit Microsoft zu einem der wichtigsten Technologie-Deals der letzten Dekade. Über den Azure AI Supercomputer erhielt OpenAI exklusiven Zugriff auf massive GPU-Ressourcen und konnte so in kurzer Zeit Trainings durchführen, die zuvor nur Forschungsverbünden mit staatlicher Unterstützung möglich gewesen wären. Diese Symbiose – Forschung, Cloud und Geschäftsmodell – machte OpenAI zu einem echten Compute-Player.

Vom Labor zum Infrastrukturbetreiber

Mit der Einführung von GPT-4 und dem systemischen Konzept von GPT-5 (bestehend aus modularen Router– und Thinking-Modellen) wurde klar, dass OpenAI nicht mehr nur Software entwickelt, sondern Infrastruktur baut. Training, Inferenz, Datensicherung und Modell-Governance verschmelzen zu einem eigenen Ökosystem. Damit stieg OpenAI in jene Liga auf, in der traditionell Unternehmen wie NVIDIA, AMD, Intel oder Google agieren, allerdings mit einem entscheidenden Unterschied: OpenAI versteht sich nicht primär als Hardwarehersteller, sondern als Orchestrator von Rechenleistung.

In dieser Rolle begann das Unternehmen, selbst Kapazitäten zu sichern und den Markt aktiv zu gestalten, zunächst über Microsoft, jetzt auch über direkte Partnerschaften mit Chip-Herstellern. Die neue Vereinbarung mit AMD über 6 Gigawatt GPU-Leistung markiert somit keinen Zufall, sondern den nächsten logischen Schritt in der Evolution eines Unternehmens, das von Anfang an auf Skalierbarkeit ausgelegt war.

Die strategische Bedeutung der neuen Partnerschaften

Mit dem Schritt in die Gigawatt-Ära ist OpenAI endgültig zu einem globalen Infrastruktur-Akteur geworden. Es agiert heute in einer Schnittmenge aus Forschung, Wirtschaft, Energie und Politik. Während frühere Tech-Unternehmen Software lizenzierten oder Hardware verkauften, handelt OpenAI mit Compute als Ressource, mit Rechenleistung als neuem Rohstoff der Digitalisierung.

Die Partnerschaften mit NVIDIA, AMD und Broadcom verdeutlichen diese neue Rolle. Sie zeigen, dass OpenAI nicht länger nur Konsument von Hardware ist, sondern selbst als strategischer Taktgeber auftritt. Was als Vision für offene, sichere KI begann, ist heute eine Industrie im industriellen Maßstab: OpenAI betreibt, beeinflusst und beschleunigt den Aufbau der nächsten globalen Recheninfrastruktur, die Grundlage für die Ära, die wir heute Gigawatt-KI nennen.

Der Doppelschlag: 10 GW NVIDIA, 6 GW AMD und Broadcom als stiller Riese

Mit der Ankündigung von zwei parallel laufenden Megaprojekten hat OpenAI die Grenzen klassischer Skalierung endgültig verschoben. Insgesamt 16 Gigawatt Rechenleistung sollen bis 2027 bereitstehen, verteilt auf 10 GW NVIDIA-Systeme und 6 GW AMD-Infrastruktur. Diese Größenordnung markiert den Übergang von Rechenzentren zu Energieökosystemen: Was früher der Strombedarf ganzer Städte war, wird heute für neuronale Netze reserviert.

Technisch betrachtet sind die Unterschiede zwischen beiden Plattformen spannend. NVIDIA setzt mit der Vera-Rubin-Architektur auf die Integration des GB200 Grace-Blackwell-Superchips, kombiniert mit NVLink 5.0 und NVSwitch. Dadurch lassen sich mehrere Zehntausend GPUs zu einem einheitlichen Hochleistungs-Cluster verbinden. AMD kontert mit der neuen MI450-Generation, die auf einer weiterentwickelten CDNA-Architektur basiert und über ROCm 6.0 vollständig in bestehende Machine-Learning-Workflows integriert werden kann. Der Fokus liegt hier auf Energieeffizienz, Speicherbandbreite und Rack-Scale-Optimierung, also auf der Balance zwischen Leistung und Verbrauch.

Die eigentliche Überraschung des Deals liegt jedoch in der strategischen Tiefe. Selbst NVIDIA-CEO Jensen Huang zeigte sich laut Finanzen.net überrascht über das Tempo, mit dem AMD zum gleichwertigen Partner aufsteigt. Hinzu kommt die neue Partnerschaft zwischen OpenAI und Broadcom, die High-Speed-Interconnects, Netzwerk-ASICs und Co-Packaged Optics liefert, also genau die Komponenten, die den Energie- und Datenfluss in Gigawatt-Systemen ermöglichen.

Damit entsteht erstmals ein multi-vendor-fähiger KI-Stack, in dem Compute, Networking und Energieversorgung gleichberechtigt betrachtet werden. OpenAI macht sich dadurch unabhängiger, reduziert Liefer- und Preisrisiken und kann seine Infrastruktur flexibler anpassen. Diese neue Architektur ist nicht nur ein Meilenstein in der Hardwareentwicklung, sondern auch ein strategisches Signal: KI wird zur industriellen Basistechnologie – vergleichbar mit Strom oder Internetzugang.

Wirtschaftliche und politische Verflechtungen

Die Partnerschaften zwischen OpenAI, AMD, NVIDIA und Broadcom sind nicht nur technologische Meilensteine, sie sind auch ein wirtschaftliches Signal mit globaler Tragweite. Innerhalb weniger Tage reagierten Kapitalmärkte, Analyst:innen und Regulierungsbehörden gleichermaßen: Aktien von AMD stiegen auf Rekordniveau, während NVIDIA mit Skepsis, aber auch Respekt auf die neue Konkurrenz blickte. Laut onemarkets.de sehen Investor:innen den Deal als Wendepunkt, der AMD dauerhaft in die Liga der dominierenden KI-Infrastruktur-Anbieter:innen hebt.

Hinter den Kulissen entsteht ein Netzwerk zirkulärer Abhängigkeiten. OpenAI verpflichtet sich zur Abnahme bestimmter Mengen an AMD-GPUs – im Gegenzug erhält AMD finanzielle Garantien und technische Einblicke zur Optimierung seiner Chips. Parallel baut NVIDIA eigene Fertigungskapazitäten aus, um Preisstabilität und Lieferfähigkeit zu sichern. Ergänzt wird dieses Geflecht durch Broadcom, das mit Co-Packaged Optics und High-Speed-ASICs die physische Infrastruktur der neuen Rechenfabriken liefert. Damit entsteht ein vertikal integriertes KI-Ökosystem, das Compute, Netzwerk und Kapital untrennbar verbindet.

Politisch betrachtet reicht diese Entwicklung weit über den Wettbewerb zweier Halbleiterhersteller hinaus. Nationale Regierungen fördern gezielt energieintensive Rechenzentren, um Innovationsvorsprünge zu sichern, während Aufsichtsbehörden zunehmend auf die Konzentration von Markt- und Rechenmacht reagieren. Hier schließt sich der Kreis zu meinem Beitrag KI für alle – Modelle, Einsatzfelder, Verantwortung, in dem ich darauf hingewiesen habe, dass der Zugang zu KI-Technologien eine gesellschaftliche und politische Dimension besitzt. Wenn Rechenleistung zum Machtfaktor wird, entscheidet nicht nur Kapital über Fortschritt, sondern auch, wer Zugang zu dieser Infrastruktur erhält.

Diese Verflechtung aus Kapital, Energie und Governance verdeutlicht: Wer künftig KI betreiben will, braucht mehr als Daten und Modelle – er braucht verlässliche Lieferketten, politische Stabilität und eine klare Haltung zur Verantwortung.

Gegenbewegung: Kleine Modelle, große Wirkung

Während die großen Player der Branche in Gigawatt-Kategorien denken, wächst parallel eine Bewegung, die auf Effizienz statt Masse setzt. Unter dem Begriff Tiny AI entstehen Modelle, die lokal ausgeführt werden können – auf Servern im Unternehmen oder direkt auf Endgeräten. Diese Entwicklung ist keine Randnotiz, sondern ein bewusster Gegenentwurf zur zentralisierten Rechenmacht der Hyperscaler.

In meinem Beitrag Kleine Modelle, große Wirkung – Tiny AI im Unternehmensalltag habe ich bereits gezeigt, dass sich moderne Sprach- und Vision-Modelle in kompakten Varianten betreiben lassen, ohne an Praxistauglichkeit zu verlieren. Durch Techniken wie Quantisierung, LoRA-Anpassungen und Edge-Optimierungen lassen sich selbst große Transformer auf einen Bruchteil der ursprünglichen Parametergröße reduzieren, bei oft nur geringem Qualitätsverlust. Das spart nicht nur Strom, sondern ermöglicht auch völlig neue Anwendungsfälle in sensiblen Umgebungen, in denen Cloud-Lösungen aus Datenschutz- oder Compliance-Gründen ausgeschlossen sind.

Technisch gesehen ist Tiny AI weit mehr als ein Sparmodell. Durch spezialisierte Hardware – beispielsweise NPUs (Neural Processing Units) in modernen Prozessoren – werden lokale Inferenzprozesse zunehmend effizienter. Gleichzeitig sinken die Latenzzeiten drastisch, da keine Verbindung zu externen Rechenzentren erforderlich ist. Im größeren Kontext des OpenAI-Deals zeigt sich damit ein Spannungsbogen: Big Compute liefert die Grundlage für globale KI-Modelle, Smart Compute bringt diese Intelligenz in den Alltag. Unternehmen, die beide Ansätze kombinieren – etwa durch zentrale Trainings und dezentrale Inferenz – werden langfristig die flexibelsten Strategien entwickeln. Denn echte Innovation entsteht nicht allein durch Größe, sondern durch bewusste Balance zwischen Leistung und Nachhaltigkeit.

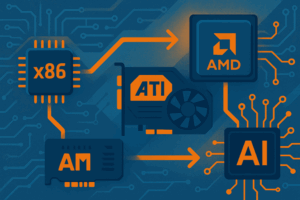

Exkurs: AMD – Vom x86 über ATi zum KI-Unternehmen

Die Anfänge: Konkurrenz im Schatten von Intel

Advanced Micro Devices (AMD) wurde 1969 in Kalifornien gegründet, ursprünglich als Zulieferer für Logik- und Speicherchips. In den 1980er-Jahren machte sich das Unternehmen als Lizenzfertiger für Intels x86-Architektur einen Namen. Diese Lizenz ermöglichte AMD, kompatible Prozessoren herzustellen, die günstiger, aber oft auch innovativer waren. Bereits damals entstand die Rolle, die AMD bis heute prägt: der Herausforderer im Hochleistungsmarkt – nie der Erste, aber häufig der Schnellere.

Mit Prozessorserien wie dem Am386, später dem Athlon und dem Opteron positionierte sich AMD im Server- und Desktop-Segment als ernsthafte Alternative zu Intel. 2003 gelang ein Meilenstein: Der erste 64-Bit-x86-Prozessor kam nicht von Intel, sondern von AMD. Diese Fähigkeit, etablierte Standards neu zu denken, bildet bis heute das Fundament des Unternehmens.

Der ATi-Deal: Grafik trifft auf Rechenleistung

Im Jahr 2006 übernahm AMD den kanadischen Grafikchiphersteller ATi Technologies, ein Schritt, der zunächst skeptisch beäugt wurde. Doch langfristig legte genau diese Übernahme den Grundstein für den Wandel zum GPU- und Beschleuniger-Spezialisten. Aus der Fusion entstand eine neue Produktlinie, die CPU- und GPU-Architekturen miteinander kombinierte. Diese Vision – damals unter dem Schlagwort Fusion – wurde später zur Basis moderner APUs (Accelerated Processing Units) und der CDNA-Architektur, die heute in Rechenzentren eingesetzt wird.

Während sich NVIDIA auf den Gaming- und HPC-Markt fokussierte, entwickelte AMD mit den Radeon Instinct– und MI-Beschleunigern eine eigene GPU-Familie für Rechenzentren. Damit legte das Unternehmen den Grundstein für das, was heute als ROCm-Plattform (Radeon Open Compute) bekannt ist, eine offene Alternative zu NVIDIAs CUDA-Ökosystem.

Vom Challenger zum Partner der Giganten

Nach Jahren intensiver Entwicklung und wirtschaftlicher Rückschläge fand AMD unter CEO Dr. Lisa Su zu neuer Stärke. Die Einführung der Zen-Architektur (ab 2017) brachte AMD im CPU-Segment an die Spitze zurück, während MI100 – MI300X die GPU-Sparte für KI-Workloads professionalisierten. Die Kombination aus hoher Speicherbandbreite (HBM), effizientem Energieverbrauch und offenem Software-Stack machte AMD zu einem ernsthaften Kandidaten für Hyperscaler, die bislang auf NVIDIA angewiesen waren.

Mit der Kooperation mit OpenAI erreicht diese Entwicklung nun ihren Höhepunkt. Aus einem klassischen CPU-Hersteller ist ein strategischer KI-Infrastrukturpartner geworden, dessen Produkte in den größten Rechenclustern der Welt zum Einsatz kommen. Dass NVIDIA-CEO Jensen Huang laut Finanzen.net selbst überrascht war, wie schnell AMD aufgeschlossen hat, spricht Bände: Der ewige Herausforderer ist zum Mitgestalter einer neuen Rechenepoche geworden.

Vom Silizium zum Ökosystem

Heute positioniert sich AMD nicht mehr nur über Hardware, sondern über Plattform- und Energieeffizienzstrategien. Mit ROCm 6, optimierten Compiler-Stacks und enger Integration in Open-Source-Frameworks wie PyTorch oder TensorFlow entsteht ein Ökosystem, das bewusst offener, nachhaltiger und diversifizierter gestaltet ist als viele proprietäre Alternativen. Die Partnerschaft mit OpenAI über 6 Gigawatt GPU-Leistung ist daher keine Abkehr von AMDs Wurzeln, sondern deren logische Fortführung: Innovation durch Offenheit, Wettbewerb durch Effizienz – und Fortschritt durch Integration.

Zwischen Skalierung und Nachhaltigkeit

Die aktuelle Entwicklung zeigt deutlicher denn je: Künstliche Intelligenz wächst an zwei Fronten gleichzeitig: in Richtung Gigawatt-Skalierung auf der einen und energieeffizienter Miniaturisierung auf der anderen Seite. Beide Trends sind untrennbar miteinander verbunden, denn ohne Fortschritte in der Effizienz lässt sich das rasante Wachstum der Rechenzentren kaum verantworten.

Während OpenAI, AMD und NVIDIA an neuen Hochleistungsarchitekturen arbeiten, die Milliarden von Parametern in kürzerer Zeit verarbeiten können, entstehen parallel immer mehr Initiativen, die sich mit der ökologischen Bilanz der KI befassen. Unternehmen setzen zunehmend auf eigene ESG-Strategien (Environmental, Social and Governance) und berichten offen über den Energieverbrauch ihrer Modelle. Auch politische Rahmenbedingungen greifen: Der EU AI Act fordert Transparenz, Nachvollziehbarkeit und nachhaltige Nutzung, ein Schritt, der KI-Projekte künftig stärker an Umwelt- und Ethikstandards bindet.

Technologisch rückt dabei das Konzept des Smart Compute in den Mittelpunkt. Statt immer mehr Leistung bereitzustellen, geht es darum, vorhandene Ressourcen effizienter zu nutzen. Adaptive Inferenz, energieoptimierte Chips und dynamische Workload-Verteilung werden zu zentralen Werkzeugen moderner IT-Infrastrukturen. Unternehmen, die ihre KI-Architekturen bewusst danach ausrichten, profitieren doppelt: Sie senken ihre Betriebskosten und verbessern gleichzeitig ihre Nachhaltigkeitsbilanz.

Diese Entwicklung markiert einen notwendigen Kulturwandel. Wachstum bleibt wichtig, doch es darf nicht mehr Selbstzweck sein. Entscheidend wird, ob KI langfristig verantwortungsvoll betrieben werden kann, als Teil eines Gleichgewichts zwischen technologischem Fortschritt und ökologischer Vernunft. Genau hier liegt der nächste Evolutionsschritt der Branche: Intelligenz neu denken – nicht nur größer, sondern auch nachhaltiger.

Fazit: Wachstum mit Verantwortung

Die Partnerschaften zwischen OpenAI, AMD, NVIDIA und Broadcom markieren den Beginn einer neuen Phase der KI-Entwicklung. Sie zeigen, wie aus Rechenleistung Infrastruktur wird – und wie eng technologische Innovation inzwischen mit Energie, Kapital und Politik verflochten ist. Die geplanten 16 Gigawatt Rechenkapazität sind mehr als eine technische Kennzahl. Sie sind ein Symbol für den nächsten Schritt der digitalen Evolution, gleichzeitig aber auch eine Mahnung, dass Fortschritt nur dann nachhaltig bleibt, wenn er bewusst gestaltet wird.

Die letzten Monate haben gezeigt, dass sich die KI-Welt in zwei Richtungen bewegt: Auf der einen Seite entstehen gigantische Cluster, die neue Grenzen in Training und Inferenz verschieben. Auf der anderen Seite wächst die Bewegung hin zu Tiny AI, Edge Computing und Smart Compute, zu Modellen, die weniger Energie benötigen, lokaler verarbeitet werden und reale Probleme effizient lösen. Diese beiden Welten schließen sich nicht aus. Im Gegenteil: Sie ergänzen sich zu einem ganzheitlichen Ökosystem, das die Basis für verantwortungsvolle Innovation bildet.

Letztlich entscheidet nicht die Größe eines Modells über seinen Wert, sondern der Beitrag, den es für Menschen und Gesellschaft leistet. Nachhaltigkeit, Energieeffizienz und Fairness werden zur neuen Währung künstlicher Intelligenz. Die Zukunft der KI wird nicht nur in Rechenzentren gebaut, sie entsteht überall dort, wo wir Verantwortung übernehmen, bevor wir skalieren.

Damit schließt sich der Kreis: Vom Gigawatt zur Gewissenhaftigkeit. KI wächst – doch ihr wahres Potenzial liegt nicht in der Menge der GPUs, sondern in der Tiefe des Bewusstseins, mit dem wir sie einsetzen.

Quellenangaben

(Abgerufen am 24.10.2025)

Offizielle Ankündigungen und Pressemitteilungen:

- AMD: AMD and OpenAI announce strategic partnership to deploy 6 gigawatts of AMD GPUs

- OpenAI: OpenAI and Broadcom announce strategic collaboration

- OpenAI: OpenAI and NVIDIA systems partnership

Analysen, Marktberichte und Hintergrundartikel:

- Bloomberg: OpenAI’s NVIDIA and AMD deals boost 1-trillion-AI boom

- CNBC: Sam Altman on GPT-6 – People want memory

- Decoder: OpenAI CEO Sam Altman spricht über GPT-6

- net: Das hat den NVIDIA-Chef am Deal zwischen OpenAI und AMD überrascht

- ai: GPT-6 Übersicht und Timeline

- Mataculus: GPT-6 Release Date Prediction

- de: AMD auf Rekordkurs – OpenAI-Deal und Datacenter sorgen für Schub

- OpenAI: GPT-5 System Card

- Redwood Resarch Blog: My AGI Timeline – Updates from GPT

- Sam Altmann (Blog): Reflections

- Tagesschau: AMD, NVIDIA und der Kampf um die KI-Chips

- Wall Street Journal: OpenAI–AMD deal deepens AI chip race

Weiterlesen hier im Blog

- Der ökologische Fußabdruck künstlicher Intelligenz erklärt

- KI für alle – Modelle, Einsatzfelder, Verantwortung

- Kleine Modelle, große Wirkung – Tiny AI im Unternehmensalltag

- Künstliche Intelligenz vs. menschliches Gehirn: Ein Vergleich in Milliarden

- Über KI, das Wachstum und warum es wahrscheinlich nicht ewig so weiter geht