In einer zunehmend vernetzten Welt, in der Daten zur Währung und Zugriff zur Macht geworden ist, genügt es längst nicht mehr, dass Pakete ihr Ziel erreichen. Auch der Inhalt, die Integrität und der Zugang zu diesen Informationen müssen geschützt, verwaltet und nachvollziehbar kontrolliert werden.

In den vorangegangenen Beiträgen dieser Reihe haben wir uns mit den Grundlagen der Netzwerkkommunikation (Layer 1 und 2) sowie der logischen Vermittlung und dem Transport von Datenpaketen (Layer 3 und 4) beschäftigt. Dabei haben wir gelernt, wie Bits in Bewegung geraten, wie IP-Adressen ihre Empfänger finden und wie Protokolle wie TCP, UDP oder ICMP für Stabilität und Performance sorgen.

Doch mit dem sicheren Transport ist nur die halbe Arbeit getan.

Die wahren Herausforderungen beginnen dort, wo menschliche und maschinelle Interaktion ins Spiel kommt – auf den Schichten 5 bis 7 des OSI-Modells: Sitzung, Darstellung, Anwendung. Hier begegnen wir realen Anwendungen wie Webbrowsern, Dateifreigaben, Remote-Zugriffen, Authentifizierungssystemen, E-Mail-Diensten oder APIs. Und genau hier setzen moderne Bedrohungsszenarien an, mit Phishing, Session Hijacking, Rechteeskalation oder API Abuse.

Dieser Beitrag schlägt eine Brücke zwischen technischen Mechanismen und organisatorischer Sicherheitsverantwortung. Wir werfen einen praxisnahen Blick auf zentrale Sicherheitsprotokolle, Firewalls und Netzwerkzonen, Authentifizierungsverfahren, Managementsysteme und regulatorische Rahmenwerke wie Zero Trust und NIS2.

Unser Ziel: Verstehen, warum Vertrauen allein nicht mehr reicht – und wie Kontrolle heute im Netzwerkalltag gestaltet werden kann.

Schicht 5 bis 7 im OSI-Modell – Mehr als nur Nutzdaten

Während die unteren vier Ebenen des OSI-Modells für den zuverlässigen Transport und die Adressierung von Daten verantwortlich sind, ermöglichen es die Schichten 5 bis 7 überhaupt erst, sinnvolle Interaktionen zwischen Anwendungen und Nutzenden herzustellen.

Diese Schichten sind eng miteinander verwoben und wirken in vielen modernen Protokollen und Anwendungen quasi untrennbar zusammen:

- Schicht 5: Sitzungsschicht (Session Layer):

Hier werden Kommunikationssitzungen aufgebaut, verwaltet und beendet. Sitzungen können z.B. persistent bleiben, rekonfiguriert oder wiederaufgenommen werden – essenziell für Anmeldeprozesse, Dateiübertragungen oder Remote-Desktops. - Schicht 6: Darstellungsschicht (Presentation Layer):

Diese Ebene sorgt für die Standardisierung und Kodierung der übertragenen Daten. Sie definiert Formate, Zeichensätze (z.B. UTF-8), Komprimierung und – besonders sicherheitsrelevant – Verschlüsselung. Auch Protokolle wie TLS wirken hier mit. - Schicht 7: Anwendungsschicht (Application Layer):

Der Endpunkt der Kommunikation. Hier arbeiten Dienste wie HTTP, SMTP, FTP, RDP, DNS oder SMB – also genau jene Protokolle, mit denen Nutzer:innen oder Dienste direkt interagieren.

Diese drei Schichten sind nicht einfach nur Datenendpunkte, sondern auch strategische Angriffspunkte. Wer auf Schicht 7 eine Schwachstelle findet – etwa eine unsichere Web-API oder eine falsch konfigurierte Dateiablage – kann oft die darunterliegenden Schutzmechanismen umgehen. Genau deshalb stehen sie heute im Fokus moderner Sicherheits- und Managementkonzepte.

Warum diese Schichten sicherheitskritisch sind

- Komplexität erzeugt Angriffsfläche

Während ein Switch auf Layer 2 vergleichsweise dumm agiert, verarbeitet ein Webserver auf Layer 7 komplexe Inhalte, Sessions, Header und Input – und ist damit auch potenziell angreifbar durch SQL Injection, Cross Site Scripting oder Session-Fälschung. - Nutzer-Interaktion trifft IT-Logik

Gerade weil hier Mensch und Maschine zusammenkommen, entstehen Schwachstellen durch Fehlkonfiguration, Bedienfehler oder unzureichende Validierung – ein Klassiker: freigegebene SMB-Shares ohne Zugriffskontrolle. - Verantwortlichkeit liegt oft bei mehreren Instanzen

Netzwerkadministration, Softwareentwicklung, IT-Sicherheit und Fachbereiche treffen sich genau hier. Das verlangt Koordination – und stellt IT-Teams vor organisatorische Herausforderungen.

Fazit

Die oberen Schichten des OSI-Modells sind keine Add-Ons, sondern integraler Bestandteil jeder modernen IT-Infrastruktur, sowohl technisch als auch in Bezug auf Governance, Verantwortung und Compliance. Wer Netzwerke sichern will, muss über die Leitung hinausdenken – und verstehen, dass echte Sicherheit erst dort beginnt, wo Daten verwendet und interpretiert werden.

Doch sobald Daten auf Anwendungsebene ankommen, stellt sich zwangsläufig die nächste Frage: Wer darf eigentlich darauf zugreifen – und auf welcher Grundlage?

Sicherheitsprotokolle auf Anwendungsebene – Schutz für die letzten Meter

Sobald Daten ihr Ziel erreichen, ist ihre Reise noch lange nicht beendet. Sie müssen entschlüsselt, interpretiert und bereitgestellt werden – und das möglichst ausschließlich für berechtigte Gegenstellen, ohne dass sie unterwegs manipuliert wurden oder in falsche Hände gelangen. Genau an dieser Schnittstelle zwischen Datenübertragung und Anwendungsebene entfaltet sich die volle Relevanz sicherheitskritischer Protokolle. Sie operieren meist auf Layer 7 – teilweise auch bereits auf Layer 6 – und übernehmen dort eine zentrale Aufgabe: die Absicherung der letzten Meter.

In der täglichen IT-Praxis bilden gerade diese Protokolle das Fundament moderner Sicherheitsarchitekturen. Nicht zuletzt deshalb, weil sie dort wirken, wo menschliche und maschinelle Kommunikation zusammenläuft – etwa beim Zugriff auf Webportale, der Übertragung sensibler Dateien, der Nutzung von Cloud-APIs oder beim Abruf von E-Mails. Doch gerade diese Nähe zur Anwendung macht sie zu beliebten Zielen von Angriffen, Missbrauch und Fehlkonfiguration.

TLS: Vertrauen ist verschlüsselt

Ein gutes Beispiel für ein solches Protokoll ist Transport Layer Security (TLS) – der Nachfolger von Secure Sockets Layer (SSL), der vielen vor allem durch die HTTPS-Kennzeichnung im Browser bekannt ist. TLS verschlüsselt Verbindungen, sorgt für die Integrität der übertragenen Daten und stellt über X.509-Zertifikate sicher, dass Server und Clients – zumeist einseitig – authentisch miteinander kommunizieren.

Die Einsatzbereiche sind vielfältig: Ob bei der Verschlüsselung von Webseiten, bei verschlüsseltem Mailverkehr über SMTP, IMAP oder POP3 oder in abgesicherten REST- oder SOAP-APIs – TLS gehört heute zum Pflichtprogramm. In modernen Implementierungen unterstützt es auch sogenannte Perfect Forward Secrecy, wodurch selbst bei einem kompromittierten Schlüssel keine nachträgliche Entschlüsselung alter Sitzungen möglich ist.

Doch die Verlässlichkeit von TLS hängt stark von seiner konkreten Umsetzung ab. Schwache Cipher Suites, falsch konfigurierte Protokollversionen oder abgelaufene Zertifikate können aus einer vermeintlich sicheren Verbindung ein offenes Scheunentor machen. Auch Downgrade-Angriffe – etwa das gezielte Erzwingen veralteter SSL-Versionen – bleiben ein reales Risiko, wenn Protokollrichtlinien nicht sauber definiert sind.

Ein korrekt konfigurierter TLS-Endpunkt, etwa beim Aufruf von https://meinserver.de, signalisiert dem Browser: Diese Verbindung ist nicht nur verschlüsselt, sondern auch mit einem gültigen Zertifikat versehen – der Server ist also tatsächlich der, für den er sich ausgibt. In Zeiten wachsender API-Ökosysteme, IoT-Kommunikation und mobiler Dienste ist TLS damit nicht nur eine Frage des Datenschutzes, sondern elementarer Bestandteil digitaler Vertrauensarchitektur.

Doch hinter der scheinbaren Einfachheit von https steckt eine jahrzehntelange Entwicklung mit teils gravierenden Sicherheitslücken, Paradigmenwechseln und Kompromissen zwischen Kompatibilität und Sicherheit. Wer TLS richtig einsetzen will, sollte verstehen, warum sein Vorgänger SSL heute nicht mehr eingesetzt werden darf – und was genau den Unterschied ausmacht.

Exkurs: Von SSL zu TLS – Warum die Wahl des richtigen Standards wichtig ist

Die Begriffe SSL und TLS werden im Alltag oft synonym verwendet – und selbst technische Tools sprechen häufig noch von SSL-Zertifikaten, obwohl längst TLS gemeint ist. Doch diese Gleichsetzung ist irreführend: Die Unterschiede zwischen SSL und TLS sind nicht nur semantisch, sondern sicherheitskritisch.

SSL: Ein Sicherheitsprotokoll mit Verfallsdatum

SSL (Secure Sockets Layer) wurde in den 1990er Jahren entwickelt, um Webkommunikation zu verschlüsseln. Schon früh zeigte sich jedoch: Die ersten beiden Versionen (SSL 1.0 und 2.0) waren unsicher. SSL 3.0, veröffentlicht 1996, war lange Zeit weit verbreitet – bis 2014 ein fundamentaler Schwachpunkt bekannt wurde: POODLE (Padding Oracle On Downgraded Legacy Encryption). Diese Lücke konnte Angreifern ermöglichen, verschlüsselte Verbindungen zu kompromittieren – vor allem, wenn ein Downgrade von TLS auf SSL 3.0 erzwungen werden konnte.

TLS: Der Nachfolger mit Substanz

TLS (Transport Layer Security) ist die offiziell standardisierte Weiterentwicklung von SSL. Es ersetzt dieses Protokoll vollständig:

- TLS 1.0 (1999) war stark an SSL 3.0 angelehnt – allerdings mit ersten Verbesserungen

- TLS 1.1 (2006) brachte sichere Initialisierungsvektoren, setzte sich jedoch kaum durch

- TLS 1.2 (2008) wurde zum langjährigen Industriestandard mit Unterstützung starker Hash-Verfahren, AEAD-Cipher und ausgefeilterer Sicherheitsmechanismen

- TLS 1.3 (2018) vollzog einen entscheidenden Schnitt: Veraltete Algorithmen wurden entfernt, Handshakes vereinfacht, und Forward Secrecy wurde zur Pflicht

Mit TLS 1.3 wurde auch die Abwärtskompatibilität bewusst reduziert, um Angriffsflächen zu minimieren. Viele Unternehmen mussten ihre Systeme entsprechend anpassen – doch die Sicherheitsvorteile überwiegen deutlich.

Kompatibilität vs. Sicherheit: eine strategische Abwägung

In der Praxis stehen Admins häufig vor dem Dilemma: Alte Clients benötigen alte Protokolle, neue Sicherheitsanforderungen verbieten diese. Die Lösung liegt in klarer Priorisierung:

- Legacy-Systeme gezielt isolieren oder ablösen

- TLS-Versionen explizit einschränken (z.B. nur 1.2 und 1.3 zulassen)

- Cipher Suites regelmäßig prüfen und schwache Verfahren deaktivieren

- Protokollverhandlungen überwachen und Downgrade-Angriffe erkennen (z.B. mit HSTS und ALPN)

Nur wer weiß, welche Version aktiv ist – und warum –, kann fundierte Sicherheitsentscheidungen treffen.

SMB: Spät entdeckte Sicherheitsbedarfe

Deutlich weniger prominent – aber sicherheitstechnisch nicht weniger relevant – ist das Protokoll SMB (Server Message Block), das vor allem in Windows-Umgebungen für Datei- und Druckfreigaben genutzt wird. Ursprünglich für den internen Einsatz in vertrauenswürdigen Netzen entwickelt, erfuhr SMB seine sicherheitsrelevante Evolution erst im Nachhinein – oft als Reaktion auf gravierende Vorfälle.

So boten ältere SMB-Versionen wie SMBv1 keinerlei Schutz vor Manipulation oder Missbrauch. In der Praxis führte dies zu offenen Freigaben, unzureichend geschützten Netzlaufwerken und – wie im Fall von WannaCry – zu katastrophalen Angriffswellen, die sich über ungepatchte SMB-Dienste millionenfach verbreiteten.

Inzwischen unterstützt SMB (ab Version 3.0) grundlegende Sicherheitsmechanismen wie Transportverschlüsselung, Paket-Signierung und moderne Authentifizierung per Kerberos. Dennoch bleibt die Gefahr: Viele Systeme laufen noch immer mit veralteten Protokollversionen, oder Freigaben sind nach wie vor ohne Zugriffskontrolle über das Netz erreichbar. Besonders riskant ist die Exposition von SMB-Diensten ins Internet – was in produktiven Umgebungen unbedingt vermieden werden sollte.

Ein sicherer Umgang mit SMB erfordert heute nicht nur aktuelle Protokollversionen, sondern auch klare Zugriffsbeschränkungen, deaktivierte Legacy-Komponenten und gezielte Firewall-Regeln – insbesondere auf Port 445. Auch hier gilt: Das Protokoll ist nur so sicher, wie seine Konfiguration erlaubt.

Fazit

Sicherheitsprotokolle auf Anwendungsebene wirken oft im Hintergrund, sind aber in der Praxis essenziell – denn sie schützen genau den Bereich, in dem Daten vom bloßen Transportgut zum relevanten Geschäftsobjekt werden. Wer sie vernachlässigt oder ihre Konfiguration dem Zufall überlässt, riskiert nicht nur technische Schwachstellen, sondern untergräbt das Vertrauen in digitale Kommunikation.

Im Zeitalter verteilter Systeme, hybrider Arbeitswelten und Cloud-Infrastrukturen ist die Absicherung auf Anwendungsebene kein Zusatznutzen – sie ist Grundvoraussetzung für digitale Resilienz.

Exkurs: Diffie-Hellman – Schlüsselaustausch im unsicheren Raum

Vertrauliche Kommunikation setzt voraus, dass beide Kommunikationspartner einen gemeinsamen Schlüssel besitzen – einen Schlüssel, der idealerweise niemandem sonst bekannt ist. Doch wie lässt sich ein solcher Schlüssel sicher austauschen, wenn das Kommunikationsmedium – etwa das Internet – als kompromittiert gelten muss?

Diese Frage war lange Zeit ungelöst. Erst mit der Arbeit von Whitfield Diffie und Martin Hellman, veröffentlicht 1976, entstand ein Verfahren, das diese Herausforderung auf elegante Weise löst: der Diffie-Hellman-Schlüsselaustausch – eine der Grundideen moderner Kryptographie.

Was macht Diffie-Hellman so revolutionär?

Der Clou dieses Verfahrens liegt darin, dass zwei Parteien einen gemeinsamen geheimen Schlüssel berechnen können, ohne ihn je über das Netzwerk zu senden. Selbst bei vollständiger Einsicht in den übertragenen Daten kann ein Angreifer diesen Schlüssel praktisch nicht rekonstruieren – vorausgesetzt, geeignete mathematische Grundlagen werden genutzt.

Der Mechanismus basiert auf modularer Arithmetik in Kombination mit der Schwierigkeit des diskreten Logarithmusproblems – einem mathematischen Problem, das mit heutiger Rechentechnik nicht effizient lösbar ist.

Wie funktioniert der Austausch in der Praxis?

In der einfachsten Form läuft Diffie-Hellman wie folgt ab:

- Beide Parteien einigen sich auf zwei öffentliche Werte: eine große Primzahl p und einen sogenannten Generator g, der die mathematische Basis für den späteren Schlüsselaustausch bildet.

- Jede Partei wählt eine private Zufallszahl (den Privaten Schlüssel)

- Person A wählt a

- Person B wählt b

- Beide Parteien berechnen auf Basis ihrer privaten Zufallszahl den Öffentlichen Schlüssel A bzw. B:

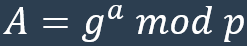

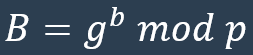

- A sendet

- B sendet

- Mit dem Öffentlichen Schlüssel des Gegenübers und der eigenen privaten Zufallszahl berechnen beide Seiten den gemeinsamen geheimen Schlüssel K:

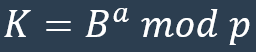

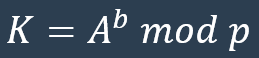

- A berechnet

- B berechnet

So ergibt sich auf beiden Seiten der gleiche Schlüssel – ohne dass a oder b je den lokalen Rechner oder das eigene System verlassen haben.

Warum reicht das allein nicht aus?

So genial das Verfahren auch ist: Diffie-Hellman allein bietet keine Authentifizierung. Ein sogenannter Man-in-the-Middle kann sich vermittelnd zwischen zwei kommunizierende Systeme schalten und jeweils eigene Schlüsselpaare austauschen. Die Lösung hierfür ist die Kombination mit digitalen Signaturen oder Zertifikaten, wie sie etwa im TLS-Protokoll verwendet wird.

Varianten in der realen Welt

In modernen Sicherheitsprotokollen kommt meist nicht der klassische Diffie-Hellman zum Einsatz, sondern optimierte und sicherere Varianten:

- DHE (Ephemeral Diffie-Hellman):

Generiert für jede Sitzung neue Schlüssel und ermöglicht damit Forward Secrecy. Selbst wenn langfristige Schlüssel kompromittiert werden, bleiben frühere Sitzungen geschützt - ECDHE (Elliptic Curve Diffie-Hellman Ephemeral):

Verwendet elliptische Kurven statt klassischer modularer Arithmetik. Vorteil: höhere Sicherheit bei kürzeren Schlüsseln und deutlich bessere Performance – besonders wichtig für mobile Geräte und hochfrequente API-Kommunikation

Diffie-Hellman im Alltag – ein unsichtbarer Held

In der Praxis begegnet uns Diffie-Hellman weit häufiger, als viele vermuten:

- Beim Aufbau einer HTTPS-Verbindung wird er in der TLS-Handschlagphase verwendet, um symmetrische Schlüssel auszuhandeln

- VPN-Lösungen wie IPsec oder OpenVPN nutzen ihn für die sichere Initialisierung von Tunnelverbindungen

- Auch in Messenger-Apps mit Ende-zu-Ende-Verschlüsselung (z.B. Signal oder WhatsApp) spielt er eine tragende Rolle im Schlüsselaustausch

Fazit

Der Diffie-Hellman-Schlüsselaustausch ist ein Paradebeispiel für elegante Kryptographie – einfach im Konzept, mächtig in der Wirkung. Er bildet die Basis für verschlüsselte Kommunikation im unsicheren Raum – und ist damit ein zentraler Baustein digitaler Souveränität.

Authentifizierung und Autorisierung im Netzwerk – Vertrauen technisch absichern

Sobald eine Verbindung steht, stellt sich die nächste grundlegende Frage: Wer kommuniziert hier eigentlich – und was darf diese Instanz tun? Während Protokolle wie TLS die technische Integrität und Vertraulichkeit sichern, sind es Authentifizierungs- und Autorisierungsverfahren, die digitale Identitäten absichern und den Zugriff auf Ressourcen kontrollieren.

Gerade in komplexen Unternehmensnetzwerken ist dieser Aspekt entscheidend: Ein stabil verschlüsselter Kommunikationskanal schützt zwar den Inhalt vor neugierigen Blicken – aber ohne verlässliche Authentifizierung bleibt unklar, ob die Kommunikation mit der richtigen Person oder Maschine erfolgt. Vertrauen muss überprüfbar sein – automatisiert, nachvollziehbar und skalierbar.

Digitale Identitäten als Basis

Im Netzwerkumfeld bedeutet Authentifizierung, dass ein System eine Identität nachweisen kann – typischerweise durch Wissen (Passwort), Besitz (Token) oder biometrische Merkmale (Fingerabdruck). Die Autorisierung legt anschließend fest, was diese Identität innerhalb des Systems tun darf.

Einfacher ausgedrückt:

- Authentifizierung beantwortet die Frage: „Wer bist du?“

- Autorisierung beantwortet die Frage: „Was darfst du?“

Diese beiden Prozesse greifen ineinander, sind aber unabhängig voneinander und folgen jeweils eigenen Sicherheitsanforderungen.

Zentrale Authentifizierungsprotokolle im Überblick

In der Praxis haben sich vor allem zwei Mechanismen etabliert, um Authentifizierung in Netzwerken effizient und sicher umzusetzen:

- LDAP (Lightweight Directory Access Protocol)

LDAP dient in vielen Umgebungen als zentrales Verzeichnisdienst-Protokoll – etwa bei der Anmeldung an Windows-Domänen oder Linux-Systemen mit zentraler Nutzerverwaltung. Es erlaubt die strukturierte Abfrage und Verwaltung von Benutzerkonten, Gruppen, Rechten und weiteren Objekten in einem Verzeichnisbaum. In Verbindung mit TLS (LDAPS) lässt sich auch die Übertragung absichern. - Kerberos

Kerberos bietet ein sicheres Ticket-basiertes Verfahren, bei dem sich Benutzer einmal zentral authentifizieren (Single Sign-On) und dann für den Zugriff auf andere Dienste kryptografisch signierte Tickets verwenden. Dies reduziert Passworteingaben und minimiert Angriffsflächen, da Passwörter nicht ständig im Netzwerk übertragen werden.

Beide Verfahren sind fester Bestandteil moderner Unternehmensnetzwerke, insbesondere in Windows-Domänen (Active Directory Services), aber auch in heterogenen Umgebungen.

Zugriff kontrollieren – aber richtig

Autorisierung ist kein bloßes Häkchen im Admin-Tool, sondern ein strategischer Bestandteil der Netzwerksicherheit. Es geht darum, Rechte granular und nachvollziehbar zu vergeben – nach dem Prinzip:

„So wenig wie möglich, so viel wie nötig.“

Typische Autorisierungsmodelle:

- RBAC (Role-Based Access Control)

Rechte werden auf Basis von Rollen vergeben (z.B. Support, Buchhaltung, IT-Admin). Einzelne Anwender:innen erhalten nur die Rechte, die ihrer Rolle entsprechen - ABAC (Attribute-Based Access Control)

Zugriff wird anhand von Attributen bewertet – etwa Standort, Uhrzeit, Gerätestatus oder Sicherheitsklassifikation

Diese Modelle lassen sich kombinieren und über zentrale Richtliniensysteme wie Microsoft Group Policy oder moderne Identity- und Access-Management-Systeme (IAM) verwalten.

Authentifizierung im Wandel – neue Herausforderungen

In Zeiten verteilter Systeme, Homeoffice und Cloud-Diensten reicht die klassische Netzwerkanmeldung längst nicht mehr aus. Unternehmen müssen heute Identitäten plattformübergreifend verwalten und absichern – über Standorte, Geräte und Dienste hinweg.

Das bedeutet:

- Integration von Cloud-Diensten in hybride Identitätslandschaften (Microsoft Entra ID, Google Identity etc.)

- Mehr-Faktor-Authentifizierung (MFA) als Standard, nicht als Option

- Passwortlose Verfahren (z.B. via FIDO2, biometrisch, Smartcard)

- Zentrales Monitoring und Reporting aller Anmelde- und Zugriffsversuche

Ein Passwort allein ist keine Sicherheit. Erst das Zusammenspiel aus Technik, Benutzerführung und Überwachung schafft vertrauenswürdige Zugriffskontrollen.

Fazit

Authentifizierung und Autorisierung sind die unsichtbare Infrastruktur jedes sicheren Netzwerks. Sie bilden den Kontrollpunkt zwischen verschlüsselter Verbindung und tatsächlicher Nutzung. In der Umsetzung erfordern sie technische Standards, durchdachte Policies – und ein Bewusstsein dafür, dass Vertrauen im Netzwerk stets verdient werden muss.

Nur wer weiß, mit wem er es zu tun hat (und was dieser jemand darf), kann Netzwerke kontrolliert und sicher betreiben.

Doch um diese digitalen Vertrauensbeziehungen auch physisch und logisch durchzusetzen, braucht es eine Architektur, die Grenzen sichtbar macht – und konsequent verteidigt. Genau hier kommen Firewalls und Netzwerkzonen ins Spiel.

Firewalls und Netzwerkzonen – Grenzen sichtbar machen und durchsetzen

Wer ein Netzwerk betreibt, betreibt nicht einfach nur Datenübertragung – er betreibt Grenzmanagement. Die zentrale Frage lautet: Welche Systeme dürfen mit welchen anderen Systemen wie kommunizieren – und unter welchen Bedingungen?

Spätestens an diesem Punkt kommt kein Unternehmen mehr um den Einsatz von Firewalls und Zonenlogik herum. Denn in einer Welt, in der interne und externe Systeme miteinander kommunizieren, Cloud-Dienste eingebunden und Remote-Zugriffe alltäglich sind, genügt es nicht mehr, alles hinter einer Firewall zu verstecken. Sicherheit entsteht nicht durch das Vorhandensein einer Barriere, sondern durch ihre richtige Positionierung, Konfiguration und Einbettung in ein Zonenmodell.

Klassische und moderne Firewall-Konzepte im Überblick

Firewalls gibt es in verschiedenen Ausprägungen – historisch gewachsen und technologisch weiterentwickelt. Dabei unterscheidet man grob zwischen drei Typen:

- Stateless Firewalls analysieren jeden Datenpaketfluss isoliert. Sie betrachten Quell- und Ziel-IP, Port und Protokoll, aber keinen Kontext. Vorteile: schnell, ressourcenschonend. Nachteil: keine Zustandsverfolgung – bei TCP-Verbindungen potenziell lückenhaft.

- Stateful Firewalls hingegen merken sich den Zustand einer Verbindung. Sie erkennen, ob ein Paket zu einer bestehenden Sitzung gehört, und filtern gezielt neue, unerwünschte Verbindungsversuche heraus.

- Next Generation Firewalls (NGFW) gehen noch weiter: Sie analysieren den Datenverkehr auf Anwendungsebene, erkennen Protokolle unabhängig vom verwendeten Port, können Benutzer kontextbezogen identifizieren und sogar Bedrohungen wie Malware oder bekannte Angriffsmuster blockieren.

Moderne Firewalls agieren nicht nur wie Türsteher, sondern zunehmend wie Sicherheitsdienste mit Gesichtserkennung, Ausweiskontrolle und Echtzeitbedrohungsanalyse.

Das Zonenmodell: Segmentierung als Sicherheitsstrategie

Ein wirksamer Schutz entsteht jedoch erst im Zusammenspiel mit einer klugen Netzwerkarchitektur. Hier kommt das Zonenmodell ins Spiel: Es unterteilt das Netzwerk in funktionale Bereiche mit jeweils eigenen Sicherheitsniveaus – und trennt diese durch definierte Kommunikationsgrenzen.

Typische Zonen in der Praxis:

- DMZ (Demilitarisierte Zone): Der isolierte Pufferbereich für öffentlich erreichbare Systeme wie Webserver, Mail-Gateways oder Reverse Proxys. Sie ist von innen und außen erreichbar – jedoch nur kontrolliert.

- LAN (Local Area Network): Das interne, vertrauenswürdigere Netz – Arbeitsplatzrechner, interne Server, lokale Anwendungen.

- Restricted Zone / Secure Network: Besonders geschützte Zonen mit sensiblen Systemen, z.B. für HR, Finanzwesen, OT/SCADA oder Backup-Infrastrukturen.

- WAN (Wide Area Network): Die öffentliche Netzwerkwelt – typischerweise das Internet.

Die Kommunikation zwischen diesen Zonen erfolgt über firewallgesicherte Übergänge – nach dem Prinzip: Nur was notwendig ist, wird explizit erlaubt.

Praxisbeispiel: Segmentierte Netzarchitektur im Mittelstand

Ein mittelständisches Unternehmen betreibt eine webbasierte Kundenplattform, einen internen Fileserver, eine Office-365-Integration sowie Remote-Zugänge für Dienstleister.

Die resultierende Segmentierung könnte so aussehen:

- WAN → DMZ: Zugriff auf den Webserver (HTTP/S) via Reverse Proxy

- DMZ → LAN: Authentifizierte API-Aufrufe oder LDAP-Anfragen über fest definierte Ports

- LAN → Internet: Outbound-Verkehr für Updates, Cloud-Dienste (über Proxy)

- VPN-Zugänge: Nur via Gateway in der DMZ mit MFA und rollenbasierter Autorisierung

- Restricted Zone: Nur über dedizierte Managementsysteme, kein direkter Zugriff aus LAN oder DMZ

So entsteht eine klare Trennung zwischen extern erreichbaren Komponenten und kritischen internen Systemen – mit Firewalls als technische Grenzwächter und einem Zonenmodell als konzeptionellem Rahmen.

Herausforderungen in der Praxis

Zonenmodelle sind kein Selbstläufer – ihre Einführung und Pflege erfordern:

- Dokumentation und Revision: Änderungen im Netzwerk dürfen nicht an der Firewall vorbeigehen.

- Genaue Anforderungsanalysen: Wer spricht mit wem – und warum?

- Pflege der Ausnahmefälle: Notfallfreigaben, temporäre Regeln, Legacy-Systeme

- Regelwerke mit Augenmaß: Zu offen ist gefährlich, zu restriktiv blockiert den Betrieb.

Wer nicht dokumentiert, wo sich seine Netzwerkgrenzen befinden, verliert früher oder später die Kontrolle – unabhängig von der Firewall-Technologie.

Fazit

Firewalls und Zonen sind die strukturellen Grundelemente einer belastbaren Netzwerksicherheitsarchitektur. Sie stellen sicher, dass Kommunikation nicht nur funktioniert, sondern auch kontrolliert, begrenzt und nachvollziehbar abläuft. Dabei geht es nicht nur um Technik – sondern um Verantwortung für Informationsflüsse im Unternehmen. Sicherheit im Netzwerk entsteht dort, wo bewusst entschieden wird, was erlaubt ist – und nicht dort, wo zufällig nichts passiert.

Doch diese Haltung ist das Ergebnis jahrzehntelanger Erfahrungen, Rückschläge und Paradigmenwechsel. In den Anfängen digitaler Kommunikation war Kontrolle kein erklärtes Ziel, Vertrauen war der Standard. Ein Blick zurück zeigt, warum sich das grundlegend ändern musste.

Exkurs: Vom Vertrauensnetz zur Verteidigungsarchitektur – Wie Sicherheit ihren Platz im Netzwerk fand

Sicherheit ist heute ein zentrales Element jeder IT-Infrastruktur. Doch das war nicht immer so. In den Anfangsjahren der vernetzten Datenverarbeitung war Sicherheit kein Primärziel – sondern bestenfalls ein nachgelagerter Gedanke. Man befand sich in einem vertrauensvollen, kontrollierten Umfeld, geprägt von Forschungsnetzwerken, Universitäten und geschlossenen Systemen.

Das Motto lautete: Wir sind unter Freunden.

Die Ursprünge: Als Netzwerke noch friedlich waren

Als das ARPANET – als Vorläufer des heutigen Internets – Ende der 1960er-Jahre entstand, war Sicherheit kein zentrales Designkriterium. Die Teilnehmer:innen waren handverlesen, die Zugangsmöglichkeiten begrenzt, das Vertrauen in die Integrität aller Beteiligten hoch.

Dementsprechend wurden viele der heute noch genutzten Protokolle ohne jegliche Schutzmechanismen entworfen:

- DNS erlaubt Manipulation ohne Prüfsummen oder Signaturen

- IP bietet keinerlei Authentizität oder Integritätsschutz

- Telnet überträgt Login-Daten im Klartext

Man ging schlicht davon aus, dass niemand mit böswilliger Absicht das Netz nutzen würde. Sicherheit war somit eine soziale Annahme, keine technische Anforderung.

Die Windows-Welt – Offenheit als Standard

Dieses Grundvertrauen setzte sich auch in der kommerziellen IT-Welt fort. Besonders prägnant war dies in Microsoft-Systemen der frühen 1990er-Jahre. Windows 95, 98 oder ME boten Netzwerkfunktionen, Dateifreigaben und Internetverbindungen – aber keine Firewall, keine Benutzerisolierung, keine Rechteverwaltung im heutigen Sinne.

Selbst professionelle Windows-NT- oder 2000-Systeme konnten standardmäßig über unsichere Dienste wie SMBv1 oder NetBIOS erreicht werden. Sicherheitslösungen wie Antivirenprogramme oder Host-Firewalls mussten manuell installiert, gepflegt und gekauft werden – oft wurden sie als Option, nicht als Notwendigkeit betrachtet.

Erst mit der wachsenden Zahl von Bedrohungen und den massiven Auswirkungen von Wurm-Angriffen wie Blaster oder Sasser änderte sich dieses Denken spürbar.

Der Wendepunkt: Windows XP Service Pack 2

Mit dem Service Pack 2 für Windows XP, veröffentlicht 2004, erfolgte eine fundamentale Kurskorrektur:

- Eine Firewall wurde erstmals standardmäßig aktiviert

- Das neue Sicherheitscenter überwachte den Status von Virenschutz, Updates und grundlegenden Sicherheitseinstellungen

- Remotezugriffe wurden standardmäßig deaktiviert oder eingeschränkt

- Warnhinweise erschienen beim Öffnen potenziell gefährlicher Dateien aus dem Internet

Microsoft selbst sprach von einem Paradigmenwechsel – von Connect first, secure later hin zu Secure by default.

Diese Wende markiert symbolisch die Erkenntnis, dass Betriebssysteme und Netzwerke nicht mehr als geschlossene Räume, sondern als offene, dynamische und potenziell feindliche Umgebungen betrachtet werden müssen.

Sicherheit als nachgerüstete Disziplin

Viele der Maßnahmen, die heute als selbstverständlich gelten – verschlüsselte Verbindungen, rollenbasierte Zugriffskontrolle, Protokollhärtung – wurden nicht in den Ursprungstechnologien mitgedacht, sondern später durch Zusatztechniken oder ganz neue Protokolle ergänzt:

| Ursprungstechnologie | Sicherheitsproblem | Nachgerüstete Lösung |

| DNS | Manipulierbare Namensauflösung | DNSSEC |

| HTTP | Keine Verschlüsselung | HTTPS / TLS |

| IP | Keine Authentizität | IPsec |

| SMBv1 | Unsichere Dateiübertragung | SMBv3 mit Signing & Encryption |

| Telnet | Klartext-Anmeldedaten | SSH |

| Windows OS (vor SP2) | Fehlende lokale Absicherung | Integrierte Firewall, UAC |

Diese Nachrüstungen waren notwendig – aber sie machten auch deutlich: Vertrauen ersetzt keine Architektur.

Warum das heute noch wichtig ist

Noch immer basieren viele IT-Infrastrukturen auf Technologien, deren Sicherheitslücken designbedingt sind. Wer DNS verwendet, muss DNSSEC aktiv konfigurieren. Wer IP nutzt, muss Transportverschlüsselung nachrüsten. Wer Betriebssysteme installiert, muss Richtlinien definieren, Konten verwalten und Schnittstellen absichern.

Und: Auch moderne Technologien entstehen oft wieder funktional, nicht sicher – sei es bei APIs, IoT-Geräten oder containerisierten Microservices. Der strukturelle Fehler liegt nicht nur im Code, sondern oft in der Annahme, dass Sicherheit von selbst entsteht.

Die Geschichte der IT-Sicherheit ist keine lineare Erfolgsgeschichte, sondern eine Geschichte des Umdenkens. Von blindem Vertrauen über schmerzliche Lerneffekte bis hin zu bewusst gestalteter Verteidigungsarchitektur war es ein langer Weg – der noch nicht zu Ende ist.

Wer heute Netzwerke absichern will, muss die Altlasten der Vergangenheit kennen – und daraus Schlüsse für die Zukunft ziehen.

Netzwerkmanagement und Überwachung – Sichtbarkeit schafft Sicherheit

Ein Netzwerk, das funktioniert, ist gut. Ein Netzwerk, das beobachtet wird, ist besser. Denn in der IT-Sicherheit gilt: Was nicht sichtbar ist, kann auch nicht geschützt werden.

Netzwerke entwickeln sich dynamisch – neue Geräte, Dienste, Verbindungen entstehen täglich. Ohne systematische Überwachung droht der Überblick zu verschwinden. Die Folge sind Schatten-IT, falsch konfigurierte Komponenten, unbemerkte Angriffe oder fehlerhafte Integrationen. Professionelles Netzwerkmanagement und eine durchdachte Überwachungsstrategie sind deshalb kein Luxus, sondern eine Grundvoraussetzung für den sicheren und stabilen Betrieb komplexer Infrastrukturen.

Netzwerkmanagement: mehr als nur Monitoring

Professionelles Netzwerkmanagement umfasst weit mehr als das passive Beobachten von Verbindungsdaten. Es geht um das gezielte Erfassen, Bewerten, Reagieren und Dokumentieren von Informationen aus dem gesamten Netzwerkökosystem.

Typische Aufgaben des Netzwerkmanagements:

- Bandbreitennutzung und Engpässe: Wo entstehen Lastspitzen? Welche Dienste erzeugen ungewöhnlich viel Traffic?

- Gerätestatus und Erreichbarkeit: Sind Switche, Router, Access Points oder Server aktiv und erreichbar?

- Policy-Management: Werden die definierten Regeln und Sicherheitsrichtlinien eingehalten?

- Topologie-Erkennung und -Pflege: Welche Geräte sind wo eingebunden? Wer kommuniziert mit wem?

Die technologische Grundlage bilden häufig Protokolle wie SNMP (Simple Network Management Protocol) oder spezialisierte Managementsysteme, die Zustände in Echtzeit auswerten, Grenzwerte überwachen und automatisierte Benachrichtigungen generieren.

Logging: die Pflicht zur Nachvollziehbarkeit

Im Falle eines Sicherheitsvorfalls – sei es ein Angriff, ein unautorisierter Zugriff oder eine interne Fehlkonfiguration – sind Logdaten oft die einzige Möglichkeit zur Ursachenanalyse. Umso wichtiger ist es, systematisch, konsistent und manipulationssicher zu protokollieren.

Wichtige Prinzipien für ein effektives Logging:

- Langzeitarchivierung und Datenschutz: Logs müssen revisionssicher aufbewahrt und gleichzeitig datenschutzkonform behandelt werden

- Trennung nach Schweregrad: Kritische Systemfehler, sicherheitsrelevante Vorfälle und administrative Aktionen müssen klar klassifiziert sein

- Zeitstempel und Synchronisierung: Alle Systeme benötigen eine konsistente Zeitbasis (z.B. via NTP), um Ereignisse korrekt zu korrelieren

- Zentrale Aggregation: Logdaten sollten nicht lokal gespeichert bleiben, sondern an ein zentrales System weitergeleitet werden

Ob Syslog, Windows Event Log oder proprietäre Audit-Trails – entscheidend ist die Integration in ein zentrales Auswertungssystem.

SIEM: von der Information zur Erkenntnis

Ein Security Information and Event Management-System (SIEM) hebt Logging und Analyse auf eine neue Ebene. Es sammelt, korreliert und bewertet sicherheitsrelevante Informationen aus unterschiedlichsten Quellen – in Echtzeit.

Ein gut konfiguriertes SIEM kann:

- Angriffsindikatoren erkennen, etwa durch ungewöhnliche Loginversuche oder verdächtige Datenströme

- Alarmierungen auslösen, sobald definierte Schwellenwerte überschritten werden

- Berichte für Audits und Compliance erstellen (z.B. nach ISO 27001 oder NIS2)

- Verknüpfungen zwischen Einzelereignissen erkennen, die isoliert harmlos, im Kontext aber kritisch sind

Gerade in größeren Netzwerken oder regulierten Branchen sind SIEM-Systeme inzwischen unverzichtbar – nicht nur zur Abwehr, sondern auch zur gesetzeskonformen Nachvollziehbarkeit.

NAC: Netzwerkzugang unter Kontrolle

Ein weiterer zentraler Baustein des Sicherheitsmanagements ist die Network Access Control (NAC). Hierbei wird der Zugriff auf das Netzwerk nicht pauschal gewährt, sondern abhängig vom Gerät, Benutzerstatus, Ort, Uhrzeit oder Sicherheitszustand individuell entschieden.

Typische Anwendungsfälle:

- Geräte, die keine aktuellen Patches aufweisen, werden in ein restriktives Quarantänenetz verschoben

- Externe Geräte erhalten ausschließlich Internetzugang, aber keinen Zugriff auf interne Ressourcen

- Benutzer müssen sich vor dem Zugang mit gültigen Zugangsdaten und gegebenenfalls Mehrfaktor-Authentifizierung anmelden

NAC-Lösungen arbeiten eng mit Authentifizierungsdiensten, DHCP, VLANs und Firewalls zusammen und sind ein zentrales Instrument zur dynamischen Segmentierung und Absicherung.

Fazit

Ein sicheres Netzwerk beginnt nicht mit Technik – sondern mit Überblick. Nur wer weiß, was im Netzwerk geschieht, kann Probleme erkennen, Angriffe abwehren und Systeme gezielt absichern. Netzwerkmanagement, Logging, SIEM und NAC liefern die nötigen Werkzeuge, um aus Daten fundierte Entscheidungen zu machen, technisch wie organisatorisch. Transparenz ist kein Selbstzweck, sondern die Voraussetzung für wirksame Kontrolle. Ohne Sichtbarkeit bleibt Sicherheit reine Theorie.

Doch Sichtbarkeit allein reicht nicht aus. Erst im Zusammenspiel mit strategischen Sicherheitsmodellen und regulatorischen Leitplanken wie Zero Trust und NIS2 entfaltet sie ihre volle Wirkung.

Strategische Sicherheitsansätze – Zero Trust und NIS2 im Zusammenspiel

Technische Maßnahmen wie Firewalls, Protokolle und Zugangskontrollen sind essenziell – doch sie bleiben Stückwerk, wenn kein strategisches Gesamtkonzept existiert. Denn Sicherheit ist nicht nur eine Frage von Technologie, sondern auch von Organisation, Verantwortung und Haltung.

Mit dem Zero Trust-Modell hat sich in den letzten Jahren ein Sicherheitsparadigma etabliert, das der Realität verteilter Systeme, Cloud-Infrastrukturen und hybrider Arbeitswelten Rechnung trägt. Ergänzt wird es durch gesetzliche und regulatorische Rahmenwerke wie die NIS2-Richtlinie, die Anforderungen an Sicherheit, Nachvollziehbarkeit und Resilienz auf struktureller Ebene verankern.

Zero Trust: Vertrauen ist keine Voreinstellung

Zero Trust basiert auf einer simplen, aber radikalen Grundannahme: Vertraue niemandem – weder intern noch extern – ohne kontinuierliche Prüfung. Anders als klassische perimeterbasierte Sicherheitsmodelle, die ein klares Innen und Außen definieren, betrachtet Zero Trust jede Anfrage, jedes Gerät und jede Verbindung als potenziell kompromittiert – unabhängig vom Netzwerksegment oder Standort.

Kernprinzipien des Zero Trust-Ansatzes:

- Explizite Authentifizierung und Autorisierung: Jede Zugriffsanfrage wird individuell bewertet – auf Basis von Identität, Gerätestatus, Ort, Zeitpunkt und Sensibilität der Ressource.

- Least Privilege Access: Nutzer, Dienste und Systeme erhalten nur die minimal nötigen Rechte – zeitlich begrenzt und kontextabhängig.

- Permanente Überwachung: Zugriffskontrollen sind kein einmaliges Ereignis, sondern ein kontinuierlicher Prozess – unterstützt durch Telemetrie, Anomalieerkennung und Policy Enforcement.

- Segmentierung und Microsegmentation: Netzwerke und Dienste werden in kleine, isolierte Einheiten aufgeteilt, zwischen denen Kommunikation gezielt freigegeben wird.

Zero Trust ist kein Produkt, sondern ein Konzept. Es lässt sich in vorhandene Strukturen integrieren – z.B. über NAC, MFA, Identity & Access Management, Conditional Access, Container-Isolation oder Zero Trust Network Access (ZTNA)-Lösungen.

NIS2: Sicherheit wird zur europäischen Pflicht

Mit der überarbeiteten NIS2-Richtlinie (EU 2022/2555) wurde der gesetzliche Rahmen für Cybersicherheit in der EU deutlich erweitert. NIS steht dabei für Netzwerk- und Informationssicherheit. Ziel ist es, die Widerstandsfähigkeit kritischer und wichtiger Einrichtungen gegenüber Cyberbedrohungen zu stärken – von Energieversorgern und Gesundheitsdienstleistern über digitale Infrastrukturen bis hin zu mittelständischen Unternehmen in sicherheitsrelevanten Branchen.

Die Richtlinie verpflichtet betroffene Organisationen unter anderem zu:

- Audits, Dokumentationspflichten und Compliance-Nachweisen

- Benennung einer verantwortlichen Kontaktstelle für IT-Sicherheit

- Meldung schwerwiegender Sicherheitsvorfälle innerhalb von 24 Stunden

- regelmäßigen Risikoanalysen und Bewertung der Sicherheitslage

- technischen und organisatorischen Sicherheitsmaßnahmen (u.a. Zugriffskontrolle, Netzwerksicherheit, Vorfallmanagement)

Für viele Unternehmen bedeutet das: Cybersicherheit ist nicht mehr nur Best Practice, sondern rechtlich verbindliche Erwartung. Verstöße können – abhängig von Umsatz und Sektor – zu empfindlichen Sanktionen führen.

Zero Trust und NIS2: zwei Perspektiven, ein Ziel

Während Zero Trust ein technisches Architekturprinzip ist, das Vertrauen durch Prüfung ersetzt, setzt NIS2 als regulatorisches Framework verbindliche Maßstäbe für Governance, Nachvollziehbarkeit und Risikomanagement. Beide greifen ineinander:

| Zero Trust | NIS2 |

| Technisches Kontrollprinzip | Gesetzlicher Rahmen für IT-Sicherheitsanforderungen |

| Fokus auf Identität, Kontext, Telemetrie | Fokus auf Struktur, Verantwortlichkeit, Reaktion |

| Umsetzung über IAM, NAC, MFA, ZTNA usw. | Umsetzung über Prozesse, Rollen, Pflichten |

| Erhöht Transparenz und Zugriffssicherheit | Erzwingt Berichts- und Handlungsfähigkeit |

Gemeinsam fördern sie eine Sicherheitskultur, in der Risiken frühzeitig erkannt, kontrolliert und systematisch adressiert werden – unabhängig davon, ob ein Zugriff aus dem internen Netzwerk, der Cloud oder einem Homeoffice erfolgt.

Fazit

Sicherheit im Jahr 2025 bedeutet mehr als Firewalls und Virenscanner. Sie bedeutet strategisches Denken, systematische Kontrolle und organisatorische Verankerung. Zero Trust liefert das technische Modell, NIS2 den rechtlichen Rahmen. Unternehmen, die beides ernst nehmen, schaffen nicht nur ein sicheres Netzwerk – sie schaffen Vertrauen durch Kompetenz und Nachweisbarkeit.

Sicherheit wird dort zur Realität, wo Kontrolle auf Klarheit trifft – und Verantwortung nicht delegiert, sondern strukturiert gelebt wird.

Denn Kontrolle und Strategie allein genügen nicht, wenn die kryptografischen Verfahren dahinter leicht angreifbar sind. Das eigentliche Wettrennen findet auf Bit-Ebene statt, gegen Zeit, Rechenleistung und technische Entwicklung.

Exkurs: Cipher Suites, Schlüssellängen und das Rennen gegen die Rechenleistung

Verschlüsselung ist längst ein unverzichtbarer Bestandteil moderner Netzwerke. Doch sie ist kein Zustand, sondern ein Versprechen mit Verfallsdatum – denn ihre Sicherheit hängt nicht allein vom eingesetzten Verfahren ab, sondern auch von der verfügbaren Rechenleistung, der Angriffsstrategie und der richtigen Kombination kryptografischer Bausteine.

Was heute als sicher gilt, kann morgen durch neue Angriffsvektoren, effizientere Algorithmen oder technologische Durchbrüche obsolet werden. Wer Sicherheit ernst nimmt, muss daher nicht nur verschlüsseln – sondern richtig verschlüsseln.

Was sind Cipher Suites?

Im Kontext von TLS – also bei verschlüsselter Kommunikation im Web, bei Mailservern oder API-Verbindungen – legt eine sogenannte Cipher Suite fest, welche Algorithmen und Verfahren in welcher Kombination verwendet werden. Sie definiert unter anderem:

- Digitale Signaturen (z.B. ECDSA, RSA)

- Hashverfahren zur Integritätsprüfung (z.B. SHA-256)

- Schlüsselaustauschverfahren (z.B. ECDHE, RSA)

- Verschlüsselungsalgorithmus (z.B. AES, ChaCha20)

Nicht jede Kombination ist gleich sicher – veraltete Cipher Suites wie RC4, 3DES oder MD5 sind heute kryptografisch kompromittiert und sollten konsequent deaktiviert werden. Moderne Cipher Suites nutzen mindestens AES mit 128 oder besser 256 Bit in Kombination mit ECDHE und SHA-2-basierten Hashes.

Die Rolle der Schlüssellänge – mehr als nur Zahlen

Ein weit verbreiteter Irrglaube ist: Hauptsache verschlüsselt. Doch Verschlüsselung allein ist nur so stark wie ihr Schlüssel. Ein 1024-Bit-RSA-Schlüssel mag vor zehn Jahren als sicher gegolten haben – heute lässt er sich mit genügend Ressourcen innerhalb weniger Stunden brechen. Die zunehmende Rechenleistung und Parallelisierung auf GPUs oder Cloud-Clustersystemen verkürzt die effektive Lebensdauer kryptografischer Verfahren erheblich.

Orientierungswerte für heute empfohlene Schlüssellängen:

| Verfahren / Typ | Empfohlene Schlüssellänge (2025) | Effektive Sicherheit / Anwendung |

| RSA Asymmetrisch |

≥ 2048 Bit | ≈ 112 Bit TLS 1.2 (eingeschränkt), Signatur |

| ECC (Curve 25519, P-256) Asymmetrisch |

≥ 256 Bit | ≈ 128 Bit TLS 1.3, SSH, moderne VPNs |

| AES Symmetrisch |

≥ 128 Bit | ≈ 128 Bit Verschlüsselung (z.B. Daten, Festplatten) |

Besonders asymmetrische Verfahren wie RSA und DSA benötigen sehr lange Schlüssel, um dieselbe Sicherheit zu erreichen wie moderne elliptische Kurvenalgorithmen (ECC).

Das Rennen gegen die Hardware

Moderne Kryptographie steht in ständigem Wettbewerb zur Rechenleistung – und Letztere wächst schneller als je zuvor. Was vor 20 Jahren Mainframe-Niveau hatte, steckt heute in der Hosentasche. Komplexe Brute-Force-Angriffe lassen sich längst automatisieren und skalieren, etwa über Botnetze oder Cloud-Cluster mit dedizierten GPU-Kapazitäten.

Beispielhafte Entwicklungen:

- Ein 56-Bit DES-Schlüssel kann mit spezialisierter Hardware in Sekunden gebrochen werden.

- Selbst 128-Bit-Schlüssel sind bei symmetrischer Verschlüsselung in der Theorie angreifbar – aber nur mit extrem hohem Aufwand.

- Schwache Hashfunktionen wie MD5 gelten als gebrochen – gezielte Kollisionen ermöglichen Signaturfälschungen in der Praxis.

Die Konsequenz: Sicherheit muss antizipativ gedacht werden. Wer heute Standards einführt, muss die Sicherheitslage von morgen bereits mitdenken.

Quantencomputer: der Paradigmenbruch

Mit der Weiterentwicklung von Quantencomputern steht die Kryptographie vor einem möglichen disruptiven Ereignis. Während klassische Computer nur einen Zustand pro Rechenschritt bearbeiten, arbeiten Quantencomputer mit Superpositionen – sie können gleichzeitig viele Zustände verarbeiten. Damit eröffnen sich neue Angriffsszenarien:

- Shor’s Algorithmus kann RSA und ECC effizient faktorisieren – bisherige Public-Key-Kryptographie wäre damit vollständig kompromittiert.

- Grover’s Algorithmus halbiert effektiv die Sicherheit symmetrischer Verfahren – ein 128-Bit-AES-Schlüssel hätte dann nur noch 64 Bit effektive Sicherheit.

Das bedeutet: Die gängigen Verfahren, auf denen HTTPS, VPNs, E-Mail-Verschlüsselung und digitale Signaturen heute basieren, wären im Post-Quantum-Zeitalter angreifbar.

Post-Quantum-Kryptographie – die Antwort auf morgen

Die gute Nachricht: Die Forschung arbeitet bereits an Lösungen. Im Rahmen des NIST-Wettbewerbs zur Post-Quantum-Kryptographie wurden erste Verfahren wie CRYSTALS-Kyber (Schlüsselaustausch) und CRYSTALS-Dilithium (digitale Signaturen) als neue Standards vorgeschlagen. Diese Verfahren basieren auf Gittern, Codes oder Multivariaten Polynomen und gelten – Stand heute – als sicher gegen Quantenangriffe.

Doch bis diese Verfahren breit implementiert sind, gilt:

- Hybride Verfahren (klassisch + post-quantum) gewinnen an Bedeutung

- Krypto-Agilität muss zur Anforderung werden: Systeme müssen austauschbare Algorithmen und Schlüsselverfahren unterstützen

- Laufzeitkritische Anwendungen (z. B. IoT) brauchen effiziente Quanten-resistente Verfahren

Fazit

Kryptographische Sicherheit ist keine Einmalentscheidung – sie ist ein kontinuierlicher Prozess aus Bewertung, Anpassung und Weitsicht. Die Wahl starker Cipher Suites, ausreichend langer Schlüssel und die konsequente Entfernung veralteter Verfahren sind heute unverzichtbar. Wer zusätzlich die Entwicklungen im Bereich Quantum-Computing im Blick behält und auf krypto-agile Systeme setzt, bleibt auch morgen resilient.

Sicherheit entsteht nicht durch Verschlüsselung an sich – sondern durch das Verständnis dafür, wie sie wirkt, wo sie schwächelt und wann sie erneuert werden muss.

Praxisbeispiel: Netzwerksegmentierung mit Sicherheitsarchitektur

Sicherheitsstrategien wie Zero Trust, NAC und Firewalls gewinnen erst dann an Wert, wenn sie konsequent in die Netzwerkarchitektur eingebettet werden. Theoretische Konzepte entfalten ihre Wirksamkeit durch eine klare, überprüfbare und nachvollziehbare Umsetzung in der Infrastruktur.

Ein bewährter Ansatz dafür ist die Netzwerksegmentierung, also die gezielte Trennung von IT-Komponenten, Nutzergruppen und Diensten in logisch oder physisch isolierte Zonen – jeweils mit eigenständigen Sicherheitsregeln. Ziel ist es, Angriffsflächen zu minimieren, Bewegungsfreiheit von Angreifern einzuschränken und Kommunikation auf das Notwendige zu begrenzen.

Ausgangssituation: Mittelständisches Unternehmen mit hybrider IT-Landschaft

Ein Unternehmen mit rund 200 Mitarbeitenden betreibt:

- eine klassische Office-IT mit Active Directory, Fileservern und Exchange-System

- eine webbasierte Kundenplattform (z.B. für Terminbuchung oder Bestellverfolgung)

- Remote-Zugänge für Mitarbeitende im Homeoffice

- ein zentrales ERP-System

- cloudbasierte Dienste (Microsoft 365, Teams, Salesforce)

- diverse IoT-Komponenten im Produktionsumfeld (z.B. Messsysteme, Sensorik)

Die Geschäftsführung möchte den Schutz sensibler Kundendaten und die Widerstandsfähigkeit gegen Cyberangriffe verbessern – gleichzeitig sollen bestehende Dienste weiter nutzbar bleiben und das IT-Team nicht überfordert werden.

Schritt 1: Analyse und Zonierung

Zunächst wird die bestehende Netzwerklandschaft analysiert und in logische Funktionsbereiche gegliedert. Ziel ist eine segmentierte Struktur mit klaren Kommunikationsgrenzen:

| Zone | Inhalt | Schutzbedarf |

| DMZ | Webserver, Reverse Proxy, Auth-Gateway | hoch |

| Guest/VPN Zone | Remote-Zugriffe, externe Dienstleister | hoch |

| IoT/OT Zone | Sensorik, SCADA, Embedded Devices | hoch |

| LAN | Office-IT, Drucker, Fileserver, Workstations | mittel |

| Secure Zone | ERP-Systeme, Backupserver, Datenbanken | sehr hoch |

| WAN | Internet, externe Zugriffspunkte | hoch |

Jede Zone wird über eine dedizierte VLAN-Konfiguration abgebildet und durch segmentierende Firewalls oder Layer-3-Switching mit Access Control Lists (ACLs) voneinander abgegrenzt.

Schritt 2: Kommunikationsregeln festlegen

Anhand des Need-to-Know-Prinzips werden nur solche Verbindungen zwischen Zonen zugelassen, die für den Geschäftsbetrieb erforderlich sind. Beispiele:

- Der Webserver in der DMZ darf nur via HTTPS auf einen Authentifizierungsdienst im LAN zugreifen – nicht auf Datenbanken oder Fileserver.

- VPN-Benutzende gelangen zunächst in eine isolierte Quarantänezone, bis ihre Geräte via NAC als sicher bewertet werden.

- IoT-Geräte dürfen ausschließlich per MQTT mit einem zentralen Broker kommunizieren, nicht mit Clients oder Cloud-Diensten direkt.

- Das ERP-System ist nur über dedizierte Applikations-Gateways erreichbar – keine direkte Datenbankverbindung aus dem LAN.

Zusätzlich werden Firewall-Logging und SIEM-Anbindung konfiguriert, um alle Zonengrenzen zu überwachen und potenzielle Regelverstöße sichtbar zu machen.

Schritt 3: Integration organisatorischer Maßnahmen

Technische Segmentierung allein genügt nicht – sie wird flankiert durch:

- Netzwerkpläne und Firewall-Regelwerke als Teil der IT-Dokumentation

- Patch-Management und Asset-Dokumentation in allen Zonen

- Protokollhärtung: Deaktivierung unsicherer Dienste wie SMBv1, Telnet, FTP

- Rollenkonformes Rechtemanagement via Active Directory und Entra ID

- Verbindliche Richtlinien für Fernzugriffe (z.B. nur mit MFA und dienstlichen Geräten)

Auf diese Weise entsteht ein ganzheitliches Sicherheitskonzept, das technische, organisatorische und personelle Aspekte vereint.

Fazit

Netzwerksegmentierung ist keine kosmetische Maßnahme, sondern ein zentrales Instrument zur Begrenzung von Risiken und zur Wahrung der Kontrolle über Datenflüsse. Sie macht sichtbar, was geschützt werden muss, und schafft Strukturen, auf denen Zero Trust und Compliance-Anforderungen aufbauen können.

Ein sicheres Netzwerk ist kein unkontrolliertes Netz, sondern eine gezielte, dokumentierte Struktur mit bewusst gesteuerten Übergängen.

Fazit und Ausblick – Sicherheit beginnt mit Verantwortung

Die sichere Gestaltung von Netzwerken ist weit mehr als eine technische Herausforderung – sie ist Ausdruck von Verantwortungsbewusstsein, Weitsicht und Organisationskompetenz. In den vergangenen Abschnitten haben wir gesehen, wie die oberen Schichten des OSI-Modells – Sitzung, Darstellung und Anwendung – zum strategischen Brennpunkt moderner IT-Sicherheit werden. Sie sind der Ort, an dem Nutzende auf Daten zugreifen, Systeme untereinander kommunizieren und Geschäftsprozesse realisiert werden.

Genau hier gilt es, Vertrauen nicht vorauszusetzen, sondern gezielt zu gestalten – durch sichere Protokolle, starke Authentifizierung, wirksame Zugriffskontrollen, strukturierte Netzwerkarchitektur und ein konsequentes Management sicherheitsrelevanter Vorgänge. Ob SMB, TLS, HTTP oder LDAP: Jedes dieser Protokolle bringt Chancen und Risiken mit sich – und muss aktiv abgesichert und kontinuierlich überwacht werden.

Wir haben beleuchtet, wie Firewalls und Zonenmodelle Netzwerke strukturieren, wie Logging und SIEM Transparenz schaffen und wie strategische Konzepte wie Zero Trust und NIS2 die technische Sicherheit in organisatorische Verantwortung überführen. In Praxisbeispielen wurde deutlich, dass selbst komplexe IT-Landschaften mit klarer Segmentierung und durchdachter Zugriffskontrolle beherrschbar bleiben – wenn sie von Prinzipien wie Need-to-Know, Least Privilege und Auditability getragen werden.

Drei zentrale Erkenntnisse für die Praxis

- Technik allein genügt nicht

Sicherheit entsteht im Zusammenspiel von Architektur, Konfiguration, Überwachung und organisatorischem Handeln - Vertrauen muss überprüfbar sein

Wer auf Identitäten, Zugriffsrechte und Kommunikationspfade nicht kontrolliert zugreift, riskiert blinde Flecken – und im schlimmsten Fall: Kontrollverlust - Regulatorik ist kein Hindernis, sondern Orientierung

NIS2 und ähnliche Rahmenwerke helfen dabei, Sicherheitsanforderungen strukturiert, verpflichtend und nachvollziehbar umzusetzen

Der Weg geht weiter: Netzwerksicherheit über Grenzen hinaus

Mit diesem Beitrag schließen wir die dritte Etappe unserer Netzwerkreihe ab – von Bits und Protokollen bis hin zu Firewalls, Authentifizierung und Governance. Wir haben gesehen: Sicherheit beginnt nicht auf der Leitung, sondern an der Schnittstelle zwischen Mensch, Maschine und Management.

Doch Netzwerke verändern sich. Sie reichen heute weit über das Rechenzentrum hinaus, in Cloud-Plattformen, API-Gateways, Container-Cluster und mobile Endgeräte. Die Frage ist nicht mehr wo Sicherheit beginnt, sondern wie sie im Fluss verteilter Systeme erhalten bleibt.

Im nächsten Beitrag wagen wir den Schritt in diese neue Realität:

- Wie sichern wir Cloud-Infrastrukturen und hybride Architekturen ab?

- Welche Rolle spielen SASE, ZTNA und dynamische Zugriffskontrolle?

- Und wie verändert sich Netzwerksicherheit in einer Welt aus Microservices, IoT und Automatisierung?

Ich lade Sie ein, diesen Weg weiter mitzugehen – mit technischem Tiefgang, strategischer Perspektive und einem klaren Ziel: Vertrauen in IT durch Sicherheit, die nicht auf Annahmen beruht, sondern auf Prinzipien.

Teil 1 oder 2 verpasst?

Hier finden Sie die bisherigen Stationen unserer Reihe:

Warum jedes Bit seinen Weg braucht – Der Weg zur intelligenten Kommunikation

Wenn Pakete reisen lernen – Vermittlung und Transport im IP-Zeitalter