Hinweis zur Aktualisierung

Dieser Beitrag wurde ursprünglich am 19.12.2025 veröffentlicht und am 29.12.2025 inhaltlich erweitert. Die Aktualisierung umfasste insbesondere die detaillierte Diskussion der Hardware-Konfiguration, die Einordnung der einzelnen Komponenten sowie den Übergang zur praktischen Umsetzung des Systemaufbaus.

Am 16.01.2026 wurde der Beitrag erneut ergänzt. Hinzugekommen sind aktuelle Exkurse zur Marktentwicklung bei Grafikkarten, zu Preis- und Verfügbarkeitsveränderungen im Consumer-GPU-Segment sowie zur strategischen Verknappung ausgewählter Modelle im Kontext wachsender KI-Nachfrage.

Warum ich zum Jahreswechsel meinen eigenen Copilot+ PC bauen möchte

Der Jahreswechsel ist für mich traditionell der Zeitpunkt, meinen Arbeitsrechner technisch zu erneuern und die Systemarchitektur an neue Anforderungen anzupassen. Für meine beruflichen Schwerpunkte – Microsoft, Cisco und KI – nutze ich seit Jahren selbst gebaute Desktop-Systeme. Sie bieten mir maximale Kontrolle über Komponenten, Leistung, Energieeffizienz und Erweiterbarkeit.

Ein Gespräch aus dem Seminaralltag

In Seminaren und Workshops komme ich immer wieder auf das Thema PC-Hardware zu sprechen. Wenn Teilnehmende fragen, auf welchen Systemen ich arbeite oder wie ich meine Testumgebungen aufbaue, erwähne ich ganz selbstverständlich, dass ich meine Heim-PCs zumeist selbst zusammenstelle. Zuletzt meinte ein Teilnehmer mit einem Schmunzeln zu mir: „Sie wissen, dass Sie Computer auch fertig kaufen können?!?“ – ein charmantes Beispiel dafür, wie sehr sich Generationen im Umgang mit Technik unterscheiden. Für mich bleiben Selbstbau-Systeme jedoch der beste Weg, meine Arbeitsumgebung konsequent an meine beruflichen Anforderungen anzupassen.

Ein Technologiesprung: KI wird lokal

In diesem Jahr steht allerdings ein grundsätzlicher Wandel an: KI wird lokal. Windows 11 verlagert zentrale Fähigkeiten in Richtung On-Device-AI, und mit den Copilot+ PC Konzepten rückt eine neue Gerätekategorie in den Fokus. Viele dieser Systeme sind derzeit in mobiler Bauform verfügbar, etwa in Form moderner Surface-Generationen oder OEM-Notebooks. Doch diese Geräte passen weder zu meinen Arbeitsgewohnheiten noch zu meinem Anspruch, meine Systeme selbst zu konfigurieren, aufzurüsten und langfristig zu betreiben.

Die Leitfrage dieses Beitrags

Daher stellt sich eine grundlegende Frage: Wie lässt sich ein eigener Desktop-Arbeitsrechner so planen und aufbauen, dass er die Fähigkeiten eines Copilot+ PCs vollständig oder weitgehend abdeckt – und zugleich die Flexibilität eines klassischen DIY-Systems bietet?

Was dieser Beitrag leistet

In diesem Beitrag arbeite ich heraus, welche Anforderungen Microsoft an Copilot+ Systeme definiert, welche technischen Merkmale wirklich relevant sind und welche Komponenten heute sinnvoll sind, um einen künftigen KI-Arbeitsrechner nachhaltig aufzubauen. Zugleich zeige ich Alternativen auf: von Foundry Local über Windows-AI-Frameworks bis hin zu Hardwaretrends wie PCIe-basierten NPU-Beschleunigern. Das Ziel ist eine nüchterne, fundierte und praxisnahe Bewertung, die Administrator:innen, Enthusiast:innen und Technikinteressierten Orientierung bietet.

Was definiert einen Copilot+ PC wirklich?

Microsoft hat mit den Copilot+ PCs eine neue Gerätekategorie etabliert, die sich grundsätzlich von klassischen Windows-Systemen unterscheidet. Ursprünglich wurde dieses Konzept vor allem im mobilen Segment platziert, doch der eigentliche Kern liegt tiefer: Copilot+ definiert eine AI-native Architektur, in der lokale Modelle, hohe Rechenleistung und energieeffiziente NPU-Beschleunigung zusammenwirken. Die Grundlagen dazu habe ich bereits im Beitrag Windows 11 26H1 – Architekturwandel für die KI-PC-Hardware ausführlich eingeordnet. Für mich ist genau dieser Kern entscheidend, denn ich möchte mein Desktop-System so gestalten, dass es diese Fähigkeiten möglichst umfassend bereitstellt – ohne auf ein OEM-Gerät ausweichen zu müssen.

Damit Administrator:innen, Entwickler:innen und technikaffine Leser:innen die Systemanforderungen besser einschätzen können, lohnt sich ein Blick auf die offiziellen Kriterien, auf die OEM-Interpretationen und auf die technischen Merkmale dieser neuen Plattform.

Offizielle Anforderungen von Microsoft

Microsoft definiert Copilot+ PCs als Systeme, die bestimmte Mindeststandards erfüllen. Diese beziehen sich vor allem auf die Fähigkeit, On-Device-KI performant, datenschutzfreundlich und energieeffizient auszuführen. Warum diese Beschleuniger künftig unverzichtbar werden, erläutere ich in meinem Beitrag Kleine Modelle, große Wirkung: Tiny AI im Unternehmensalltag, in dem ich beleuchte, wie kompakte Modelle durch optimierte Hardware enorme Effizienzgewinne erzielen.

Zu den wichtigsten Anforderungen zählen:

- Neural Processing Unit (NPU) mit mindestens 40 TOPS: Dies ist der Dreh- und Angelpunkt. Die NPU beschleunigt KI-Inferencing lokal, ohne dass GPU oder CPU durchgängig belastet werden. Damit werden Funktionen wie Recall, Studio Effects oder Live Captions überhaupt erst praktikabel.

- Moderne System-on-Chip Architektur: Die Plattform setzt eine hochintegrierte Architektur voraus, bei der CPU, GPU und NPU eng miteinander kommunizieren. Besonders relevant ist die Speicherbandbreite, ein Flaschenhals vieler älterer Systeme.

- Hohe SSD-Performance und schneller RAM: Windows 11 optimiert KI-Modelle dynamisch. Für ein flüssiges Modell- und Kontext-Management benötigt das System schnelle NVMe-SSDs und modernen LPDDR5 / DDR5-RAM.

- Aktuelle Firmware, Secure Boot und TPM: On-Device-KI arbeitet teilweise mit sensiblen Kontextdaten. Daher sind moderne Sicherheitsmechanismen unverzichtbar.

Auch wenn diese Anforderungen zunächst nach einem OEM-Spezialfall klingen, lassen sie sich – mit der richtigen Hardware – durchaus auf Desktop-Systeme übertragen. Genau das ist mein Ansatz.

OEM-Definitionen und praktische Variationen

Gerade im mobilen Segment setzen OEMs stark auf ARM-basierte Designs. Diesen Wandel und die Rolle von Windows-on-ARM habe ich zuletzt im Beitrag Von Windows 10 zu Windows 11, Copilot+ PCs, LTSC 2024 – und was das Supportende 2025 bedeutet eingeordnet. OEMs wie Lenovo, ASUS oder Dell interpretieren das Copilot+ Konzept jeweils etwas anders. In ihren Produktseiten und Launch-Events betonen sie neben der NPU vor allem:

- energieeffiziente ARM-Designs (z.B. Snapdragon X Elite)

- eng verzahnte Treiberpakete

- hochintegrierte SoCs

- kompakte Mainboards

- optimierte Akkulaufzeiten

Für mobile Endgeräte hat dieses Design viele Vorteile. Für meinen Desktop-Einsatz dagegen bedeutet es Einschränkungen:

- kaum Aufrüstbarkeit

- limitierte thermische Reserven

- geringe Konfigurierbarkeit

- eingeschränkte Reparaturfreundlichkeit

- Hardware oft nur in bestimmten OEM-Konfigurationen verfügbar

Der DIY-Ansatz bietet mir dagegen vollständige Kontrolle über Luftstrom, Kühlung, PCIe-Anbindung, SSD-Slots, RAM und zukünftige Upgrades. Deshalb ist für mich klar: Die OEM-Definition von Copilot+ dient als Orientierung – aber mein Ziel ist ein Desktop-System, das diese Leistungsmerkmale vollständig selbst abbildet.

Architekturmerkmale eines Copilot+ Systems

Die enge Verzahnung von CPU, GPU und NPU spiegelt den grundlegenden Wandel wider, den Windows 11 mit 26H1 vollziehen wird. Unabhängig vom Hersteller hat sich eine technische Linie herauskristallisiert, die alle Copilot+ Systeme verbindet. Drei Architekturbereiche sind dabei entscheidend:

- Die NPU als zentraler KI-Beschleuniger

- entlastet CPU und GPU

- entwickelt sich zur neuen „Baseline“ eines modernen PCs

- ermöglicht energieeffiziente KI-Inferenz

- ist Voraussetzung für viele Windows-Funktionen

- Ein hochperformantes Speicher- und I/O-Subsystem

- geringe Latenz beim KI-Kontextwechsel

- moderne RAM-Standards

- NVMe-SSDs mit hoher IOPS-Leistung

- schnelle PCIe-Anbindung

- Ein AI-optimierter Software-Stack

- Integration in Windows Studio Effects, Recall, Live Captions

- künftige Unterstützung von Personal Context und lokalen Copilot-Funktionen

- Modellverwaltung im Betriebssystem

- Windows AI APIs (DirectML, ONNX, Windows ML)

Diese Merkmale sind der eigentliche Grund, warum ich mein neues System so plane, dass es genau diese Architektur abbildet, unabhängig vom Label Copilot+.

Kritik an Microsofts bisheriger KI-Strategie

Ein weiterer Aspekt, der im DIY-Kontext relevant wird: Die bisherige KI-Umsetzung in Microsoft 365 und Windows 11 überzeugt viele Benutzer:innen noch nicht. Windows Central bezeichnete den aktuellen Ansatz deutlich als shoddy AI. Aus meiner Sicht zeigt diese Kritik:

- das Potenzial ist da

- die Umsetzung ist noch nicht reif

- Cloud-Copilot ist häufig zu langsam

- der Mehrwert im Alltag ist für viele unklar

- UI und Interaktion wirken zu generisch

- Datenschutzbedenken bremsen die Nutzung

Genau hier kommt der Copilot+ Ansatz ins Spiel: lokale KI. Sie kann einige der heute noch vorhandenen Schwächen ausgleichen. Das gilt vor allem für:

- Performance

- Kontextsensitivität

- Offline-Nutzung

- Datenschutz

- Energieeffizienz

Diese Argumentation bildet auch die Basis meiner eigenen Motivation: Ich möchte ein System aufbauen, bei dem ich lokale KI nicht als Kompromiss, sondern als Vorteil verstehe.

Marktentwicklung: Vom AI-Buzzword zum Alltagssystem

Zahlreiche Marktanalysen zeigen, dass AI-PCs sich zunehmend von Marketingbegriffen zu realen, produktiven Werkzeugen entwickeln. OEMs, Chipdesigner und die Softwareindustrie investieren Milliardenbeträge in KI-optimierte Systeme. Die Gründe sind klar:

- Cloud-KI wird teuer – lokale Modelle senken langfristig Kosten.

- Energieverbrauch in Rechenzentren steigt – lokale KI entlastet globale Infrastrukturen.

- Datenschutzanforderungen wachsen – On-Device-AI löst Compliance-Probleme.

- Benutzer:innen erwarten niedrige Latenzen – lokale Modelle reagieren sofort.

Für Admins und IT-Abteilungen sind diese Aspekte interessant, wie ich auch in anderen Beiträgen auf meinem Blog zu Windows und KI beschreibe (z.B. Windows 11 26H1, Von QDOS bis Copilot, Neue Microsoft AI-Zertifikate). AI-PCs werden 2026 und 2027 in vielen Unternehmensbereichen zur normalen Ausstattung gehören.

Der technische Unterbau: Wie Windows 11 AI-native wird

Windows 11 hat sich in den letzten Jahren spürbar verändert. Aus einem klassischen Desktop-Betriebssystem wird schrittweise eine AI-native Plattform, die lokale Modelle, optimierte Hardware und spezialisierte Beschleuniger nutzt. Dieser Wandel ist keine Marketingfloskel, sondern ein tiefgreifender Architekturwechsel. Für mein eigenes DIY-Copilot+ Projekt ist dieser Wandel zentral, weil er definiert, welche Komponenten künftig wirklich relevant sind und warum klassische Desktop-Designs zunehmend unter Druck geraten.

In diesem Kapitel analysiere ich die technischen Grundlagen, die Windows 11 zu einem KI-fähigen Betriebssystem machen, von lokalen Modellen über den Windows-AI-Stack bis hin zur Rolle moderner NPUs und der Frage, warum ARM und x86 künftig unterschiedliche Rollen spielen werden.

On-Device-Modelle: Die neue Basis von Windows 11

Mit Windows 11 26H1 beginnt Microsoft, lokale KI-Modelle fester Bestandteil des Betriebssystems werden zu lassen. Damit verschiebt sich ein Großteil der KI-Funktionalität von der Cloud auf das Gerät selbst. Das bedeutet:

- weniger Latenz

- bessere Energieeffizienz

- konsistentere Performance

- mehr Datenschutz

- geringere Abhängigkeit von Rechenzentren

Diese Entwicklung ist nicht nur technisch sinnvoll, sondern auch ökonomisch notwendig. Wie ich im Beitrag KI im Gigawatt-Zeitalter – wie OpenAI, AMD, Nvidia und Broadcom die Energiefrage neu schreiben gezeigt habe, verschlingt Cloud-basierte KI enorme Energiemengen. Lokale Modelle sind daher ein Weg, die KI nutzen zu können, ohne zentralisierte Infrastrukturen zu belasten.

Welche On-Device-Modelle nutzt Windows?

Windows 11 setzt zunehmend auf kleine, optimierte Modelle:

- Vision-Modelle für Fotoanalyse und Studio Effects

- Sprach- und Audioerkennung

- multimodale Modelle für UI-Interaktion

- Kontextmodelle für Features wie Recall

- Office-nahe Modelle für Zusammenfassungen

- zukünftige Agentic-Funktionen (Personal Context)

Diese Modelle sind stark komprimiert, quantisiert und für die NPU optimiert, ein Thema, das ich in Kleine Modelle, große Wirkung: Tiny AI im Unternehmensalltag näher beschreibe. Für einen selbst gebauten KI-PC bedeutet das: die NPU-Performance wird zum neuen Flaschenhals, nicht mehr die CPU-Taktfrequenz.

Der Windows-AI-Stack: DirectML, ONNX und Windows ML

Damit Windows 11 On-Device-KI performant ausführen kann, nutzt das System einen umfangreichen Software-Stack. Drei Komponenten sind für den DIY-Aufbau besonders relevant:

DirectML (Direct Machine Learning)

- beschleunigt KI-Workloads über GPU und NPU

- bietet breite Hardwarekompatibilität

- entscheidend für Spiele, Bildverarbeitung und Multimedia

- ermöglicht paralleles Scheduling auf CPU, GPU und NPU

ONNX Runtime (Open Neural Network Exchange Runtime)

- universelles Framework für viele Modelle

- Grundlage für Windows Studio Effects und zahlreiche Systemfunktionen

- wichtig für die Ausführung kleinerer lokaler Modelle

- unterstützt Quantisierung und Optimierungen

Windows ML (Windows Machine Learning)

- tief im Betriebssystem verankert

- liefert Basis für moderne KI-Funktionen

- agiert als Verbindung zwischen System, Treibern und Modellen

Für mich zeigt dieser Stack, dass der PC mit Windows 11 nicht länger ein statisches System ist, sondern ein AI-first Betriebssystem wird. Genau deshalb ist die Hardwareauswahl beim Selbstbau heute viel kritischer als noch vor fünf Jahren.

NPUs als Schlüsselfaktor: Intel, AMD und Qualcomm im Vergleich

Die Neural Processing Unit (NPU) ist das Herzstück jedes Copilot+ Systems. Anders als CPU und GPU ist sie nicht für universelle Lasten gedacht, sondern für:

- Embeddings

- Inferenz

- Vektorrechnungen

- Kontextinterpretation

- multimodale Pipelines

Qualcomm Snapdragon X

Die aktuelle ARM-Plattform erreicht mit über 40 TOPS eine hervorragende Effizienz, der SoC verbindet CPU, GPU und NPU eng miteinander.

AMD Strix Point / Ryzen AI

AMD bietet starke NPUs mit ausgezeichneter Energieeffizienz und hohem TOPS-Wert. Gleichzeitig bauen sie auf einer x86-Architektur auf, was für DIY-Systeme wesentlich attraktiver ist.

Intel Lunar Lake / Panther Lake

Intel hat mit Intel 18A eine neue Fertigungstechnologie angekündigt, die das Silicon fundamental verändert. Der geplante NPU-Boost ist für kommende AI-PCs enorm relevant, insbesondere, weil Intel auf Desktop- und DIY-Märkte ausgerichtet bleibt.

Für mein eigenes Projekt ist daher klar: Die NPU ist die wichtigste Komponente für einen zukunftsfähigen KI-Arbeitsrechner.

AI-Silicon der Zukunft: Intel 18A und Microsofts eigene Chips

In den nächsten Jahren wird sich die PC-Landschaft drastisch verändern. Die Kooperationen zwischen Intel und Microsoft sowie Entwicklungen rund um eigene Microsoft-AI-Chips zeigen: KI wird nicht länger als Add-on verstanden, sondern wird zur zentralen Rechenschicht.

Die Quelle zu Intel 18A und der Zusammenarbeit mit Microsoft zeigt, dass AI-Silicon:

- energieeffizienter

- dichter

- schneller

- modularer

werden muss. Für Enthusiast:innen und DIY-Systembauer:innen bedeutet das eine gute Nachricht: Wir nähern uns einer Ära, in der AI-Beschleuniger als PCIe-Karten oder modulare Chips wieder verfügbar und aufrüstbar werden.

Architekturentscheidungen für DIY-Systeme: ARM oder x86?

Beide Architekturen, ARM und x86, stehen derzeit an einem entscheidenden Scheideweg.

ARM – stark für OEMs

- hohe Effizienz

- herausragende NPU-Leistung

- knappes, proprietäres Ökosystem

- kaum DIY-tauglich

- komplexe Emulation und Treiberfragen

ARM wird daher weiterhin den mobilen Markt dominieren. Für meinen eigenen Desktop-Rechner ist ARM dagegen ungeeignet.

x86 – flexibel für Enthusiast:innen

- freie Mainboard-Auswahl

- große Komponentenvielfalt

- Aufrüstbarkeit

- besser geeignet für PCIe-NPUs

- längere Plattformstabilität

Daher ist für mein DIY ganz klar: Der eigene Copilot+ PC basiert auf x86.

Geopolitik und Chipindustrie: Warum On-Device-AI alternativlos wird

Der aktuelle Konflikt zwischen Intel, OpenAI und der US-Regierung zeigt, dass die Cloud-KI-Branche vor erheblichen Herausforderungen steht:

- Exportkontrollen

- Fertigungsknappheit

- politische Abhängigkeiten

- Energieengpässe

- steigende Betriebskosten der Cloud

Ich habe diese Entwicklungen bereits im Beitrag Über KI, das Wachstum und warum es (wahrscheinlich) nicht ewig so weiter geht ausführlicher beleuchtet. Die Konsequenz für AI-PCs: Lokale KI wird zur logischen Weiterentwicklung – und der PC wird zu einem bevorzugten Ort für persönliche KI-Modelle.

Exkurs: Hardwarepreise im Umbruch – warum Komponenten aktuell deutlich teurer werden

Während ich die Architektur meines neuen KI-Arbeitsrechners plane, fällt ein Trend besonders auf: Die Hardwarepreise steigen deutlich, und die Verfügbarkeit einiger Komponenten wird spürbar eingeschränkt. Was sich auf den ersten Blick wie ein zyklischer Markteffekt anfühlt, ist in Wahrheit Teil einer größeren strukturellen Verschiebung. Die DRAM- und NAND-Hersteller richten sich zunehmend auf KI-Beschleuniger, High-Bandwidth-Memory und datenzentrierte Workloads aus – und ziehen sich gleichzeitig aus Bereichen zurück, die über Jahrzehnte das Rückgrat des Consumer-Marktes bildeten.

Steigende RAM-Preise: Von einem Marktproblem zu einer strukturellen Krise

Seit Mitte 2024 steigen die RAM-Preise kontinuierlich – und seit Herbst 2025 regelrecht explosionsartig. Zahlreiche Quellen bestätigen diese Entwicklung:

- zahlreiche Nutzerberichte auf Reddit (RAM prices have exploded, RAM pricing crisis)

- Analysen von Tom’s Hardware und Heise

- Preisbeobachtungen von TeamGroup, Golem und Windows Central

Die Ursachen sind vielfältig, wirken aber in dieselbe Richtung:

1. Hersteller horten DRAM und NAND für KI-Produkte

DRAM-Produzenten wie Samsung, SK Hynix, Micron und Kioxia priorisieren inzwischen:

- GDDR7 für GPUs

- HBM3/4 für AI-Acceleratoren

- LPDDR5x für ARM-SoCs

- On-Package Memory für KI-Beschleuniger

Standard-DDR5 wird dagegen systematisch knapp gehalten. Laut TeamGroup wird die Situation 2026 noch drastischer, da die Hersteller ihre Kapazitäten weiter in Richtung HBM (High Bandwidth Memory) verschieben.

2. KI-Beschleuniger verdrängen Consumer-Produkte

Die Nachfrage nach HBM und High-End-Speicher wächst exponentiell. GPU-Cluster von Nvidia, AMD und Intel verbrauchen enorme Fertigungskapazitäten.

Der zusätzliche Effekt: Consumer-RAM wird zum Nischenprodukt, obwohl es eigentlich die breite Masse bedient.

3. Speicherdiebstähle und Logistikprobleme verschärfen den Markt

Igor’sLAB berichtete sogar, dass SSDs und RAM durch ihre hohen Preise inzwischen verstärkt Ziel von Diebstählen während des Versands werden. Eine ungewöhnliche, aber symptomatische Entwicklung.

Crucial verschwindet: Ein Symbol für die Marktverschiebung

Dass Micron die traditionsreiche Marke Crucial vollständig eingestellt hat, ist ein markanter Einschnitt. Zahlreiche Medien wie PC Games Hardware, GameStar und Golem beschreiben diesen Schritt als:

- wirtschaftlich sinnvoll aus Sicht des Konzerns

- strategisch motiviert zugunsten von High-End-Speicher

- ein Verlust für den DIY- und Enthusiast:innen-Markt

Crucial stand über fast drei Jahrzehnte für:

- solide Consumer-SSDs

- verlässlichen DDR-RAM

- hohe Verfügbarkeit

- faire Preise

Mit dem Wegfall dieser Marke reduziert sich die Zahl der frei verfügbaren Speicheroptionen deutlich.

Was bedeutet das für ein DIY-KI-System?

Für mein eigenes Projekt – den Aufbau eines Copilot+-ähnlichen Desktop-Systems – hat diese Marktsituation drei wichtige Konsequenzen:

1. Komponenten müssen früher und gezielter eingeplant werden

RAM- und SSD-Preise könnten 2026 nochmals stark steigen. Für ein KI-optimiertes System bedeutet das:

- rechtzeitiger Kauf

- sorgfältige Auswahl

- Fokus auf gute Preis-Leistung

2. DDR5 und PCIe-SSDs bleiben verfügbar – aber teurer

Für ein NPU-orientiertes Build sind:

- schneller DDR5

- NVMe SSDs mit hoher IOPS-Leistung

entscheidend. Beides bleibt erhältlich, aber kostspieliger.

3. Der DIY-Markt verliert Auswahl – und gewinnt gleichzeitig an Bedeutung

So paradox es klingt:

- OEM-Geräte werden günstiger durch Skaleneffekte

- DIY-Komponenten werden teurer durch Spezialisierung

- aber der Wunsch nach Selbstbestimmung wächst

Gerade wer – wie ich – seinen PC als Arbeitswerkzeug nutzt, profitiert langfristig von:

- Aufrüstbarkeit

- modularem Aufbau

- eigener Kühlung

- Kontrolle über thermische Reserven

- flexiblem Komponentenmix

Systeme wie Surface, ThinkPad Z-Serie oder ASUS Copilot+ Modelle sind spannend (und ich nutze auch diese), aber für einen langlebigen Arbeitsrechner im Semiprofi-Umfeld eben nicht (immer) ideal.

Einordnung im Kontext der KI-Entwicklung

Im Beitrag Über KI, das Wachstum und warum es (wahrscheinlich) nicht ewig so weiter geht habe ich beschrieben, dass viele Hersteller ihre Pipeline aggressiv auf KI optimieren. Die Preisentwicklung am RAM-Markt bestätigt diesen Trend eindrucksvoll. Der Übergang zur KI-Ökonomie wirkt inzwischen so stark, dass selbst etablierte Consumer-Marken verschwinden und Standard-Hardware nur noch im Schatten des KI-Silicon-Booms existiert.

DIY: Welche Komponenten eignen sich wirklich für einen Copilot+ PC?

Der Aufbau eines eigenen Copilot+ PCs folgt anderen Prioritäten als der Kauf eines mobilen OEM-Systems. Während Hersteller wie Microsoft, Lenovo oder ASUS auf hochintegrierte SoC-Designs setzen, bietet ein selbst gebauter Desktop-Rechner deutlich mehr Flexibilität, thermische Reserven und Erweiterbarkeit. Für meinen KI-Arbeitsrechner ist genau das entscheidend. Ich möchte ein System, das auch noch 2027 oder 2028 sinnvoll erweitert werden kann, ohne dass ich mich den Limitierungen eines OEM-Geräts beuge.

In diesem Kapitel analysiere ich, welche Komponenten sich heute wirklich eignen, welche Rolle NPUs spielen, wo die Grenzen von ARM liegen und wie sich der Markt in Richtung PCIe-basierten KI-Beschleunigern entwickelt.

Prozessorwahl: CPU-, GPU- und NPU-Optionen im Überblick

Die wichtigste Entscheidung beim DIY-Copilot+-PC betrifft die Wahl des Prozessors beziehungsweise des Gesamtsystems aus CPU, GPU und NPU. Denn während OEM-Systeme zunehmend auf integrierte ARM-SoCs setzen, bleibt im DIY-Segment weiterhin die x86-Plattform der realistische und verfügbare Unterbau.

Dabei ist entscheidend, zwischen bereits verfügbaren Plattformen und angekündigten, aber noch nicht breit einsetzbaren Architekturen zu unterscheiden.

Intel: Core Ultra heute – Lunar Lake und Panther Lake als Ausblick

Intel hat bei der KI-Beschleunigung in den vergangenen zwei Jahren deutlich aufgeholt. Mit den aktuellen Core-Ultra-Prozessoren stehen bereits x86-CPUs zur Verfügung, die neben klassischen CPU-Kernen auch integrierte GPUs und dedizierte NPUs für lokale KI-Workloads bieten. Diese Plattformen sind heute verfügbar, werden aktiv von Windows 11 adressiert und bilden eine belastbare Basis für KI-PC-Szenarien im Desktop-Umfeld.

Darüber hinaus hat Intel mit Lunar Lake und Panther Lake weitere Architektur-Generationen angekündigt, die die Integration von KI-Beschleunigern weiter vertiefen sollen. Diese Plattformen versprechen:

- leistungsfähigere NPUs mit höherer TOPS-Leistung

- optimierte GPU-Blöcke

- effizientere CPU-Kerne

- eine noch engere Verzahnung mit dem Windows-AI-Stack

Zum aktuellen Zeitpunkt sind Lunar Lake und Panther Lake jedoch primär im mobilen OEM-Segment positioniert beziehungsweise noch nicht als frei verfügbare Desktop-CPUs etabliert. Für klassische DIY-Systeme sind daher aktuell die bestehenden Core-Ultra-Plattformen die realistische Wahl.

Die enge Partnerschaft zwischen Intel und Microsoft, die ich bereits im Beitrag Windows 11 26H1 – Architekturwandel für die KI-PC-Hardware aufgegriffen habe, macht Intel dennoch zu einer sehr robusten Option für selbst gebaute KI-Arbeitsrechner.

AMD: Ryzen AI und Strix Point als vielseitige x86-Alternative

Auch AMD hat mit seinen Ryzen-AI-Plattformen frühzeitig auf dedizierte KI-Beschleunigung gesetzt. Prozessoren auf Basis von Strix Point integrieren eigene AI-Engines und kombinieren diese mit leistungsfähigen CPU-Kernen sowie einer starken integrierten GPU auf RDNA-Basis.

AMD punktet insbesondere bei:

- energieeffizienten NPUs

- hoher Multi-Core-Performance

- sehr leistungsfähiger integrierter Grafik

- breiter Verfügbarkeit im DIY- und OEM-Umfeld

Viele dieser Prozessoren erfüllen bereits heute wesentliche Copilot+-Anforderungen und werden aktiv in entsprechenden OEM-Systemen eingesetzt. Für Bastler:innen und Selbstbauer:innen stellt AMD damit eine sehr flexible x86-Plattform dar, die sowohl im mobilen als auch im klassischen PC-Segment eine echte Alternative zu Intel ist.

Qualcomm Snapdragon X: Hohe Effizienz – aber keine DIY-Option

ARM-basierte Plattformen wie die Snapdragon-X-Familie liefern aktuell beeindruckende NPU-Leistung und zeigen, welches Effizienzpotenzial in stark integrierten SoCs steckt. Für den DIY-Desktop-Bereich sind sie jedoch weiterhin keine praktikable Option.

Die Gründe dafür sind struktureller Natur:

- ausschließliche Verfügbarkeit in OEM-Laptops

- proprietäre Mainboards und verlötete SoCs

- keine Integration in klassische Desktop-Plattformen

- eingeschränkte Aufrüstbarkeit

- anderes Treiber- und Emulationsmodell

Für meinen eigenen Copilot+-PC ist ARM daher nicht aus Leistungsgründen ausgeschlossen, sondern schlicht aufgrund der fehlenden DIY-Tauglichkeit.

Zwischenfazit: Die DIY-Plattform bleibt x86

Für selbst gebaute Systeme ist x86 aktuell die einzige realistische Basis. Die Entscheidung fällt daher nicht zwischen ARM und x86, sondern zwischen Intel und AMD – beide mit unterschiedlichen Stärken, beide mit integrierten KI-Beschleunigern und beide grundsätzlich Copilot+-fähig.

Welche Plattform letztlich die bessere Wahl ist, hängt weniger von Marketingbegriffen als vielmehr von konkreten Anforderungen, Verfügbarkeit und persönlicher Erfahrung ab – Aspekte, die ich im weiteren Verlauf dieses Beitrags anhand meiner eigenen Build konkret einordne.

Speicherarchitektur und Mainboard: Die unterschätzte Grundlage

Die RAM- und Storage-Anforderungen eines KI-PCs sind höher, als viele annehmen. Das liegt nicht nur an On-Device-Modellen, sondern auch an der Art und Weise, wie Windows 11 den KI-Kontext verwaltet.

RAM: Geschwindigkeit und Kapazität sind entscheidend

Für ein KI-optimiertes System empfehle ich:

- 32 GB DDR5 als Minimum

- 64 GB DDR5 als zukunftssichere Option

- RAM mit hoher Taktung und guter Latenz

- eine Mainboard-Architektur, die hohe RAM-Stabilität bietet

In meinem Exkurs zu den steigenden Hardwarepreisen wird deutlich, dass DRAM zunehmend teurer wird. Daher ist eine strategische Planung der RAM-Konfiguration sinnvoll.

NVMe-SSDs: Hohe IOPS statt nur großer Kapazität

Windows 11 benötigt für On-Device-KI schnelle SSDs. Wichtig sind:

- PCIe 4.0 oder PCIe 5.0

- hohe Random Read IOPS

- gute thermische Stabilität

- mindestens 1 TB Kapazität

Die Beschleunigerpipelines in Windows Studio Effects und Recall profitieren massiv von niedrigen Latenzen. Die Erkenntnisse aus meinem Beitrag Tiny AI im Unternehmensalltag zeigen, wie wichtig schnelle Speicherwege für kompakte Modelle sind.

Mainboards: PCIe-Lanes, Stromversorgung und BIOS

Für KI-PCs empfehle ich Boards, die folgende Merkmale bieten:

- stabile VRMs für Dauerlast

- ausreichend PCIe-Lanes für zukünftige NPU-Karten

- moderne BIOS-Versionen mit KI-Optimierungen

- DDR5-Overclocking-Kompatibilität (selbst bei moderaten Profilen)

Hier entscheidet sich, wie zukunftssicher das System wirklich wird.

Thermisches Design: Dauerlastfähigkeit für lokale KI

Wer mit KI-Modellen arbeitet – sei es für Development, Testing oder Inferenz – weiß, dass viele Workloads dauerhafte, gleichmäßige Rechenlast erzeugen. Genau hier geraten OEM-Systeme schnell an ihre Grenzen.

Ein DIY-System bietet dagegen:

- große Luftkühler

- leistungsstarke AiO-Wasserkühlungen

- definierte Luftwege im Gehäuse

- Staubfilter und modulare Lüfter

- Netzteile mit hoher Effizienz (80+ Gold oder höher)

Thermik ist kein Detail – sie ist die Voraussetzung für Leistung

Vor allem beim Inferenzieren über längere Zeiträume zeigt sich:

- konstante Temperaturen = konstante NPU-Performance

- besseres Scheduling auf CPU / GPU

- längere Lebensdauer der Komponenten

Das gilt insbesondere für Szenarien, die in Beiträgen wie Copilot in Microsoft 365 – Von intelligenten Assistenten zu autonomen Agenten beschrieben sind: KI-gestützte Prozesse, laufende Hintergrundmodelle und mehrschichtige Pipelines.

Warum der DIY-PC bei der Architektur eine klare Richtung vorgibt

ARM hat OEMs geholfen, die Effizienzgrenze zu verschieben. Dennoch:

- Die ARM-Plattform ist für Desktop-Builds nicht verfügbar

- erfordert proprietäre Treiber

- basiert auf SoCs ohne modulare Komponenten

- ist thermisch stark auf Mobilgeräte ausgelegt

- bietet keine PCIe-Erweiterbarkeit für NPUs

x86 bleibt daher:

- flexibler

- erweiterbar

- besser dokumentiert

- ideal für PCIe-basierte Zukunftstechnologien

Für meinen eigenen Rechner war die Entscheidung daher eindeutig: x86 bildet die Grundlage eines nachhaltigen KI-Arbeitsrechners.

Die Zukunft: PCIe-basierte KI-Beschleuniger

Die spannendste Entwicklung für DIY-Systeme kommt erst noch: dedizierte KI-Beschleunigerkarten, die ähnlich wie GPUs skalieren können.

Schon jetzt finden sich erste Hinweise:

- Intel AI Boost über PCIe

- AMD experimentiert mit dedizierten NPU-Einheiten

- Start-ups arbeiten an PCIe-Karten für small und mid-size Modelle

- Microsoft und Intel planen langfristig modulare AI-Silicon-Designs

Was heute noch experimentell wirkt, wird in zwei bis drei Jahren zum Standard eines KI-PCs. Diese Entwicklung greift den Trend auf, den ich in KI im Gigawatt-Zeitalter und Über KI, das Wachstum – und warum es (wahrscheinlich) nicht ewig so weitergeht analysiert habe: Lokale KI wird skaliert – und der PC wird der natürliche Ort für modulare Beschleuniger.

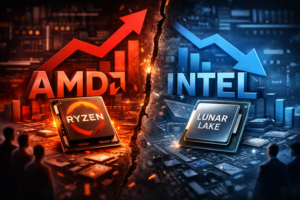

Exkurs: AMD auf dem Vormarsch – ein leiser Paradigmenwechsel im x86-Markt

Ein Blick auf aktuelle Marktdaten zeigt, dass sich das Kräfteverhältnis zwischen Intel und AMD in den vergangenen Jahren spürbar verschoben hat. Besonders deutlich wird dies in der regelmäßig veröffentlichten Hardware-Umfrage der Spieleplattform Steam, die aufgrund ihrer großen Nutzerbasis als valider Stimmungsindikator für den PC-Markt gilt.

Laut aktuellen Auswertungen wächst der Anteil von AMD-Prozessoren kontinuierlich, während Intel Marktanteile verliert. Dieser Trend ist kein kurzfristiger Ausreißer, sondern das Ergebnis mehrerer struktureller Faktoren, die über reine Gaming-Leistung hinausgehen.

Warum immer mehr Nutzer:innen zu AMD wechseln

Der wachsende Zuspruch für AMD lässt sich vor allem durch drei Aspekte erklären:

- Attraktives Preis-Leistungs-Verhältnis: AMD bietet seit mehreren Generationen sehr konkurrenzfähige CPUs, die insbesondere im Multi-Core-Bereich überzeugen und oft günstiger positioniert sind als vergleichbare Intel-Modelle.

- Technologische Kontinuität: Längere Sockel-Lebenszyklen und bessere Aufrüstbarkeit haben AMD im DIY-Umfeld viele Sympathien eingebracht – ein Aspekt, der für Selbstbauer:innen eine große Rolle spielt.

- Starke Plattformen jenseits des Gaming-Marktes: Spätestens mit den Ryzen-AI-Generationen hat AMD gezeigt, dass KI-Beschleunigung, integrierte GPUs und energieeffiziente Designs nicht nur Intel vorbehalten sind.

Die Steam-Zahlen spiegeln damit weniger eine kurzfristige Mode wider, sondern eine langfristige Vertrauensverschiebung im x86-Segment.

Warum dieser Trend meine Entscheidung nicht automatisch umkehrt

Trotz dieses klar erkennbaren Markttrends habe ich mich bei meinem eigenen KI-Arbeitsrechner bewusst für eine Intel-Plattform entschieden. Das steht nicht im Widerspruch zu den Zahlen, sondern unterstreicht einen wichtigen Punkt:

Plattformentscheidungen sind kontextabhängig. Persönliche Erfahrung, bestehende Infrastruktur, Treiberverhalten, Virtualisierungsszenarien und konkrete Workloads spielen im professionellen Umfeld eine mindestens ebenso große Rolle wie Marktanteile oder Benchmark-Diagramme.

Gerade im Copilot+-Kontext bleibt Intel durch die enge Verzahnung mit Windows 11, die frühe Integration von NPUs und die stabile Desktop-Plattform weiterhin eine sehr robuste Option – auch wenn AMD in vielen Bereichen technisch gleichgezogen oder vorbeigezogen ist.

Einordnung im Kontext dieses Beitrags

Der zunehmende Erfolg von AMD zeigt vor allem eines: Der DIY-Markt ist heute so offen und vielfältig wie lange nicht mehr. Wer einen Copilot+-ähnlichen PC plant, kann sowohl mit Intel als auch mit AMD eine leistungsfähige, zukunftssichere Plattform aufbauen.

Dieser Exkurs soll daher keine Empfehlung umkehren, sondern verdeutlichen, dass die Wahl zwischen Intel und AMD heute weniger eine Frage von richtig oder falsch ist – sondern eine bewusste Entscheidung entlang eigener Anforderungen, Erfahrungen und Prioritäten.

Die Komponenten meines KI-PCs im Detail

Nachdem klar ist, welche Hardwareklassen sich grundsätzlich für einen Copilot+-fähigen DIY-PC eignen, wird es nun konkret. In diesem Kapitel gehe ich die einzelnen Komponenten meines eigenen Systems systematisch durch und erläutere, warum ich mich jeweils genau für diese Auswahl entschieden habe.

Dabei geht es ausdrücklich nicht um maximale Benchmark-Werte oder Gaming-Superlative. Maßgeblich sind für mich andere Kriterien: Stabilität unter Dauerlast, leiser Betrieb, gute Integration in Windows 11 sowie eine Architektur, die lokale KI-Workloads sinnvoll unterstützt. Jede Komponente ist Teil eines Gesamtkonzepts und muss sich in dieses einfügen – funktional, thermisch und perspektivisch.

Zentrale Rechenplattform: CPU und NPU

Die wichtigste Entscheidung bei einem KI-Arbeitsrechner betrifft die zentrale Rechenplattform. Sie definiert nicht nur die klassische CPU-Leistung, sondern auch, wie gut Windows 11 moderne KI-Funktionen lokal ausführen kann. Entsprechend intensiv habe ich mich mit möglichen Alternativen auseinandergesetzt, bevor die finale Entscheidung gefallen ist.

Warum keine AMD-CPU? Eine bewusste, nicht dogmatische Entscheidung

Grundsätzlich wären auch aktuelle AMD-Plattformen eine valide Option gewesen. Gerade im klassischen Multi-Core-Bereich und bei reiner Rechenleistung sind sie technisch konkurrenzfähig oder überlegen. Dennoch habe ich mich bewusst dagegen entschieden.

Ein nicht zu unterschätzender Faktor ist dabei persönliche Erfahrung. In meiner bestehenden Infrastruktur – stationär wie mobil – setze ich seit vielen Jahren ausschließlich auf Intel-Plattformen. Treiberverhalten, Firmware-Reife, Windows-Kompatibilität und das Zusammenspiel mit Virtualisierungslösungen sind mir vertraut und im Alltag bewährt. Insofern bin ich, ganz selbstironisch betrachtet, vermutlich tatsächlich ein typisches Intel-Werbeopfer.

Für einen produktiven Arbeitsrechner ist diese Verlässlichkeit jedoch ein valides Argument. Ich optimiere hier kein Labor-Setup, sondern ein System, das täglich funktionieren muss.

Abwägung innerhalb der Plattform: Core Ultra 7 265K vs. Core Ultra 9 285K

Innerhalb der Intel-Core-Ultra-Familie habe ich konkret zwischen dem Core Ultra 7 265K und dem Core Ultra 9 285K abgewogen. Beide CPUs basieren auf derselben Plattformgeneration und bieten integrierte Grafik sowie eine dedizierte NPU. Auf den ersten Blick wirkt der Ultra 7 daher wie die wirtschaftlichere Wahl.

Die Leistungsdaten zeigen jedoch deutliche Unterschiede zu Gunsten der Ultra 9 Variante:

- höhere Kern- und Thread-Anzahl

- mehr Reserven bei parallelen Workloads

- stabilere Performance unter Dauerlast

- bessere Skalierung bei gleichzeitiger Nutzung von CPU, GPU und NPU

Gerade letzter Punkt war für mich ausschlaggebend. Lokale KI-Workloads, virtuelle Maschinen, Entwicklungsumgebungen und produktive Anwendungen laufen in meinem Alltag nicht nacheinander, sondern parallel. Der Ultra 9 bietet hier mehr Luft nach oben, ohne in eine thermisch problematische Klasse vorzustoßen.

NPU als strategisches Entscheidungskriterium

Im Kontext von Copilot+ ist die NPU kein optionales Extra, sondern ein strategisches Element. Windows 11 verschiebt zunehmend Funktionen in Richtung On-Device-AI, etwa bei Sprachverarbeitung, Bildanalyse oder Studio-Effekten. Diese Aufgaben effizient und dauerhaft auszulagern, ohne CPU oder GPU zu blockieren, ist ein klarer Vorteil.

Beide CPUs verfügen über eine NPU, doch mit dem Ultra 9 ist sichergestellt, dass diese auch bei hoher Gesamtlast nicht zum Flaschenhals wird. Für mich ist das weniger eine Momentaufnahme als vielmehr eine Investition in kommende Windows-Versionen und weiterentwickelte KI-Frameworks.

Fazit zur CPU-Entscheidung

Der Intel Core Ultra 9 285K ist für mich keine Entscheidung für maximale Zahlen auf dem Papier, sondern für Planbarkeit, Stabilität und Zukunftssicherheit. Gegenüber dem Ultra 7 bietet er genau die zusätzlichen Leistungsreserven, die ich in einem langfristig genutzten KI-Arbeitsrechner schätze.

In Kombination mit Windows 11, der integrierten NPU und einer auf Dauerlast ausgelegten Kühlung bildet er das Fundament für ein System, das nicht nur heute funktioniert, sondern auch die nächsten Entwicklungsstufen von Copilot+ sinnvoll mitgehen kann.

Das Mainboard als Fundament der Plattform

Nach der Entscheidung für die zentrale Rechenplattform stellt das Mainboard die nächste zentrale Weichenstellung dar. Es verbindet alle Komponenten miteinander und entscheidet darüber, wie stabil, erweiterbar und langfristig nutzbar ein System tatsächlich ist. Da ich seit vielen Jahren überwiegend auf ASUS setze, habe ich den Markt hier nicht breit sondiert, sondern mich bewusst innerhalb des Portfolios eines Herstellers bewegt. Die eigentliche Aufgabe bestand daher weniger im Ob, sondern im Welches.

Die engere Auswahl: Drei Boards, drei Zielgruppen

Konkret standen für mich drei Modelle zur Auswahl:

- ASUS TUF Gaming Z890-PLUS WiFi

- ASUS TUF Gaming Z890-PRO WiFi

- ASUS ProArt Z890-CREATOR WIFI

Alle drei Boards basieren auf dem Z890-Chipsatz und erfüllen grundsätzlich die technischen Anforderungen für einen leistungsfähigen KI-Arbeitsrechner. Unterschiede ergeben sich vor allem bei Ausstattungstiefe, Zielgruppe und Preispositionierung.

Warum nicht das ProArt Z890-CREATOR WIFI?

Das ProArt-Board ist ohne Zweifel technisch attraktiv. Es richtet sich klar an Content-Creator und professionelle Workstations und bietet zusätzliche Features wie erweiterte Thunderbolt-Anbindung, besonders umfangreiche I/O-Optionen und eine sehr hochwertige Layout-Auslegung.

Für mein konkretes System hätte ich diesen Mehrwert jedoch nicht ausgeschöpft. Weder Thunderbolt-Workflows noch externe Hochgeschwindigkeits-Speicherlösungen stehen aktuell im Fokus meines Setups. Vor diesem Hintergrund ließ sich der deutliche Preisaufschlag sachlich nicht rechtfertigen. Das ProArt-Board wäre in meiner geplanten Ausbaustufe eher Überdimensionierung als gezielte Investition gewesen.

TUF Gaming Z890-PRO vs. Z890-PLUS: Eine Frage der Nuancen

Deutlich spannender war die Entscheidung zwischen den beiden TUF-Varianten. Sowohl das Z890-PLUS als auch das Z890-PRO bieten eine solide Spannungsversorgung, moderne I/O-Ausstattung und eine auf Dauerbetrieb ausgelegte Konstruktion. Für einen leisen, stabilen KI-Arbeitsrechner sind beide grundsätzlich geeignet.

Die PRO-Variante bietet jedoch in einigen Details etwas mehr Reserve: zusätzliche Anschlussoptionen, eine minimal erweiterte Ausstattung und eine insgesamt etwas robustere Auslegung. Da der Preisunterschied zwischen beiden Modellen vergleichsweise gering ausfiel, wurde die Entscheidung am Ende weniger technisch als pragmatisch.

Verfügbarkeit als realer Entscheidungsfaktor

In der Praxis spielte schließlich die kurzfristige Verfügbarkeit eine entscheidende Rolle. Da sich mein Build zeitlich rund um den Jahreswechsel realisieren sollte und keine funktionalen Kompromisse zu erwarten waren, habe ich mich für das ASUS TUF Gaming Z890-PRO WiFi entschieden, das zum gewünschten Zeitpunkt verfügbar war.

Diese Entscheidung passt gut zu meinem Gesamtkonzept: kein extremes Overengineering, aber ausreichend Reserven für kommende Erweiterungen. Das Board bietet eine stabile Basis für CPU, GPU, NPU und schnellen Storage, ohne preislich in Regionen vorzustoßen, die für meinen Anwendungsfall keinen echten Mehrwert liefern.

Fazit zur Mainboard-Wahl

Mit dem ASUS TUF Gaming Z890-PRO WiFi habe ich ein Mainboard gewählt, das funktional, robust und zukunftssicher ist. Es fügt sich nahtlos in das Gesamtkonzept meines KI-PCs ein und lässt genügend Spielraum für spätere Erweiterungen, ohne unnötige Kosten zu verursachen. Für einen langfristig genutzten Arbeitsrechner ist genau diese Balance entscheidend.

Arbeitsspeicher: Kapazität vor Takt

Beim Arbeitsspeicher war die ursprüngliche Planung deutlich ambitionierter. Ein Ausbau auf 128 GB RAM lag zunächst nahe, insbesondere mit Blick auf virtuelle Maschinen, lokale KI-Modelle und parallele Entwicklungsumgebungen. Die aktuelle Marktlage hat diese Überlegung jedoch sehr schnell relativiert. Die Preisentwicklung bei RAM erinnert aktuell stark an die frühen 1990er-Jahre, als Speicher und Festplatten im Verhältnis zur gebotenen Kapazität zu geradezu absurden Preisen angeboten wurden.

Vor diesem Hintergrund habe ich mich – wie bereits bei meinem aktuell eingesetzten System – bewusst auf 64 GB Arbeitsspeicher beschränkt. Auch diese Kapazität bietet für meinen Alltag ausreichend Reserven, ohne den Kostenrahmen unverhältnismäßig zu sprengen.

Die engere Auswahl: Zwei 64-GB-Kits im Vergleich

Konkret standen zwei Kits in der näheren Auswahl:

- Crucial Pro DDR5-5600, 64 GB (CL46)

- Kingston FURY Beast DDR5-6000, 64 GB (CL36)

Auf dem Papier bietet das Kingston-Kit die besseren Latenz- und Taktwerte. In der Praxis hätte dieser Vorteil jedoch vor allem bei Übertaktung und sehr spezifischen Speicherbenchmarks eine Rolle gespielt. Für einen produktiven KI-Arbeitsrechner war das für mich kein ausschlaggebendes Kriterium.

EXPO, Overclocking und Plattformfokus

Ein wesentlicher Punkt in der Entscheidungsfindung war die Plattformausrichtung. Die Kingston-Module sind als EXPO-Speicher primär auf AMD-Setups zugeschnitten. Zwar lassen sich solche Kits auch in Intel-Systemen betreiben, der eigentliche Mehrwert entfaltet sich dort jedoch nicht. Hinzu kommt, dass der Preis der Kingston-Module spürbar über dem der Crucial-Kits lag.

Da ich weder ein extremes Tuning noch manuelles Overclocking plane, war für mich die Stabilität im JEDEC-nahen Betrieb wichtiger als maximale Taktfrequenzen. Gerade bei Dauerlast und produktiven Workflows zahlt sich ein konservativer Ansatz häufig mehr aus als aggressive Speicherprofile.

Warum Crucial Pro DDR5-5600 die bessere Wahl war

Die Entscheidung für das Crucial Pro DDR5-5600 64-GB-Kit ist daher konsequent. Die Module bieten ausreichend Bandbreite für Windows 11, lokale KI-Workloads und virtuelle Maschinen, ohne zusätzliche Komplexität in die Konfiguration zu bringen. Gleichzeitig ist Crucial als Hersteller für stabile Speicherlösungen bekannt – ein nicht zu unterschätzender Faktor, gerade in Zeiten, in denen sich der Consumer-Markt sichtbar ausdünnt.

Fazit zur RAM-Entscheidung

Mit 64 GB DDR5-5600 setze ich bewusst auf einen pragmatischen Mittelweg. Die Kapazität ist für meine aktuellen und mittelfristigen Anforderungen mehr als ausreichend, die Performance stabil und die Kosten noch vertretbar. Sollte sich der Markt entspannen, bleibt ein späteres Upgrade denkbar – aktuell ist diese Konfiguration jedoch die sinnvollste Balance aus Leistungsfähigkeit, Stabilität und Wirtschaftlichkeit.

Die Grafikkarte: Leistungsreserve statt Extremklasse

Bei der Auswahl der Grafikkarte war der grundsätzliche Rahmen für mich schnell gesetzt. Ähnlich wie bei CPUs setze ich auch bei GPUs seit vielen Jahren konsequent auf NVIDIA. Entsprechend habe ich AMD-Grafikkarten in diesem Build nicht aktiv in Betracht gezogen. Ausschlaggebend sind dabei weniger ideologische Gründe als vielmehr praktische Erfahrung: Treiberstabilität, breite Softwareunterstützung und die enge Verzahnung mit KI-Frameworks spielen in meinem Arbeitsalltag eine zentrale Rolle.

Gerade im KI-Umfeld sind Technologien wie CUDA, cuDNN und die breite Unterstützung in DirectML- und ONNX-basierten Workflows nach wie vor ein starkes Argument. Für einen produktiven KI-Arbeitsrechner, der nicht experimentell, sondern verlässlich funktionieren soll, war NVIDIA damit die naheliegende Wahl.

Auch wenn Copilot+ und Windows 11 zunehmend auf NPUs setzen, bleibt die Grafikkarte ein zentraler Bestandteil eines leistungsfähigen KI-Arbeitsrechners. Sie übernimmt heute bereits viele GPU-beschleunigte KI-Workloads, Visualisierungen, parallele Inferenzprozesse und klassische Compute-Aufgaben. Entsprechend sorgfältig habe ich auch hier abgewogen.

Die erste Überlegung: RTX 5070 als Einstieg

Zu Beginn habe ich mir die ASUS Dual GeForce RTX 5070 12 GB GDDR7 OC Edition näher angesehen. Diese Karte ist kompakt, effizient und preislich noch im moderaten Bereich angesiedelt. Für viele Anwender:innen wäre sie eine absolut solide Wahl, insbesondere für klassische Desktop- und leichtere KI-Szenarien.

Für meinen Anwendungsfall zeigte sich jedoch schnell, dass diese Variante eher die untere Grenze dessen markiert, was ich mir für einen langfristig genutzten KI-PC vorstelle. Gerade bei parallelen Workloads und zunehmender Modellgröße sind zusätzliche Leistungsreserven hilfreich.

Der Blick nach oben: RTX 5090 als theoretische Option

In einem zweiten Schritt habe ich auch deutlich leistungsstärkere Modelle in Betracht gezogen:

- ASUS GeForce RTX 5090 ROG Astral OC

- ASUS GeForce RTX 5090 ROG Astral Gaming OC BTF

- ASUS ROG Astral GeForce RTX 5090 OC Edition

Diese Karten spielen technisch und qualitativ ohne Zweifel in einer eigenen Liga. Sie bieten maximale Rechenleistung, enorme Speicherbandbreite und sind für extrem anspruchsvolle Workloads konzipiert. Gleichzeitig bewegen sie sich jedoch in einem Preisbereich zwischen 3.000 und 4.500 Euro – eine Größenordnung, die für meinen geplanten Ausbau schlicht nicht mehr sinnvoll darstellbar ist.

Für einen produktiven KI-Arbeitsrechner ist maximale Leistung nicht automatisch die beste Entscheidung. Effizienz, Lautstärke, thermisches Verhalten und ein ausgewogenes Kosten-Nutzen-Verhältnis sind mindestens ebenso wichtig.

Die finale Entscheidung: ASUS Prime RTX 5070 Ti

Am Ende habe ich mich bewusst für die ASUS Prime RTX5070Ti-O16G entschieden. Diese Karte positioniert sich genau zwischen den beiden Extremen. Sie bietet spürbar mehr Leistung als die non-Ti-Varianten, bleibt aber deutlich unterhalb der Preisregionen einer RTX 5090.

Der Zusatz Ti ist dabei kein Marketingdetail, sondern ein entscheidender Leistungsfaktor. Die Ti-Varianten verfügen in der Regel über mehr Recheneinheiten, höhere Speicherbandbreite und bessere Skalierung bei parallelen Workloads. Die günstigeren Modelle ohne Ti sind zwar attraktiver im Preis, würden jedoch schneller an ihre Grenzen stoßen – insbesondere bei GPU-beschleunigter KI-Inferenz oder Visualisierung.

Einordnung im Gesamtkonzept

Die Prime-Serie passt zudem gut zu meinem Gesamtkonzept. Sie verzichtet auf übertriebenes Show-Design, setzt auf solide Kühlung und ist auf einen stabilen Dauerbetrieb ausgelegt. In Kombination mit der NPU der CPU ergibt sich eine klare Arbeitsteilung: Die NPU übernimmt effiziente On-Device-KI-Funktionen, während die GPU für leistungsintensivere Aufgaben bereitsteht.

Fazit zur GPU-Wahl

Mit der ASUS Prime RTX 5070 Ti habe ich eine Grafikkarte gewählt, die ausreichend Leistungsreserven für kommende Anforderungen bietet, ohne das Budget zu sprengen oder das System thermisch unnötig zu belasten. Sie ergänzt die CPU- und NPU-Plattform sinnvoll und fügt sich stimmig in das Gesamtkonzept eines leisen, leistungsfähigen und langfristig nutzbaren KI-Arbeitsrechners ein.

Exkurs: GPU-Markt unter Druck – Preise, Verfügbarkeit und strategische Verknappung

Kurz nach Abschluss der Hardware-Planung zeigte sich, wie fragil der aktuelle Grafikkartenmarkt erneut geworden ist. Mitte Januar 2026 häuften sich Berichte, dass insbesondere die GeForce RTX 5070 Ti im Handel kaum noch verfügbar ist und die Preise deutlich anziehen. Parallel dazu verdichten sich Hinweise, dass bestimmte Modelle mit 16 GB Grafikspeicher perspektivisch aus dem Portfolio fallen oder nur noch eingeschränkt produziert werden.

Diese Entwicklung erinnert unangenehm an frühere Marktphasen, in denen Verfügbarkeit, nicht technische Eignung, zur entscheidenden Kaufvariable wurde. Ursachen sind weniger klassische Lieferkettenprobleme, sondern vielmehr strategische Prioritätenverschiebungen: Hochpreisige KI-Beschleuniger für Rechenzentren, professionelle Workstation-GPUs und OEM-Großaufträge binden zunehmend Kapazitäten, während der Consumer-Markt an Bedeutung verliert.

Einordnung im Kontext dieser Build

Rückblickend unterstreicht diese Marktentwicklung meine Entscheidung, nicht auf extreme High-End-Modelle zu setzen, sondern eine leistungsstarke, aber noch erreichbare GPU-Klasse zu wählen. Die RTX-5070-Ti-Kategorie bot zum Planungszeitpunkt ein ausgewogenes Verhältnis aus:

- ausreichender VRAM-Ausstattung

- solider KI- und CUDA-Leistung

- vertretbarem Energiebedarf

- realistischer Verfügbarkeit

Dass selbst dieses Segment inzwischen von Preissteigerungen und Verknappung betroffen ist, zeigt, wie schnell sich Rahmenbedingungen ändern können. Für DIY-Projekte bedeutet das: Hardware-Planung wird zunehmend zu einer Momentaufnahme, bei der Timing und Marktbeobachtung fast ebenso wichtig sind wie technische Datenblätter.

Ausblick: Konsumentenmarkt unter KI-Vorbehalt

Die aktuellen Entwicklungen deuten darauf hin, dass sich der klassische Consumer-GPU-Markt weiter unter Druck setzen lässt. Wer heute einen KI-fähigen Arbeitsrechner plant, sollte daher nicht nur Leistung und Architektur bewerten, sondern auch Verfügbarkeit, Lieferfenster und Produktlebenszyklen im Blick behalten.

Dieser Exkurs soll weniger alarmieren als sensibilisieren: Die Wahl einer Grafikkarte ist längst nicht mehr nur eine technische Entscheidung, sondern zunehmend auch eine strategische.

Storage-Architektur: Trennung nach Funktion statt Einheitslösung

Beim Storage habe ich mich bewusst gegen eine einfache eine große SSD-Lösung entschieden. Gerade bei einem KI-Arbeitsrechner mit lokalen Modellen, virtuellen Maschinen und parallelen Workloads ist eine funktionale Trennung der Datenträger nicht nur sauberer, sondern auch performanter.

Seit vielen Jahren setze ich in meinen Systemen konsequent auf Samsung-SSDs. Entsprechend war die Herstellerfrage für mich schnell geklärt. Zuverlässigkeit, konstante Performance und eine über Jahre hinweg stabile Firmware-Strategie haben sich in meinem Alltag bewährt. Lange Vergleichstests waren daher nicht notwendig.

System, Programme und virtuelle Maschinen: Samsung 9100 PRO

Für Betriebssystem, Anwendungen und virtuelle Maschinen kommen in meinem Build die Samsung 9100 PRO Modelle zum Einsatz. Diese SSDs bilden das Rückgrat des Systems. Windows 11, Entwicklungsumgebungen, Hyper-V-Maschinen und lokale KI-Frameworks profitieren hier besonders von hoher I/O-Leistung und geringer Latenz.

Gerade bei KI-Workloads zeigt sich, dass nicht allein sequenzielle Spitzenwerte entscheidend sind. Viel wichtiger sind stabile Random-I/O-Leistung und konsistente Zugriffszeiten – insbesondere dann, wenn mehrere VMs oder Prozesse parallel arbeiten. Die 9100er-Serie ist genau für diesen Einsatzbereich ausgelegt und passt damit sehr gut zum Anspruch eines produktiven Arbeitsrechners.

Dass diese Laufwerke auf PCIe-Gen5-Basis arbeiten, ist dabei weniger ein Prestige-Argument als vielmehr eine Investition in Zukunftssicherheit. Die aktuellen Workloads profitieren bereits spürbar, kommende Windows- und KI-Features werden diese Bandbreite voraussichtlich noch stärker nutzen.

Datenablage: Samsung 990 PRO

Für klassische Daten – also Projektdateien, Medien, Dokumente und sonstige persistente Inhalte – setze ich auf die Samsung 990 PRO. Diese SSDs sind technisch ausgereift, sehr effizient und preislich mittlerweile deutlich attraktiver als aktuelle Gen5-Modelle.

Für diesen Zweck ist PCIe Gen4 vollkommen ausreichend. Die Datenablage erzeugt deutlich weniger zufällige Schreib- und Lesezugriffe als Betriebssysteme oder virtuelle Maschinen. Gleichzeitig bleibt das System klar strukturiert: OS und Workloads auf den 9100ern, Daten auf der 990.

Vorteile dieser Aufteilung im Alltag

Diese Storage-Architektur bringt mehrere praktische Vorteile:

- geringere gegenseitige Beeinflussung von System und Daten

- stabilere Performance bei parallelen Workloads

- einfachere Backup- und Restore-Strategien

- bessere Skalierbarkeit bei späteren Erweiterungen

Gerade im KI-Kontext, in dem Daten, Modelle und Laufzeitumgebungen unterschiedlich genutzt werden, zahlt sich diese Trennung schnell aus.

Fazit zur Storage-Entscheidung

Mit der Kombination aus Samsung 9100 PRO für Betriebssystem, Programme und VMs sowie Samsung 990 PRO für die Datenablage setze ich auf eine bewährte, klar strukturierte und leistungsfähige Speicherarchitektur. Sie passt hervorragend zum Anspruch eines langfristig genutzten KI-Arbeitsrechners und bietet ausreichend Reserven für kommende Anforderungen – ohne unnötige Komplexität.

Kühlung: Dauerlast, Lautstärke und Alltagstauglichkeit

Die Kühlung ist für mich kein nachgelagerter Aspekt, sondern ein zentrales Designkriterium. Ein KI-Arbeitsrechner arbeitet nicht in kurzen Lastspitzen, sondern häufig über viele Stunden hinweg unter gleichmäßiger Belastung. Genau hier entscheidet sich, ob ein System im Alltag angenehm nutzbar bleibt oder langfristig stört.

CPU-Kühlung: Flüssigkeitskühlung aus Überzeugung

Für die Kühlung der CPU setze ich erneut auf eine be quiet! Silent Loop 3 mit 420-mm-Radiator. Dieses Modell ist bereits in meiner aktuellen Build im Einsatz, und genau diese Praxiserfahrung war ausschlaggebend für die aktuelle Entscheidung. Die Kombination aus sehr niedriger Geräuschentwicklung und stabiler Kühlleistung hat sich im täglichen Betrieb nachhaltig bewährt.

Gerade bei Online-Seminaren arbeitet der Rechner oft über viele Stunden hinweg direkt unter meinem Schreibtisch. In dieser Situation ist nicht die maximale Kühlleistung entscheidend, sondern ein ruhiger, gleichmäßiger Betrieb ohne hochfrequente Lüftergeräusche. Der große Radiator der Silent Loop 3 erlaubt niedrige Drehzahlen bei gleichzeitig hoher thermischer Reserve – ein klarer Vorteil gegenüber kleineren AiO-Lösungen.

Auch unter längerer CPU-Last bleiben die Temperaturen stabil, ohne dass Lüfter aggressiv hochdrehen müssen. Für einen produktiven Arbeitsrechner ist diese Charakteristik deutlich wichtiger als kurzfristige Spitzenwerte in synthetischen Benchmarks.

GPU-Kühlung: Bewusst klassisch per Luft

Bei der Grafikkarte habe ich mich bewusst gegen eine Wasserkühlung entschieden und setze auf klassische Luftkühlung. Die gewählte GPU verfügt über ein solides Kühldesign, das für meinen Einsatzzweck vollkommen ausreichend ist.

Eine zusätzliche Wasserkühlung würde zwar optisch Akzente setzen, hätte jedoch keinen nennenswerten funktionalen Mehrwert. Stattdessen würde sie Komplexität, Wartungsaufwand und Fehlerpotenzial erhöhen – Aspekte, die ich bei einem produktiven System gezielt vermeiden möchte.

Airflow als verbindendes Element

Entscheidend ist das Zusammenspiel aus CPU-Flüssigkeitskühlung, GPU-Luftkühlung und einem durchdachten Airflow im Gehäuse. Das gewählte Case bietet hierfür sehr gute Voraussetzungen: klare Luftführung, ausreichend Platz für große Radiatoren und eine saubere Trennung von Frischluft- und Abluftzonen.

Diese Kombination sorgt dafür, dass sowohl CPU als auch GPU effizient gekühlt werden, ohne sich gegenseitig thermisch zu beeinflussen. Gleichzeitig bleibt das System leise – ein Faktor, der im täglichen Arbeiten mindestens genauso wichtig ist wie reine Leistungsdaten.

Fazit zur Kühlstrategie

Mit der be quiet! Silent Loop 3 (420 mm) für die CPU, klassischer Luftkühlung für die GPU und einem klar strukturierten Airflow verfolge ich eine bewährte, leise und auf Dauerlast ausgelegte Kühlstrategie. Sie passt ideal zu einem KI-Arbeitsrechner, der täglich im produktiven Einsatz steht und nicht durch Geräuschentwicklung oder thermische Instabilität auffallen soll.

Gehäuse und Airflow: Evolution statt radikaler Neuanfang

Beim Gehäuse habe ich mich bewusst für Kontinuität entschieden. In meiner aktuellen Build ist seit Jahren ein be quiet! Dark Base Pro 900 im Einsatz – ein Gehäuse, das sich im Alltag durch hohe Verarbeitungsqualität, flexible Layout-Optionen und sehr gute Geräuschdämmung bewährt hat. Vor diesem Hintergrund lag es nahe, beim Neuaufbau auf den direkten Nachfolger zu setzen und das Konzept weiterzuentwickeln, statt es grundsätzlich zu verändern.

Die Wahl: be quiet! Dark Base Pro 901

Mit dem be quiet! Dark Base Pro 901 greife ich ein vertrautes Gehäusekonzept auf, das an entscheidenden Stellen modernisiert wurde. Platzangebot, Airflow-Optionen und Modularität passen sehr gut zu meinem Anspruch an einen leisen, leistungsfähigen KI-Arbeitsrechner. Gleichzeitig bietet das Gehäuse ausreichend Raum für große Radiatoren, leistungsstarke Grafikkarten und ein sauberes Kabelmanagement – alles Faktoren, die sich unmittelbar auf Lautstärke und thermische Stabilität auswirken.

Für ein System, das täglich über viele Stunden hinweg unter meinem Schreibtisch arbeitet, ist diese Kombination aus Dämmung und kontrolliertem Luftstrom wichtiger als spektakuläre Designmerkmale.

Ein bewusster Stilbruch: Glas, LEDs – und eine offene Frage

Ganz ohne Zugeständnisse an aktuelle Designtrends komme ich bei dieser Build allerdings nicht aus. Im Gegensatz zum Dark Base Pro 900 gehört beim neuen Modell eine transparente Seitenwand zum Standard. Hinzu kommen ein umlaufendes LED-Farbband sowie der geplante CPU-Kühler von be quiet!, der ebenfalls RGB-Beleuchtung unterstützt.

Auf den ersten Blick steht das im Widerspruch zu meinen bisherigen Design-Prinzipien, die über Jahre hinweg von Zurückhaltung, Funktionalität und möglichst wenig visueller Ablenkung geprägt waren. Dieser Bruch ist mir bewusst – und er ist nicht das Ergebnis eines plötzlichen Sinneswandels, sondern vielmehr eine konsequente Begleiterscheinung moderner Gehäuse- und Kühllösungen. Wichtig ist dabei, dass sich alle Beleuchtungselemente dezent konfigurieren oder vollständig deaktivieren lassen. Solange sie sich im Hintergrund halten, bleibt der Fokus weiterhin klar auf Ruhe, Stabilität und Alltagstauglichkeit.

Ein familiärer Nebeneffekt

Ganz nebenbei hat diese Entscheidung noch eine soziale Komponente. Meine Tochter verfolgt den Aufbau meines neuen Systems mit großem Interesse. Dass nun auch mein Arbeitsrechner über Glas und dezente Beleuchtung verfügt, sorgt zumindest für Gesprächsstoff – und zeigt sehr anschaulich, wie unterschiedlich die Perspektiven auf Technik innerhalb eines Haushalts sein können.

Während für mich Funktion, Lautstärke und thermische Stabilität im Vordergrund stehen, spielen für sie Gestaltung und visuelle Akzente eine deutlich größere Rolle. Diese unterschiedlichen Blickwinkel greife ich später noch einmal gezielt auf, wenn es um die Frage geht, welche Rolle Show-Design bei einem Arbeitsrechner tatsächlich spielen sollte – und warum ich am Ende trotzdem bei der schwarzen Kiste bleibe.

Fazit zur Gehäusewahl

Mit dem Dark Base Pro 901 bleibe ich meiner Linie treu, entwickle sie aber behutsam weiter. Das Gehäuse bietet die funktionalen Eigenschaften, die ich für einen leisen KI-Arbeitsrechner benötige, erlaubt gleichzeitig aber auch moderne Akzente. Entscheidend ist, dass sich das Design jederzeit dem Zweck unterordnet – und nicht umgekehrt.

Stromversorgung: Reserven statt Grenzbetrieb

Die Wahl des Netzteils ist für mich weniger eine Frage der maximalen Wattzahl als vielmehr der sinnvollen Dimensionierung. Ein KI-Arbeitsrechner sollte stabil, effizient und leise arbeiten – und das nicht im Grenzbereich der Stromversorgung, sondern mit ausreichenden Reserven.

Abwägung der Optionen: 850 W, 1.000 W oder 1.200 W

In der engeren Auswahl standen bei mir drei Leistungsklassen:

- 850 Watt: Diese Variante habe ich relativ früh ausgeschlossen. Zwar würde sie die aktuelle Konfiguration rechnerisch abdecken, die Leistungsreserven wären jedoch knapp bemessen. Gerade bei gleichzeitiger CPU- und GPU-Last, wie sie bei KI-Workloads realistisch ist, möchte ich kein Netzteil dauerhaft im oberen Effizienzbereich betreiben.

- 1.200 Watt: Am anderen Ende des Spektrums ist diese Leistungsklasse für meine aktuelle Planung klar überdimensioniert. Sie wäre interessant, wenn perspektivisch sehr große GPUs oder mehrere Grafikkarten vorgesehen wären. Für die aktuelle Build hätte sie jedoch keinen funktionalen Mehrwert gebracht.

- 1.000 Watt: Diese Variante stellt für mich den sinnvollsten Mittelweg dar. Sie bietet ausreichend Reserve, arbeitet im Teillastbereich besonders effizient und bleibt auch unter Dauerlast leise.

Entsprechend habe ich mich für das be quiet! Dark Power 14 mit 1.000 Watt entschieden.

Leistungsaufnahme der geplanten Komponenten

Um diese Entscheidung nachvollziehbar zu machen, lohnt sich ein Blick auf die ungefähre Leistungsaufnahme der einzelnen Komponenten:

- CPU (Intel Core Ultra 9 285K): 250 W unter Volllast

- GPU (ASUS Prime RTX 5070 Ti): 300 W

- Mainboard / Chipsatz: 40–60 W

- Arbeitsspeicher (64 GB DDR5): 10–15 W

- NVMe-SSDs (2× Samsung 9100 PRO, 1× Samsung 990 PRO): 20–25 W

- Soundkarte (Creative Sound Blaster AE-7): 5–10 W

- CPU-Flüssigkeitskühlung (Pumpe + Lüfter): 10–15 W

- Gehäuselüfter / LED-Komponenten: 10–20 W

Gesamt unter realistischer Volllast: rund 650–700 Watt

Selbst bei gleichzeitiger Belastung aller relevanten Komponenten bleibt damit ausreichend Reserve nach oben. Das Netzteil arbeitet in einem Bereich, in dem Effizienz, Spannungsstabilität und Geräuschentwicklung optimal zusammenspielen.

Ein bewusster Verzicht: kein optisches Laufwerk

Bei dieser Build verzichte ich erstmals vollständig auf ein optisches Laufwerk. In meinem Arbeitsalltag spielen DVDs oder Blu-rays keine Rolle mehr, Installationsmedien werden längst über USB oder Netzwerke bereitgestellt.

Aus energetischer Sicht hätte ein optisches Laufwerk die Stromversorgung nur marginal belastet. Die Leistungsaufnahme solcher Komponenten ist im Vergleich zu CPU oder GPU vernachlässigbar und kein entscheidender Faktor bei der Dimensionierung des Netzteils. Der eigentliche Mehrwert des Verzichts liegt daher an anderer Stelle.

Ohne optisches Laufwerk wird das Gehäuselayout deutlich aufgeräumter. Der frei gewordene Platz erleichtert das Kabelmanagement, verbessert die Luftführung im Frontbereich und unterstützt einen gleichmäßigen Airflow durch das Gehäuse. Gerade in Kombination mit großen Radiatoren und einer auf Dauerlast ausgelegten Kühlstrategie ist dieser Punkt nicht zu unterschätzen.

Der Verzicht reduziert zudem mechanische Komplexität und potenzielle Geräuschquellen – ein kleiner Schritt, der sich im täglichen Betrieb positiv bemerkbar macht.

Fazit zur Netzteilwahl

Mit dem be quiet! Dark Power 14 (1.000 W) habe ich mich bewusst für eine ausgewogene Lösung entschieden. Das Netzteil bietet ausreichend Leistungsreserven für die aktuelle Konfiguration, bleibt effizient im Teillastbetrieb und lässt Spielraum für moderate Erweiterungen. Für einen leisen, stabilen und langfristig genutzten KI-Arbeitsrechner ist genau diese Balance entscheidend.

Audio-Setup: Kann man machen – bewusst entschieden

Beim Audio-Setup gilt für mich eine einfache Prämisse: Es ist kein zentrales Kriterium für einen KI-Arbeitsrechner, kann den täglichen Betrieb aber spürbar angenehmer machen. Moderne Mainboards wie das eingesetzte ASUS-Modell verfügen selbstverständlich über eine solide Onboard-Soundlösung, die für viele Anwender:innen vollkommen ausreichend ist. Dennoch habe ich mich bewusst für eine separate Soundkarte entschieden.

Warum überhaupt eine dedizierte Soundkarte?

Der ausschlaggebende Punkt ist weniger die reine Klangqualität als vielmehr die Flexibilität bei Ein- und Ausgängen sowie eine stabile, reproduzierbare Audio-Umgebung. In meinem Arbeitsalltag wechseln sich Online-Seminare, Videokonferenzen, Medienwiedergabe und gelegentlich auch kreative Nutzungsszenarien ab. In diesen Situationen schätze ich es, Audio gezielt steuern zu können, ohne auf Workarounds oder wechselnde Treiberkonfigurationen angewiesen zu sein.

Creative Sound Blaster AE-7 statt AE-9

In der engeren Auswahl stand neben der Creative Sound Blaster AE-7 auch das größere Modell AE-9. Dieses richtet sich klar an sehr anspruchsvolle Audio-Setups und bietet zusätzliche Features, die ich in meinem Alltag jedoch nicht benötige. Der deutliche Mehrpreis ließ sich für meine Anforderungen sachlich nicht rechtfertigen, weshalb ich mich bewusst gegen das Top-Modell entschieden habe.

Die AE-7 bietet genau das Maß an Funktionalität, das ich tatsächlich nutze: stabile Treiber, saubere Ausgänge und ausreichend Anschlussmöglichkeiten – ohne unnötige Komplexität.

Headset, Konferenzmikrofon, Lautsprecher und externe Audio-Hardware

Für Online-Seminare nutze ich situationsabhängig unterschiedliche Audiolösungen. Gelegentlich kommt ein Razer BlackShark V2 HyperSpeed zum Einsatz, das per USB angebunden ist und unabhängig von der internen Soundkarte arbeitet. In der Praxis greife ich jedoch meist auf ein USB-Konferenzmikrofon in Kombination mit meinen Creative GigaWorks T40 Series II Lautsprechern zurück.

Diese Kombination hat sich für längere Schulungstage als besonders angenehm erwiesen. Die Sprachqualität ist konstant, die Bedienung unkompliziert und ich vermeide das dauerhafte Tragen eines Headsets. Die Lautsprecher sind dabei direkt an die Creative Sound Blaster AE-7 angeschlossen, was für eine saubere und stabile Audioausgabe sorgt.

Gelegentlich schließe ich zudem mein iRig HD X an, um meine E-Gitarre direkt am Rechner zu nutzen. In diesen Szenarien sind flexible Ein- und Ausgänge sowie geringe Latenzen entscheidend. Auch hier spielt die dedizierte Soundkarte ihre Stärken aus und integriert sich problemlos in das bestehende Setup.

Fazit zum Audio-Setup

Eine dedizierte Soundkarte ist für einen KI-Arbeitsrechner kein Muss. In meinem Fall ist sie jedoch eine sinnvolle Ergänzung, die den Arbeitsalltag komfortabler macht und zusätzliche Nutzungsszenarien ermöglicht. Mit der Creative Sound Blaster AE-7 habe ich eine Lösung gewählt, die funktional, ausreichend leistungsfähig und wirtschaftlich sinnvoll ist – ganz ohne Anspruch auf audiophiles Overengineering.

Gesamtfazit zur Hardware-Konfiguration: Ein praxisnahes Beispiel, kein Dogma

Die hier vorgestellte Hardware-Konfiguration ist kein allgemeingültiges Rezept und erhebt keinen Anspruch auf Vollständigkeit oder Exklusivität. Sie spiegelt in erster Linie meine persönlichen Präferenzen, Erfahrungen und Prioritäten wider. Über viele Jahre hinweg habe ich mir ein klares Bild davon erarbeitet, welche Komponenten, Hersteller und Plattformen in meinem beruflichen Alltag zuverlässig funktionieren. Genau diese Erfahrungswerte fließen in die Auswahl ein.

Selbstverständlich lassen sich Copilot+-ähnliche Systeme auch mit Komponenten anderer Hersteller realisieren. Dieses Kapitel soll daher weniger eine Kaufempfehlung sein als vielmehr eine Orientierung, welche Klassen von Hardware und welche architektonischen Überlegungen zu einem leistungsfähigen KI-Arbeitsrechner führen können.

Skalierbarkeit nach Budget und Anspruch

Ein weiterer zentraler Punkt ist die Skalierbarkeit dieses Setups. Die vorgestellte Konfiguration ist bewusst so gewählt, dass sie weder das absolute Minimum noch das technisch Machbare ausreizt. Wer stärker auf das Budget achten muss, kann an mehreren Stellen Abstriche vornehmen, ohne das grundsätzliche Konzept zu gefährden. Gleichzeitig lässt sich das System problemlos nach oben erweitern, etwa durch leistungsstärkere GPUs, mehr Arbeitsspeicher oder zusätzliche Storage-Kapazitäten.

Wir bewegen uns mit dieser Build bewusst nicht am technischen Limit. Vielmehr handelt es sich um eine ausgewogene Zusammenstellung, die genügend Leistungsreserven bietet, ohne in eine Klasse vorzustoßen, in der Kosten und Nutzen nicht mehr in einem sinnvollen Verhältnis stehen.

Transparenz und Unabhängigkeit

Die Nennung der einzelnen Komponenten und Hersteller erfolgt ausschließlich aus inhaltlichen Gründen. Ich werde weder von den genannten Firmen bezahlt, noch stehen mir diese Unternehmen in irgendeiner Form nahe. Alle Komponenten wurden regulär erworben und nicht gesponsert, bereitgestellt oder vergünstigt überlassen.

Diese Transparenz ist mir wichtig, da sie die Grundlage für eine glaubwürdige und unabhängige Bewertung bildet. Die Auswahl basiert allein auf technischen Eigenschaften, persönlicher Erfahrung und dem konkreten Einsatzzweck dieses Systems.

Ein praktisches Beispiel für einen Copilot+-ähnlichen DIY-PC

Insgesamt ist dieses Kapitel als praktisches Beispiel gedacht, wie sich ein Copilot+-ähnlicher PC aus eigener Initiative planen und umsetzen lässt. Es zeigt, dass man nicht auf vorgefertigte OEM-Systeme angewiesen ist, um moderne Windows-11-KI-Funktionen, lokale Modelle und NPU-beschleunigte Workflows sinnvoll zu nutzen.

Der Weg über ein selbst konzipiertes System erfordert mehr Planung und Auseinandersetzung mit der Technik, bietet dafür aber genau die Freiheit, die ich an einem DIY-Ansatz schätze: Kontrolle über die Architektur, Anpassbarkeit an den eigenen Arbeitsstil und eine langfristig tragfähige Plattform für die kommenden Jahre.

Nachdem die Komponentenwahl nun transparent nachvollziehbar ist, folgt der nächste logische Schritt: der praktische Aufbau. Gerade bei einem KI-Arbeitsrechner entscheidet nicht nur die Auswahl der Hardware, sondern auch die saubere Umsetzung. Montage, Kabelmanagement, Luftführung und eine kontrollierte Inbetriebnahme beeinflussen Stabilität, Temperaturverhalten und Lautstärke im späteren Betrieb.

Im folgenden Abschnitt gehe ich daher Schritt für Schritt durch den Aufbau des Systems. Dabei geht es nicht um Show-Effekte, sondern um saubere Praxis: eine klare Reihenfolge beim Einbau, sinnvolle Prüfungen nach jedem Meilenstein und ein Aufbau, der die spätere Wartung und Erweiterung erleichtert. So entsteht aus einer durchdachten Konfiguration ein zuverlässiger Arbeitsrechner, der im Alltag genauso überzeugt wie auf dem Papier.

Schritt für Schritt: Wir bauen das System

Nach der Analyse der Architektur und der passenden Komponenten beginnt nun der eigentliche praktische Teil: der Aufbau meines eigenen Copilot+ PCs. Für mich ist dieser Prozess mehr als nur ein technisches Routineprojekt. Zum Jahreswechsel nutze ich bewusst die Gelegenheit, mein Arbeitsgerät neu zu denken und so auszulegen, dass es die Anforderungen einer KI-getriebenen Zukunft erfüllt. Daher plane ich mein System so, dass es sowohl lokale Modelle effizient ausführen kann als auch genügend Reserven für die kommenden Windows-11-Generationen besitzt.

Dieser Abschnitt beschreibt den kompletten Ablauf von der Planung über den Zusammenbau bis hin zur ersten Inbetriebnahme. Ich orientiere mich dabei an den Erfahrungen, die ich über Jahre beim Bau eigener Systeme gesammelt habe, und kombiniere diese mit den heutigen Anforderungen an KI-optimierte Hardware.

Komponentenplanung: Vom Warenkorb zur finalen Konfiguration

Bevor ich auch nur eine Schraube bewege, erstelle ich eine präzise Komponentenliste. Diese Planung ist entscheidend, da die Interaktionen zwischen CPU, GPU, NPU, RAM und SSD die KI-Performance maßgeblich bestimmen.

Die Grundprinzipien meiner Planung:

- NPU-Leistung als zentrales Kriterium

- RAM-Takt und Kapazität als Baseline für lokale Modelle

- NVMe-IOPS und Latenzen für Recall und Vision-Pipelines

- Mainboard-Layout für gute Luftwege und ausreichend PCIe-Lanes

- Kühlkapazität für dauerhafte KI-Lasten

- Netzteil mit hoher Effizienz für langfristige Stabilität

Diese Herangehensweise unterscheidet sich deutlich von klassischen Desktop-Builds. Der Fokus verschiebt sich vom reinen CPU-Takt und GPU-Benchmark hin zu einer ausgewogenen Architektur.

Vorbereitung des Arbeitsplatzes: Ordnung und Struktur

Klingt trivial, ist aber entscheidend: Ein sauber vorbereiteter Arbeitsplatz reduziert Fehler, Stress und Schäden an den Komponenten.

Was ich vorbereitet habe:

- antistatische Unterlage

- großer Tisch mit ausreichend Tiefe

- magnetisches Schraubenfach

- Druckluftspray und Pinsel

- USB-Stick mit aktuellem Windows-11-Installationsmedium

- neueste Mainboard-BIOS-Version auf einem zweiten Stick

Gerade weil moderne CPU-Sockel, DDR5-Slots und M.2-Schächte sehr empfindlich sind, hilft ein strukturierter Aufbau enorm.

CPU, Kühler und Mainboard: Der Startpunkt des Builds

Ich beginne grundsätzlich mit dem Mainboard außerhalb des Gehäuses. Das macht die ersten Schritte deutlich einfacher.

Ablauf:

- CPU vorsichtig einsetzen

- Wärmeleitpaste auftragen

- Luft- oder Wasserkühler montieren

- RAM-Module in die empfohlenen Slots setzen

- NVMe-SSD einsetzen, mit Kühlkörpern bestücken

- Erste Bareboard-Startprobe durchführen

Gerade die kurze externe Startprobe ist sinnvoll, um:

- DOA-Komponenten auszuschließen

- BIOS-Versionen zu prüfen

- RAM-Kompatibilität zu testen

Dies spart später ggfls. viel Aufwand.

Montage im Gehäuse: Luftwege und Thermik optimieren

KI-Workloads erzeugen eine gleichmäßige Dauerlast, die thermisch anspruchsvoll ist. Daher plane ich das Gehäuse so, dass Luftwege klar definiert sind und sich kein Wärmestau bildet.

Worauf ich achte:

- Front-Intake mit hohem Airflow

- Separation von GPU- und CPU-Luftstrom

- Ausreichend Platz für Kabelmanagement

- AiO-Radiator oben oder vorn, je nach Gehäuse

- Lüfterkurven, die Dauerlast berücksichtigen

Diese Maßnahmen erhöhen nicht nur die Leistung, sondern auch die Lebensdauer der Komponenten.

Exkurs: Beleuchtung, Show-Design – und warum ich trotzdem eine schwarze Kiste bevorzuge

Wer sich heute mit dem Selbstbau von PCs beschäftigt, stößt schnell auf eine Welt aus RGB-LEDs, Glas-Seitenteilen, farbiger Kühlflüssigkeit und aufwendig inszenierten Innenräumen. Für viele Enthusiast:innen ist der Rechner längst nicht mehr nur ein Arbeitsmittel, sondern auch Ausdruck von Kreativität und Individualität. Plattformen wie YouTube oder Reddit zeigen Builds, die bewusst visuell wirken und technische Funktion mit Design verbinden.

Diese Entwicklung ist nachvollziehbar und technisch durchaus beeindruckend. Moderne Komponenten eröffnen gestalterische Möglichkeiten, die es früher schlicht nicht gab. Auch ich nehme diese Vielfalt wahr – und nutze sie in diesem Build teilweise bewusst. Gleichzeitig bleibt für mich die Frage entscheidend, welchen Stellenwert Design bei einem produktiven Arbeitsrechner tatsächlich haben sollte.

RGB, Glas und Custom-Loops: Möglichkeiten statt Notwendigkeiten

Viele aktuelle Builds setzen gezielt auf:

- adressierbare RGB-Lüfter

- Temperglas-Seitenwände

- farblich akzentuierte Kühlkomponenten

- visuell strukturierte Kabelwege

- durchdesignte Innenräume

All das kann ästhetisch sehr ansprechend sein. Für die reine Leistungsfähigkeit, Stabilität oder Alltagstauglichkeit eines Systems ist es jedoch in den meisten Fällen nicht erforderlich. Gerade komplexe Beleuchtungs- oder Custom-Wasserkühlungs-Setups erhöhen tendenziell die Komplexität eines Systems – und damit auch Wartungsaufwand und potenzielle Fehlerquellen.

Für einen Rechner, der täglich mehrere Stunden produktiv genutzt wird, ist das für mich ein relevanter Aspekt.

Warum für meinen KI-Arbeitsrechner andere Prioritäten gelten

Bei einem Copilot+-ähnlichen System stehen für mich zwei Kriterien klar im Vordergrund:

- Geringe Lautstärke: KI-Workloads erzeugen häufig eine gleichmäßige, länger anhaltende Last. In solchen Szenarien ist eine leise, gut abgestimmte Kühlung wichtiger als visuelle Effekte. Große Radiatoren, langsam drehende Lüfter und ein sauberer Airflow wirken sich im Alltag deutlich positiver aus als animierte Beleuchtung.

- Robustheit und Übersichtlichkeit: Ein klar strukturierter Innenraum, ein gedämmtes Gehäuse und eine reduzierte Gestaltung machen ein System:

- wartungsfreundlicher

- langlebiger

- besser beherrschbar im Dauerbetrieb

Dieser Ansatz ist weniger spektakulär, aber genau auf die Anforderungen eines Arbeitsrechners zugeschnitten.

Workstation statt Kunstobjekt – mit bewusstem Spielraum

Mein Copilot+-PC ist in erster Linie ein Arbeitsinstrument. Er steht unter dem Schreibtisch, läuft oft den ganzen Tag und soll dabei möglichst unauffällig funktionieren. In dieser Rolle orientiere ich mich eher an klassischen Workstation-Konzepten als an Show-Builds.